![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

R および RjpWiki に関する質問コーナー

過去の記事のアーカイブ

Q&A (初級者コース)/13 の目次

asap (2012-01-12 (木) 18:36:36)

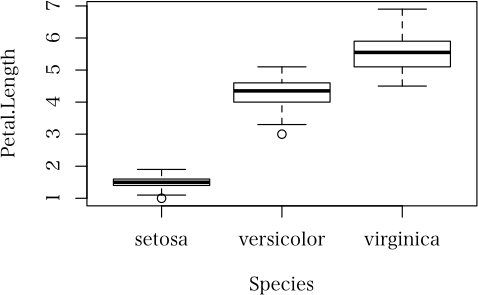

今ある行列irisに、n列の場合分けに応じた新しい列を追加したいのですが、どのようにすればよいでしょうか

新しい列の変数には次のような値を入れたいのですがif (iris$Species[i] == "setosa") { iris$Sp[i] <- 1 } else { iris$Sp[i] <- 0 }

まち (2012-01-11 (水) 21:49:52)

geoRパッケージのvariogで標本バリオグラムの計算を行うと最大距離を持つポイントが省かれてしまいます。

同じデータでgstatパッケージvariogramを使うと省かれません。

パラメータの指定が悪いのでしょうか?

自己相関が無くなる距離なので推定には問題ないと思いますが気になります。

よろしくお願いします。library(geoR) library(gstat) # データの読み込み data(ca20) # geoR vcloud <- variog(ca20) (vcloud) plot(vcloud) # gstat ca20gstat <- cbind(ca20$coords[, "east"], ca20$coords[, "north"], ca20$data) colnames(ca20gstat) <- c("east", "north", "data") ca20gstat <- as.data.frame(ca20gstat) vfgstat <- variogram(data ~ 1, loc = ~east+north, data = ca20gstat, cutoff = vcloud$max.dist, width = vcloud$max.dist / 13) (vfgstat) plot(vfgstat)下記の 13 行目で geoR の場合 $n が 12 点でなく 11 点になってしまいます。

geoRの場合$n $u $v 1 543 43.77376 55.50552 2 1648 131.3213 78.09254 3 2364 218.8688 97.05838 4 2246 306.4163 117.1554 5 2531 393.9638 129.0646 6 2152 481.5114 146.4889 7 1708 569.0589 151.9713 8 1309 656.6064 153.6482 9 694 744.1539 144.7442 10 343 831.7014 146.8878 11 144 919.249 131.8958 12 59 1006.796 139.2288 13 11 1094.344 139.2727gstatの場合

np dist gamma 1 543 60.35719 55.50552 2 1648 132.58886 78.09254 3 2364 220.90992 97.05838 4 2246 305.65494 117.15539 5 2531 391.80321 129.06460 6 2152 482.02453 146.48885 7 1708 568.46999 151.97131 8 1309 652.62969 153.64820 9 694 739.59074 144.74424 10 343 826.14460 146.88776 11 144 913.61963 131.89583 12 59 995.10190 139.22881 13 12 1082.94416 165.16667使用環境

R version 2.12.1 (2010-12-16) Platform: i386-pc-mingw32/i386 (32-bit) gstat_1.0-8 geoR_1.6-35

hiro (2012-01-10 (火) 16:39:38)

R-2.14.1 for Windows(32bit)を使っています.

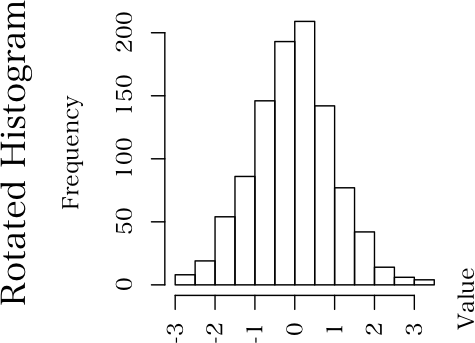

R-2.13.2までは、以下のサンプルでスライダーを動かすと、グラフはヒストグラムとカーネル密度共に滑らかに表示されます.

しかし、2.14以降、スライダーを動かしている間は一部のグラフが表示されなくなりました.この例ではカーネル密度が時々消えます.

グラフが複雑化すると、目立って見苦しくなります.

複数のWindowsPC(XP/Win7)で試しましたが、100%再現します.

もし解決策を御存知の方がいらっしゃれば、ご教示頂けないでしょうか.

宜しくお願いします.library(tcltk) draw.graph <- function(...) { upper <- as.double(tclvalue(Slider)) hist(x, freq = FALSE, ylim = c(0, upper), col = "cyan", border = "white") lines(den, lwd = 3) } x <- rnorm(200) den <- density(x) tt <- tktoplevel() Slider <- tclVar("0.5") slider <- tkscale(tt, from = 0.1, to = 1, resolution = 0.01, showvalue = TRUE, variable = Slider, orient = "horizontal", command = draw.graph) tkgrid(tklabel(tt, text = "upper"), sticky = "w") tkgrid(slider) tkfocus(tt)

kate (2012-01-06 (金) 17:47:23)

メモリーのエラーがでます。エラー: サイズ 176.4 Mb のベクトルを割り当てることができません > memory.limit() [1] 2047 > memory.size() [1] 817.03上記のエラーを疑問に思うのですが、2047MBの割り当てに対して、現在817MB使用で、あと約1200MB使えるという認識は違うのでしょうか?解決策を教えていただけないでしょうか

Win vista 32bit ,R2.14.1です。

Yasu (2012-01-05 (木) 14:41:54)

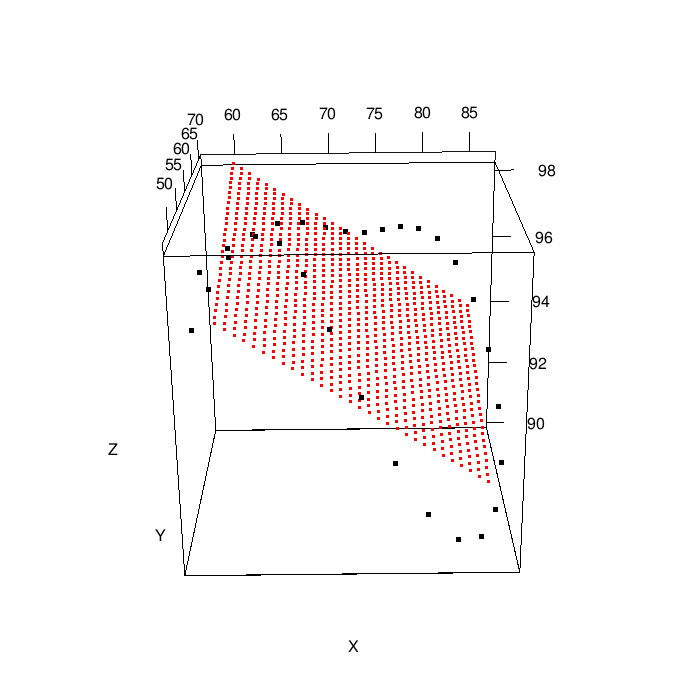

データとして(東経,北緯,高さ,値)の3次元空間の座標値と属性値からなるものを解析対象としています。

このデータに対して,東経,北緯,高さから計算される2点間の距離を尺度としてバリオグラムを計算したいのですが,どのようにすれば良いのか分かりません。

東経,北緯から計算される距離を用いたバリオグラムの計算はできました。

> data(meuse) > variogram(log(zinc) ~ x + y + elev, meuse)

manabe (2012-01-05 (木) 14:11:49)

month <- c("1月", "2月", "3月", "4月", "5月", "6月", "7月", "8月", "9月", "10月", "11月", "12月")全ての『月』の文字を取り除くにはどのようにすれば良いのでしょうか?

逆に、1:12を使って上記のベクトルを作るにはどのようにすれば良いのでしょうか?

ぞうに (2012-01-05 (木) 01:54:36)

いくつかのデータセットがあり各変数のlevels()を求めたいのですが,for文を使ってはできないのでしょうか?よろしくお願いします.

例えば,以下のデータセットがありますsex <- c("F", "F", "M", "M", "M") height <- c(158, 162, 177, 173, 166) weight <- c(50, 50, 60, 60, 70) ( x <- data.frame(SEX=sex, HEIGHT=height, WEIGHT=weight) )求めたいことは以下の事なのですが,

levels(factor(x$SEX)) levels(factor(x$HEIGHT)) levels(factor(x$WEIGHT))イメージとしては以下のような形で求めたいのですが,うまくいきません.for文を使ってできないでしょうか?

colname <- names(x) for(i in 1:3) { levels(factor(x$colname[i])) }以下,参考にしましたが解決できませんでした

http://q.hatena.ne.jp/1316156944

- x[, colname[i]]とすればいいのです。もっといえばx[, i]でOK。そもそもforを使わずにlapply(lapply(x,factor),levels)でもOKでは? -- 2012-01-05 (木) 02:03:17

- 解決しました.特に後者が参考になりました.どうもありがとうございました -- ぞうに 2012-01-05 (木) 03:10:50

- lapply を二重に使うのは初めてみました。sapply(x, function(z) levels(factor(z))) の方がわかりやすいかな。 -- 2012-01-05 (木) 10:23:55

Aizawa (2012-01-03 (火) 00:30:20)

functionの使用方法が理解できず悩んでいます。

abc <- function()(print("ABC")) と関数定義をすれば、> abcと入力した時点でprint("ABC")が実行されて"ABC"と返ってきそうな気がします。しかし、実際には、function()(print("ABC"))、と返ってきます。これだと、abcにfunction以下の文字式が代入されているだけに想えます。print文が関数として登録されているのではないようでしょうか。何か、関数定義に関して基本的なことを勘違いしているように想われます。全く初歩的な質問で恐縮ですが、どなたか疑問を解いて頂けると嬉しいです。

> abc <- function() (print("ABC"))

> abc()

[1] "ABC"

[1] "ABC"

> abc <- function() {print("ABC")}

> abc()

[1] "ABC"

> abc <- function() print("ABC")

> abc()

[1] "ABC"> (a <- 999) [1] 999 > print(a <- 999) [1] 999

Q&A (初級者コース)/13 http://www.okada.jp.org/RWiki/?%A3%D1%A1%F5%A3%C1%20%28%BD%E9%B5%E9%BC%D4%A5%B3%A1%BC%A5%B9%29%2F13 [ トップ | Tips紹介 | 中級Q&A | 初級Q&A | R掲示板 | 日本語化掲示板 | リンク集 ] [ リロード ] [ 新規 | 編集 | 凍結 | 差分 | ファイル添付 ] [ 一覧 | 検索 | 単語検索 | 最終更新 | バックアップ | ヘルプ ]やり損なった不細工な投稿も編集できる。 -- 河童の屁は,河童にあらず,屁である。 2012-01-08 (日) 23:05:43

MasHARA (2011-12-30 (金) 20:55:44)

Rのroundで小数第2位を丸めるために、round(1.05,1) を実行すると、日本の四捨五入とは異なり、1.1ではなく、1.0になります。

これは、切り上げ後の値の末尾の数字が偶数になるようにする、「JIS Z 8401」の2.c)で決められている丸め方のようですが、Rのプログラミングの練習を兼ねて、自分で四捨五入のための関数を作ることにしました。 正の数のみを扱うものとして、以下のような関数を作りました。> gonyu <- function(x, digits = 0) { > ceiling(x * 10 ^ digits) * 10 ^ (-digits) - + round(ceiling(x * 10 ^ digits) * + 10 ^ (-digits) - x, digits) > }作業環境は、Windows XP SP3で、version 2.13.0のRを使用しています。

この関数を試したところ、ほとんどの場合は問題なく四捨五入になりますが、時々、以下のように四捨五入にならない場合が発生しました。

例えば、関数の定義後、次の式を評価すると、> gonyu(1.45, 1)返ってきた値は、1.4 でした。

> gonyu(2.45,1)であれば、ちゃんと 2.5 が帰ってきます。そこで、問題の発生した

> x <- 1.45 > digits <- 1としてから、関数の中を一つ一つ見ていきました、すると、

> ceiling(x * 10 ^ digits) * 10 ^ (-digits) - xが 0.05 を返すものの、

> round(ceiling(x * 10 ^ digits) * 10 ^ (-digits) - x, digits)は、なんと 0.1 を返したのです。

> round(ceiling(1.45 * 10 ^ 1) * 10 ^ (-1) - 1.45, 1)も、なぜか0.1を返してきます。

> round(0.05, 1)を実行すれば、ちゃんと、0 (ゼロ)を返してきます。

> ceiling(1.45 * 10 ^ 1) * 10 ^ (-1) - 1.45は 0.05 を返してくるが、表示されていない桁で誤差を含むのでは、と思い、

> ceiling(1.45 * 10 ^ 1) * 10 ^ (-1) - 1.45 - 0.05を実行すると、返された値は、4.163336e-17 でした。

後ろにある引き算、2つをカッコでまとめて、> ceiling(1.45 * 10 ^ 1) * 10 ^ (-1) - (1.45 + 0.05)とすると、返される数字は、ちゃんと 0 です。

一体、この表示されない誤差は生じたり、生じなかったりするのでしょう。御存じの方が居られれば、御教授のほど、御願い申し上げます。

> func <- function(x, n)

+ {

+ a <- x * 10 ^ (n + 1)

+ b <- a - floor(a / 10 ^ n) * 10 ^ n

+ return(round(a + 5 * (b >= 5), -1) / 10 ^ (n + 1))

+ }

> func(1.45, 1)

[1] 1.5

> func(1.449999999999999, 1)

[1] 1.4

> func(2.5, 1)

[1] 2.5

> func(2.449999999999999, 1)

[1] 2.4takayuki (2011-12-27 (火) 20:39:17)

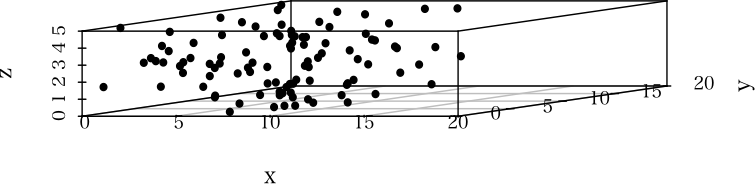

3次元の散布図を書くのに,scatterplot3dを使用しています。Z軸についてグラフを回転させたいのですがそのようなことは可能でしょうか。もし可能であればご教授お願い致します。

Montecarlo (2011-12-26 (月) 19:35:10)

現在では以下のマウス操作またはショートカットにてコンソール画面を消去することが出来る事は確認しています。「編集」→「コンソール画面を消去」 または 「Ctrl」+「L」この作業をスクリプトの命令から再現することは出来ますでしょうか。

ご存じの方がいらっしゃいましたら、よろしくお願い致します。

(2011-12-22 (木) 17:40:53)

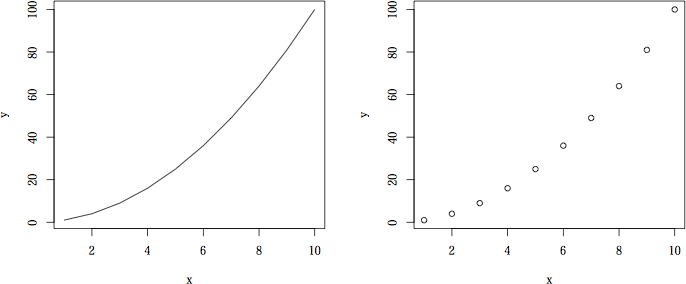

回帰解析をしたいのですが、plot(x,y) を見ていたら、ガンマ分布の pdf を当てはめてみたくなりました。2つパラメータがありますが、それぞれを最小二乗法で求めるにはどうしたらいいのですか?

さらに、例えば勝手に自分が作った関数のパラメータを使うことも可能ですか?でっちあげの例ですが、y <- function(x,a,b){ log(a*x + x^-(a/(2*b)) }として、x と y が与えられた時に、a と b を推定したいということです。

よろしくお願いします。

T (2011-12-21 (水) 20:02:30)

超初心者質問で大変恐縮なのですが、ヘルプを読んでも解決せず、質問します。

例えば、matplot(outer(1:5, 1:3), type="b", pch=1:3, lty=1:3) legend("topleft", LETTERS[1:3], pch=1:3, lty=1:3, col=1:3, seg.len=4)とすると、左上に凡例が表示されますが、線にシンボルが上書きされた type="o" のような表示になります。

グラフは type="b" で描いていますので、凡例も同様にしたいのですが、legend() のヘルプを読む限りは、type="b" と同じ表現になるオプションはないようです。

もちろん、legend(..., type="b") とすると、エラーになります。

上記 2 行の出力画像を貼った方がよければ貼ります。

ヘルプの見落としのような気もいたしますが、よろしくお願いします。

matplot(outer(1:5, 1:3), type="b", pch=1:3, lty=1:3)

a <- legend("topleft", LETTERS[1:3], pch=1:3, lty=1:3,

col=1:3, seg.len=4, plot=FALSE)

i <- par("cxy")

sapply(1:3, function(j) {

with(a, {

segments(rect$left+i[1]/2, text$y[j], rect$left+i[1]*1.9,

text$y[j], col=j, lty=j)

segments(rect$left+i[1]*3.1, text$y[j], rect$left+i[1]*4.5,

text$y[j], col=j, lty=j)})

})

points(rep(a$rect$left+i[1]*2.5, 3), a$text$y, pch=1:3, col=1:3)

text(a$text$x, a$text$y, LETTERS[1:3])

with(a$rect, lines(c(left+w, left+w, left), c(top, top-h, top-h)))Montecarlo (2011-12-21 (水) 18:10:04)

文字列を表示する「cat」関数があると思いますが、大文字小文字のアルファベットを調べたところ、以下3個の文字が何を表しているかGoogle等で調べてみても分かりませんでした。

「\b」「\r」「\v」

実行コードcat("\a") #音が鳴る cat("\b") #不明 cat("\f") #フィード文字(半角スペース?) cat("\n") #改行 cat("\r") #不明 cat("\t") #タブ cat("\v") #不明(半角スペース?)この3個特殊文字の意味をご回答頂ければ幸いです。よろしくお願い致します。

いぬ (2011-12-21 (水) 10:18:21)

成績が勉強時間の2乗に比例しているのか3乗に比例するのか調べたいです。

式としては

y=a0+a1*x+a2*x^2

y=a0+a1*x+a2*x^2+a3*x^3

という式です。

手元の資料からは決定係数と調整済みの決定係数が1に近い方がいい、特に調整済みの決定係数が近いほうがいいと読み取れます。

また、t検定、F検定、AICも見たほうがいいと思うのです。

どれを1番優先してみればいいのでしょうか?

それとも違うものを見たほうがいいのでしょうか?

どなたか教えてください。

あとRでanovaの結果の見方がわかりませんので教えていただきたいです。

ほし (2011-12-21 (水) 00:13:46)

初めて投稿させていただきます。

パッケージVeganのRDAを用いた解析・解釈に苦戦しております。

20以上のデータを用いて解析を行い、plotで表にしました。

しかし、表には4つ程のデータ名しか表示されません。

また、summaryで詳細な情報を見ても、表示されたデータ名についてしか書かれていません。

これは、表示されなかったデータは取るに足らないデータであったということなのでしょうか?

初歩的な質問で恐縮ですが、どなたかアドバイスの程よろしくお願いいたします。

> plotで表にしました。

plotで表にするとはどういうことでしょうか。グラフではないのですか?

rda関数のExamplesを実行してみても表にはなりませんが。

> データ名 というのは具体的に何を指しているのでしょうか。 -- Iona 2011-12-21 (水) 06:17:14

> test <- read.csv("sample.csv", header=TRUE, row.names="x")

> testa <- read.csv("sample.csv", header=TRUE, row.names="x")

> testb.rda <- rda(test~.testa, nangteng, scale=TRUE)

> testb.rda

ここで、次に表示される

Call:にはtestbのデータ名(エクセル第二行目からの第一列です。サンプル名といった方がよかったかもしれません。。)はすべて表示されますが、

> plot(testb.rda)によってグラフ(表ではなくグラフでした。申し訳ありません。)を表示したところ、testbのデータだけ質問のようになってしまいます。

rda(x ~ z$y)を

rda(x ~ y, data = z)と書けるというものです。

dune.Manure <- rda(dune ~ Manure, data = dune.env) dune.Manureでは、dune.envの行名は表示されませんが、summary()の間違いではないですか? でも、一度目の投稿によるとsummary()では表示されないんですよね? -- Iona 2011-12-22 (木) 00:51:45

S (2011-12-20 (火) 18:14:37)

表を作って平均をとろうとすると、次のような警告がでます。mean(<data.frame>) is deprecatedR2.13では出なかったのですが、R2.14で出るようになったと思います。これは何でしょうか?

> mean(iris[,1:4])

Sepal.Length Sepal.Width Petal.Length Petal.Width

5.843333 3.057333 3.758000 1.199333

警告メッセージ:

mean(<data.frame>) is deprecated.

Use colMeans() or sapply(*, mean) instead. # これからは,こうしてね!という示唆

> colMeans(iris[,1:4]) # つまり,こんな風にとか

Sepal.Length Sepal.Width Petal.Length Petal.Width

5.843333 3.057333 3.758000 1.199333

> sapply(iris[,1:4], mean) # こんな風にとか

Sepal.Length Sepal.Width Petal.Length Petal.Width

5.843333 3.057333 3.758000 1.199333

愚かなるユーザは,「エラーメッセージを出して,正解を出す」のなら,「エラーメッセージを出さずに正解を出せばいいじゃないか」と思うのです。お偉いさんは,何を考えているんだろうか。ストイックなんでしょうなぁ。でも,愚かなる衆生はそんなのに従わされなくても言いと思うのだけど。> mean.data.frame

function (x, ...)

{

msg <- "mean(<data.frame>) is deprecated.\n Use colMeans() or

sapply(*, mean) instead."

warning(paste(msg, collapse = ""), call. = FALSE, domain = NA)

sapply(X = x, FUN = mean, ...)

}

となっているわけだけど,

> mean.data.frame

function (x, ...)

{

sapply(X = x, FUN = mean, ...)

}

にすれば良いだけだろうと思うのだ!カス (2011-12-20 (火) 14:03:20)

offset項を入れた時の推定結果を図示するには、どのようにすればよいのでしょうか?

二項分布でリンク関数を"cloglog"にした場合と、ポアソン分布(リンク関数はデフォルトの"log")の場合についてご教授いただけないでしょうか?

例えば、二項分布でoffsetなしの場合、bi <- glm(y ~ x, family = binomial(link = "cloglog")) lines(x, 1-exp(-exp(b + a*x)))とすれば良いと思うのですが、二項分布でoffsetありの場合

bioff <- glm(x ~ y + offset(log(z)), family = binomial(link ="cloglog"))この推定結果の図示はどのようにすればよいでしょうか?

また、同様にポアソン分布でオフセットなしの場合、po <- glm(y ~ x, family = poisson) lines(x, exp(b+ax))とすればよいと思うのですが、

pooff <- glm(y ~ x + offset(log(z)), family = poisson)の場合はどうでしょうか? よろしくお願い致します。

matak (2011-12-15 (木) 12:15:41)

CSVファイルを例えば、> data <- read.csv("read_sample.csv", header=TRUE, row.names=1)という風に読み込んだ時、CSVファイルの一番左上のセルだけ読み込まれないですよねぇ。

結果、読み込んだ行列で何らかの演算を行って、書き込んだCSVファイルも一番左上のセルが空白になってしまいます。

どうすれば一番左上のセルも読み込み&書き込みできるでしょうか。

読み込むCSVファイルの1行目および1列目は文字列で、第2行第2列目以降から数値データなので、header=TRUE, row.names=1で読み込んだ方が都合がいいのですが。

data <- read.csv("sample.csv")

data[, -1] <- function(data[, -1])

write.csv(data)Montecarlo (2011-12-12 (月) 21:25:13)

初の投稿で、なにぶん至らない点があるかと思いますがよろしくお願いします。

使用環境は以下です。R version 2.14.0 (2011-10-31) Platform: i386-pc-mingw32/i386 (32-bit) locale: [1] LC_COLLATE=Japanese_Japan.932 LC_CTYPE=Japanese_Japan.932 [3] LC_MONETARY=Japanese_Japan.932 LC_NUMERIC=C [5] LC_TIME=Japanese_Japan.932 attached base packages: [1] stats graphics grDevices utils datasets methods base質問になりますが、行列の行に対してcumsumを適用することは出来るでしょうか?

> x <- c(1, 1, 1, 0, 0, 0, 0, 1, 1, 1, 1, 1, 0, 1, 1, 1, 1, 0, 1, 0, 1, 0, 0, 1, 0, 1, 1, 0, 1, 0, 0, 0, 0, 1, 1, 1, 0, 1, 1, 0, 0, 1, 1, 0, 0, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 0, 0, 1, 0, 0, 0, 1, 1, 1, 0, 1, 0, 0, 1, 1, 0, 0, 1, 1, 0, 0, 0, 0, 1, 1, 1, 0, 0) > y <- matrix(x, nrow=10, ncol=10, byrow=TRUE)を実行すると、私の意図通りに10*10の行列ができあがります。

ここからが詰まっているところです。

この「y」の行に対するcumsumを適用したいと思っています。

列に対するcumsumは> apply(y, 2, cumsum)によって計算出来ていることは確認しています。

ですが> apply(y, 1, cumsum)ではうまくいかないのです。(結果はapply(y, 2, cumsum)に似ていますが違った答えが返ってきます。)

質問事項としてまとめると以下の点となります。

1.行に対してcumsumを適用することは可能か(cumファミリー全般)

2.列はうまくいくのに行でうまくいかない事からすると、cumsumの挙動はどのようになっているのか

以上2点について分かる方がいらっしゃいましたらお願い致します。

> (y <- matrix(1:12, 3, 4))

[,1] [,2] [,3] [,4]

[1,] 1 4 7 10

[2,] 2 5 8 11

[3,] 3 6 9 12

> apply(y, 1, cumsum)

[,1] [,2] [,3]

[1,] 1 2 3

[2,] 5 7 9

[3,] 12 15 18

[4,] 22 26 30

> t(apply(y, 1, cumsum))

[,1] [,2] [,3] [,4]

[1,] 1 5 12 22

[2,] 2 7 15 26

[3,] 3 9 18 30

つまりのところ,t(apply(y, 1, cumsum))でよいでしょう。 -- 河童の屁は,河童にあらず,屁である。 2011-12-12 (月) 21:48:54Alin (2011-12-12 (月) 17:05:20)

C言語のint型、4バイト長のバイナリデータ(sample.bin)をreadBin関数を使って読み込もうとしているのですが、> conn <- file("sample.bin", "rb") > readBin(conn, integer(), n=100*100, size=4)のようにして読み込むと正常な値が読み込まれず(100*100はデータの要素数です)、

> readBin(conn, integer(), n=100*100, size=2)のようにして、sizeを2に指定すると、正常な値が読み込まれます。

これはRで扱うデータ型(?)の基本的な概念が、C言語等と異なっているからなのでしょうか?

vivaTS (2011-12-12 (月) 13:32:48)

R64 2.14.0 (Lion)を使用しています。

ccfで計算される2変数の時系列相関のp値, 95%信頼区間を求めるには,どのような方法があるのでしょうか。

波 (2011-12-06 (火) 17:13:05)

お世話になります。

CentOSにR 2.13.1をインストールし、プロキシサーバー経由でパッケージのアップデートをしようとしています。

Rのインストールディレクトリに以下のコマンドを記述した.Rprofileを保存しているのですが、update.packeges()で「HTTPステータスは407 Proxy Authentication Requiredです」といわれて接続できません。options(CRAN="http://cran.md.tsukuba.ac.jp/bin/windows/contrib/2.13") Sys.setenv("http_proxy"="http://(アドレス):(ポート番号)")また、.Rprofileを削除してRの起動直後の画面に上記のコマンドを入力しても接続できませんでした。

Windows XPのR 2.13.1ではマイドキュメントに上記の.Rprofileを保存することでアップデートが可能なことを確認しています。

Linuxの場合はWindowsと異なる設定が必要なのでしょうか?対応策をご存知であれば教えてください。

宜しくお願いします。

K (2011-12-06 (火) 10:29:04)

こんにちは。WinXP R 2.13.2を使用しています。

文字列ベクトルA,B,C・・・があり、これらに共通する要素を抽出したいと考えています。

例えば以下のような場合は"aaa"が共通しているので、"aaa"を抽出したいということです。A <- c("aaa","aaaa","aaaaa") B <- c("bbb","aaa","bbbbb") C <- c("aaa","ccc","cccc")実際には文字列ベクトルとその要素は数百個あります。apply()を使えばスマートに記述できそうな気はするのですが、どうにもできませんでした。

どなたか御助言を宜しくお願いします。

system.time({

### テストデータを作る

### 要素数 n=500 個のリスト

### 各要素は 503 個の要素を持つ文字列ベクトル

### テストのため最後の 3 つ, foo, bar, baz は全ベクトルに含まれる

### 各要素は 1 〜 5 文字からなる

set.seed(1234567)

n <- 500

k <- 500

d <- vector("list", n)

for (i in 1:n) {

str <- character(k)

for (j in seq_along(str)) {

str[j] <- paste(sample(letters,

sample(5, 1), replace=TRUE), sep="", collapse="")

}

d[[i]] <- c(str, "foo", "bar", "baz")

}

})

system.time({

### 重複する文字列の抽出

ans <- intersect(d[[1]], d[[2]])

for (i in 3:n) {

ans <- intersect(ans, d[[i]])

}

print(ans)

})

実行結果は

テストデータの作成にかかった時間

ユーザ システム 経過

9.297 0.257 9.508

共通要素

[1] "foo" "bar" "baz"

共通要素を抽出するのにかかった時間

ユーザ システム 経過

0.049 0.001 0.055ひろ (2011-12-05 (月) 12:55:27)

ヘッダに括弧が含まれるCSVから正しくヘッダを取得したいのですが,方法がわからずに困っております.

下記例ではファイル中のヘッダは「ほげ(ほげ)」なのですが,read.csvで読み込むと「ほげ.ほげ.」と括弧→.となり困っております.

もし改善方法をご存知でしたらご教示いただければ幸いです.

環境:win7 64bit + R 2.14.0 64bit

調べたこと:?read.csvや?read.tableの結果からparenthes,bracket(丸かっこ)の単語がないか.googleで本サイト(site:)指定/指定なしに対して,「括弧 R言語 ヘッダ名or列名」で調べてみました.

testCSV.csvの中身は下記通りです.ほげ(ほげ) 1 2 3

> read.csv("input/testCSV.csv", header=TRUE) ほげ.ほげ. 1 1 2 2 3 3

笹川よつ斗 (2011-12-05 (月) 12:42:13)

例えば、x <- data.frame( matrix(rnorm(500), ncol=10) ) names(x) <- c( sample(LETTERS[1:26], 9, FALSE), 'y' )というデータがあります。

column の名前の 'y' 以外を入力せずに lm() を使うことは可能でしょうか?

大きなデータフレームから column をサンプルして繰り返し解析する、ということを試しています。 for loop の中で応用することになります。 今のところ以下のようにやっていますが、もう少し簡潔な方法があるものかと思い投稿しました。f <- paste( 'y ~', paste(names(x)[1:9], collapse='+') ) lm( as.formula(f), data=x )

> x <- data.frame( matrix(rnorm(500),ncol=10) )

> lmtmp <- lm(X10 ~ ., data=x)

> step(lmtmp)

Start: AIC=-3.58

X10 ~ X1 + X2 + X3 + X4 + X5 + X6 + X7 + X8 + X9

Df Sum of Sq RSS AIC

- X7 1 0.0288 31.227 -5.5375

- X1 1 0.0427 31.241 -5.5154

- X2 1 0.0650 31.263 -5.4796

- X9 1 0.0659 31.264 -5.4783

- X4 1 0.0936 31.291 -5.4340

- X5 1 0.1595 31.357 -5.3287

- X3 1 0.4099 31.608 -4.9310

<none> 31.198 -3.5837

- X6 1 1.3648 32.563 -3.4429

- X8 1 8.1977 39.395 6.0814

(途中省略)

Step: AIC=-16.17 ### AIC基準で最終的に選ばれたモデル

X10 ~ X8

Df Sum of Sq RSS AIC

<none> 33.405 -16.1657

- X8 1 7.3309 40.736 -8.2455

Call:

lm(formula = X10 ~ X8, data = x)

Coefficients:

(Intercept) X8

-0.04151 0.39186> x <- data.frame(matrix(rnorm(10000),ncol=100))

> Formula <- unique(sapply(seq(10^4),FUN=function(i) paste("X100 ~ ",

paste(sort(sample(names(x)[-100],9)),collapse="+"))))

> res <- lapply(seq(10^4), FUN=function(i) lm(Formula[i],data=x))

> Formula[9999]; res[[9999]]

[1] "X100 ~ X20+X25+X30+X41+X55+X6+X68+X80+X99"

Call:

lm(formula = Formula[i], data = x)

Coefficients:

(Intercept) X20 X25 X30 X41 X55

0.054830 0.020898 0.036853 0.025012 -0.007347 -0.138181

X6 X68 X80 X99

0.013766 0.071437 -0.010897 0.083487

斉藤正 (2011-12-02 (金) 12:26:18)

これまで scatterplot3 を使って、計算結果を3次元表示していました。Rのバージョンを2.14.0に上げたら、> library(scatterplot3d) 以下にエラー library(scatterplot3d) : '‘scatterplot3d’' という名前のパッケージはありません : 関数 "scatterplot3d" を見つけることができませんでしたというエラーメッセージがでて、図が描けなくなりました。対処法をお教えください。

@garuby (2011-11-30 (水) 18:58:49)

すでに重回帰モデルやSVMモデルを作成しており、このモデルを使って新しいサンプルの目的変数を予測することを現在Rscriptで行なっています。この方法の場合、毎回重回帰モデルなどを保存したファイルをloadして、目的変数を予測させているので、いつも計算するのに時間がかかります。

計算する量は、サンプル数が1つしかない場合もありますし、10万を超える場合もあります。複数の人が利用するため頻度も多いです。

そこで、Rserveを使って最初にモデルをloadして予測ジョブごとでわざわざloadすることを避けられないか検討しています。ヘルプを見ますと、セッション番号を共有すれば何とかなりそうではないかと思っています。が、まったく分からず立ち往生しています。

このようなことはRserveで実現できるのでしょうか?あるいは他の方法で解決するのでしょうか?

さ (2011-11-29 (火) 19:09:19)

・Rでlm関数を使って分析をしました。summaryで結果を出したのですがEstimateの所の数字をどのようにとらえていいのかがわかりません。*の数も同じです。この数字や*は大きかったり、多いほうが相関関係があるのでしょうか?

・もうひとつstep関数も用いました。これはlm関数よりも詳しい値が出ると考えてよいのでしょうか?

・最後に題とは少し変わるのですが、目的変数が見付からないときにはなしでそれぞれの相関をもとめる(lm関数とstep関数を用いて)ことは可能でしょうか?例えば県ごとの脳梗塞の死亡率と癌の死亡率と糖尿病の死亡率しか出ていない場合です。県を目的変数にしようとしましたが、数字でないせいかエラーになりました。

どなたか教えてください。よろしくお願いします。

yyy (2011-11-29 (火) 15:30:47)

お世話になります.

例えば「3*x^2-4*x*y+3*x+6*y^2+8*y」のような2変数の最適化を行うにはどうすればよいのでしょうか.

uniroot()は1変数でしか使えませんよね?

どなたかご教示下さい.宜しくお願いします.

> f <- function(p) 3*p[1]^2-4*p[1]*p[2]+3*p[1]+6*p[2]^2+8*p[2] > nlm(f, c(1,1)) $minimum [1] -6.107143 $estimate [1] -1.214287 -1.071429 $gradient [1] 6.422047e-07 4.269174e-07 $code [1] 1 $iterations [1] 3

zoo (2011-11-29 (火) 11:55:26)

お世話になります。

・集合xと集合yがある

・サイズは x > y で、yはxに全て含まれる

・xに含まれるyをyの順番を維持したままxから抜き出したい

という処理をしようとしています。

たとえばx <- c("A","B","C","D","E") y <- c("D","E","B") x[x %in% y]このように入力すると「"B" "D" "E"」が得られますが、yの順番である「"D" "E""B"」として出力するにはどうすればよいでしょうか?

どなたかご教示ください。宜しくお願いします。

> x <- c("B","A","B","D","C","D","E")

> y <- c("D","E","B")

> unlist(sapply(y, function(ch) x[x==ch]))

D1 D2 E B1 B2

"D" "D" "E" "B" "B"> (x <- data.frame(str.x=LETTERS[1:5], num.x=1:5))

str.x num.x

1 A 1

2 B 2

3 C 3

4 D 4

5 E 5

> (y <- data.frame(str.y=c("D", "E", "B"), num.y=c(1,3,6)))

str.y num.y

1 D 1

2 E 3

3 B 6

> x[sapply(y$str.y, grep, x$str.x),]

str.x num.x

4 D 4

5 E 5

2 B 2m (2011-11-29 (火) 02:23:48)

Mac OS X(10.6.8)でR2.14.0を使用しています。plotがデフォルトの画面上(Quartz)では問題無いのですが、png()では文字化けしてしまいます。png("hoge.png", width=640, height=640, unit="px") plot(1,1) text(1,1,"ほげ") dev.off()こうすると「ほげ」部分が□□になってしまうのですが、何か見落としているためでしょうか?

ターミナルから「R」と入力して起動した場合も、Rのアプリケーション上の「Rコンソール」でも同じ結果になります。

よろしくお願いいたします。

png("test.png")

par(family="HiraMaruProN-W4")

hist(rnorm(10000), main="日本語を使う")

dev.off()shannon (2011-11-28 (月) 00:13:55)

既出でしたらすいません。

Rではデータ型がinteger(整数),numerical(実数),complex(複素数),character(文字)に分類されるとのことですが、

C言語などで使われるfloat(32bit),double(64bit)でビット幅を固定して、データを書き込むことはできないのでしょうか?

writeBin関数ではそのようなオプションがないように思うのですが、

書きこむ前のデータのビット幅を何らかの方法で固定して、その後writeBin関数で書き込む、という流れになるのでしょうか?

分かりにくい質問かもしれませんが、よろしくお願い致します。

> object.size(1L) 32 bytes > str(1L) int 1 > object.size(as.single(1L)) 120 bytes > str(as.single(1L)) atomic [1:1] 1 - attr(*, "Csingle")= logi TRUE > object.size(as.double(1L)) 32 bytes > str(as.double(1L)) num 1

QDY (2011-11-24 (木) 22:47:47)

最新バージョンのRには並列処理用のパッケージ parallel が同梱されています。特にマルチコアのパソコンでは便利だと思いますが、並列処理したい関数が(その関数にとっての)外部変数を含む場合はエラーになるようです。おそらく子プロセスが親プロセスの実行環境を知らないからだと思いますが(?). 関数の実行環境(外部変数)をすべての子プロセスで共有する簡単なおまじないがあるのでしょうか。(Linux, R2.14.0)> library(parallel) > cl <- makeCluster(rep("localhost", 4), type="SOCK") > y <- 3 > tmp <- function(x) x+y > clusterApply(cl, 1:4, tmp) 以下にエラー checkForRemoteErrors(val) : 4 nodes produced errors; first error: オブジェクト 'y' がありません > stopCluster(cl)

> library(parallel)

> cl <- makeCluster(rep("localhost", 4), type="SOCK") # 4つのコアで実行

> y <- 3

> tmp <- function(x) x+y

# すべての実行時環境オブジェクトを子プロセスにエクスポート。

# この例では clusterExport(cl,"y") で十分

> clusterExport(cl, ls())

> clusterApply(cl, 1:4, tmp)

[[1]]

[1] 4

[[2]]

[1] 5

[[3]]

[1] 6

[[4]]

[1] 7

> stopCluster(cl)

バイソン (2011-11-22 (火) 13:20:05)

Linux(CentOS5.5)上で、R version 2.11.1を使用しています。a = 1 cat(a,"\n")上のような内容のRファイル(test.r)を作成して、

> R --vanilla --quiet < test.rのようにして実行すると、コンソール上には実行コマンドとcat関数による出力の両方が表示されてしまいます。

=====コンソール表示====== > a = 1 > cat(a) 1 =========================cat関数で出力する値だけをコンソール画面に表示させたいのですが、R --helpを見てもそのようなオプションが無いように思います。

sink関数を使って、出力先を別ファイルに変更させて確認するという方法もあるとは思うのですが、 出力させたい部分で一回一回sink関数で囲うのが面倒なので、

できればRコマンドのコンソール出力を抑えて、cat関数等で出力させる値(上の例では1)のみをコンソールに表示できないものかと考えているのですが、良い方法はありますでしょうか?

> R --vanilla --slave < test.rのようにしても同じように出力が抑えられました。-- バイソン 2011-11-24 (木) 04:56:01

まあくん (2011-11-22 (火) 09:05:29)

タイトルの通りなんですが、関数persp()で軸のタイトル(xlab,ylab,zlab)が、角度によってお互いが重なってしまい、見にくくなってしまうので、文字サイズの変更もしくは、表示位置の微調整ができないでしょうか?

小田ちん (2011-11-19 (土) 00:51:34)

ggplot2を使いたいのですが、plyrのロードで失敗します。

MacのR64を使っています。どうすれば使えるようになるのでしょうか?

よろしくお願いいたします。> library(ggplot2) 要求されたパッケージ reshape をロード中です 要求されたパッケージ plyr をロード中です Error in dyn.load(file, DLLpath = DLLpath, ...) : 共有ライブラリ '/Library/Frameworks/R.framework/Versions/2.14/ Resources/library/plyr/>libs/x86_64/plyr.so' を読み込めません: dlopen(/Library/Frameworks/R.framework/Versions/2.14/Resources/ library/plyr/libs/x86_64/plyr.so, 6): Library not loaded: /Library/Frameworks/R.framework/Versions/2.13/Resources/lib/libR.dylib Referenced from: /Library/Frameworks/R.framework/Versions/ 2.14/Resources/library/plyr/libs/x86_64/plyr.so Reason: image not found エラー: パッケージ '‘plyr’' をロードできませんでした

T.I. (2011-11-16 (水) 07:11:07)

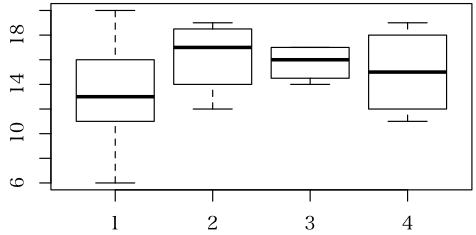

Rの初心者です。グラフの描き方に苦戦しております。

Boxプロットで、項目軸(X軸)を数値軸にしてグラフを描きたいのですが、方法をご存知の方がおられましたら、教えていただけないでしょうか?

set.seed(100) ; x <- sample(c(1,2,5,7), 200, TRUE) ; y <- rnorm(200) boxplot(y~x, at=sort(unique(x)), xlim=c(0,8))

yasushi (2011-11-15 (火) 18:56:52)

R初心者です。

次の2つの実行結果は同じになると思ったのですが,なりません(2番目の数値がおかしい)。> x <- matrix(c(1:4), nrow=2, ncol=2, byrow=T) > (x/apply(x, 1, sum)) y <- matrix(c(1:4), nrow=2, ncol=2, byrow=F) t(y/apply(y, 2, sum))2番目のものを,colSumsにしてみても同様の結果でした。R 2.14.0でもR 2.2.0でも同様の結果でした(Window XP上で)。

どういうことなのでしょうか?

> (x <- matrix(c(1:4), nrow=2, ncol=2, byrow=T))

[,1] [,2]

[1,] 1 2

[2,] 3 4

> apply(x, 1, sum)

[1] 3 7

> x/apply(x, 1, sum)

[,1] [,2]

[1,] 0.3333333 0.6666667

[2,] 0.4285714 0.5714286

> (y <- matrix(c(1:4), nrow=2, ncol=2, byrow=F))

[,1] [,2]

[1,] 1 3

[2,] 2 4

> t(y/apply(y, 2, sum))

[,1] [,2]

[1,] 0.3333333 0.2857143

[2,] 1.0000000 0.5714286

> apply(y, 2, sum)

[1] 3 7

> y/apply(y, 2, sum)

[,1] [,2]

[1,] 0.3333333 1.0000000

[2,] 0.2857143 0.5714286

> t(y/apply(y, 2, sum))

[,1] [,2]

[1,] 0.3333333 0.2857143

[2,] 1.0000000 0.5714286

バグでも何でもない,当たり前の実行結果です。(このような,単純な計算結果にバグはないと思うのが普通です)。不審に思えば,デバッグ(途中結果の詳細を表示させて,何がどのようになっているかを理解する)する。> t(y)/apply(y, 2, sum)

[,1] [,2]

[1,] 0.3333333 0.6666667

[2,] 0.4285714 0.5714286

ということになりますね。> x <- matrix(c(1:4), nrow=2, ncol=2, byrow=T)

> x/apply(x, 1, sum)

[,1] [,2]

[1,] 0.3333333 0.6666667

[2,] 0.4285714 0.5714286

> prop.table(x, 1)

[,1] [,2]

[1,] 0.3333333 0.6666667

[2,] 0.4285714 0.5714286

まあ,そんな関数があることなんか知らなくてもどうってことはないです。 -- 河童の屁は,河童にあらず,屁である。 2011-11-15 (火) 21:21:41前田 (2011-11-14 (月) 22:45:36)

R初心者のものです。

大学の卒業研究でポンドの解析を行っています。

ARIMAモデルでの解析結果は出せるのですが

解析結果の詳細を表示させたいのですが

どなたかお知恵を貸していただけませんでしょうか?

パワースペクトルなどの結果も見れたらと思います。

宜しくお願い致します。

(x <- stats::arima(lh, c(2, 0, 1)))ここで表示されるものでは不十分ということでしょうか。

みのむし (2011-10-27 (木) 13:26:24)

Rの初心者です。簡単な質問で大変申し訳ないのです。

ある関数の、2階の導関数をもとめ、それを他の計算に使いたいと思っています。f <- deriv(~x^2*y, c("x", "y"), function(x, y) { }, hessian=TRUE)と書くと、4種類の2階の導関数を計算してくれるのはわかるのですが、個別の2階の導関数をどう選択して良いのかわかりません。たとえば、この場合、xとyで1回ずつ微分したものはどう選択すればよいのでしょう?

attr[f, "hessian"][x, y]こんな風にかいてみたのですが、だめなようです。ご存知の方教えていただけませんか?

> f12 <- function(x, y) attr(f(x, y), "hessian") > f12(1, 2) [1] 2 > f12(4, 3) [1] 8

nkoji (2011-10-08 (土) 14:45:51)

ベクトルのある値の連続と各連続における順番を取得したいです

例えば,c("a","a","a","b","c","a","b","a","a")に対してc(1,2,3,0,0,1,0,1,2)を得たいのです。今はこんなコードでやっています。A <- c("a","a","a","b","c","a","b","a","a") B <- rep(0,length(A)) A.str <- paste(A, collapse="") #開始位置と長さの取得 C <- gregexpr("a+", A.str) #C.mat[1,] 開始位置 C.mat[2, ] 長さ C.mat <- rbind(C[[1]], attr(C[[1]], "match.length")) B[A=="a"] <- unlist(apply(C.mat, 2, function(x){c(1:x[2])}))ベクトルの要素を一つずつ比較するよりは速いと思うのですが,上よりもっと速くなるコードがあれば教えてほしいです。

> my.func <- function(A)

+ {

+ B <- integer(length(A))

+ C <- rle(A == "a")

+ B[A == "a"] <- unlist(lapply(C$lengths[C$values], function(x) 1:x))

+ B

+ }

> your.func <- function(A)

+ {

+ B <- rep(0, length(A))

+ A.str <- paste(A, collapse="")

+ # 開始位置と長さの取得

+ C <- gregexpr("a+", A.str)

+ # C.mat[1,] 開始位置 C.mat[2, ] 長さ

+ C.mat <- rbind(C[[1]], attr(C[[1]], "match.length"))

+ B[A == "a"] <- unlist(apply(C.mat, 2, function(x) {c(1:x[2])}))

+ B

+ }

> a <- c("a","a","a","b","c","a","b","a","a")

> my.func(a)

[1] 1 2 3 0 0 1 0 1 2

> your.func(a)

[1] 1 2 3 0 0 1 0 1 2

> a <- sample(letters[1:5], 1000000, replace=TRUE)

> system.time(my.func(a))

ユーザ システム 経過

0.615 0.035 0.646

> system.time(your.func(a))

ユーザ システム 経過

2.448 0.040 2.453End.index.all <- cumsum(C$lengths) Start.index.all <- End.index.all - (C$lengths - 1) End.index <- End.index.all[C$values] Start.index <- Start.index.all[C$values]

my2.func <- function(A)

{

B <- A == "a"

C <- rle(B)

B[B] <- unlist(lapply(C$lengths[C$values], function(x) 1:x))

B

}もうり (2011-10-06 (木) 08:38:06)

> A <- read.table("matrix.dat") > B <- matrix(A[1,], 3, 3) > kappa(B, exact=TRUE)としたところ,

Error in svd(z, nu = 0, nv = 0) : infinite or missing values in 'x'というエラーが出力されました.

matrix.dat は1000行9列スペース区切りで実数を並べたテキストファイルです.

そこで,svd 関数の定義を見たところ,if (any(!is.finite(x))) stop("infinite or missing values in 'x'")との記述がありました.そこで確認のため,

> any(!is.finite(B))としたところ結果はTRUE.

ここまでは納得できなくもないのですが,> kappa(A, exact=TRUE)はエラーが出ず,しかも,

> any(!is.finite(A))の結果はTRUEです.

> A <- matrix(scan("matrix.dat"), ncol=9)と読み込むことによって,

> any(!is.finite(A)) > any(!is.finite(B))が両方FALSEとなったため一応解決はしましたが,すっきりしません.

原因に心当たりがある方がいらっしゃったらお教えいただければと思います.

最後に実行環境について記述しておきます.$ uname -sr Linux 2.6.18-92.el5 $ R --version R version 2.10.0 (2009-10-26)

怪獣 (2011-09-01 (木) 12:21:54)

よろしくお願いします。初級Q&A(10)のところで,LSMEANについてのやりとりがされていました。私のデータでLSMEANを得ることはできたのですが,グループの変数が3つあり,多重比較をしなければいけません。教えて頂きたいことは,LSMEANをベースにした3つの群のそれぞれのsdの求め方と二次データを使った多重比較の方法です。被験者数はすべて同じ数です。どうぞよろしくお願いいたします。

さとう (2011-08-29 (月) 18:16:59)

Rでcsv形式のデータからXMLへ変換しています。日本語のタグやデータも扱いたいのですが,以下のコードを実行すればわかるように,日本語が文字化けします。

(タグは文字化けしませんが,データの値は文字化けします。)

これを防ぐ方法はあるでしょうか?

library(XML) data <- c("変数1の値です。","value of variable 2.") xml <- xmlTree() xml$addTag('データセット', close=FALSE) xml$addTag("データ", close=FALSE) xml$addTag("変数1", data[1]) xml$addTag("変数2", data[2]) xml$closeTag();xml$closeTag();xml$closeTag() cat(saveXML(xml))

> cat(saveXML(xml,encoding = "UTF-8"))

<?xml version="1.0"?>

<データセット>

<データ>

<変数1>変数1の値です。</変数1>

<変数2>value of variable 2.</変数2>

</データ>

</データセット>R初心者 (2011-07-25 (月) 17:59:00)

今大学でRを使って研究をしているものですが初心者なので苦戦しています

今、等間隔でない座標値がいくつかあって線で結ばれたデータがあります

このデータを等間隔に(例えば2m間隔とか5m間隔とか)プロットさせるようなプログラミングを作成したいのですがどのようにやったらいいのでしょうか

簡単な質問でしたらすみません。何分初心者なもので・・・

ご指導よろしくお願いします。

kero_10625 (2011-06-22 (水) 12:26:37)

節電対策などで、建物のエネルギー解析が必要になっています。ビル管理システムにExcelで記録された数百から一万程度の多数のファイルの処理を行っております。

Excelの単一のセル、1列あるいは1行だけを読み込む必要が出てきました。

RODBCを用いて、sqlQuery を使うとデータフレームで値を返すためか、空欄のセルがあるとエラーが発生します。

xlsReadWriteパッケージのread.xls()関数を使うと可能なのですが、xlsx形式に未対応であり基本的にはシェアウエアであり将来の対応に不安が残ります。

建築技術者にRを使ってもらおうと考えていますので、Pearlなどあまり追加のソフトのインストールは避けたいです。

何か良い方法をご存じでないでしょうか。

ktr (2011-06-21 (火) 21:30:21)

Rで,ある関数を展開し,中身を見ると.CとしてC言語で書かれた関数が使用されていました.Rの関数は関数名をタイプすれば中身を見ることが出来ますが,このように他言語で書かれた関数をRで展開することは可能なのでしょうか?

竹澤 (2011-05-31 (火) 16:27:12)

t.test()の機能を確認するために以下のようなRプログラムを試しました。function() { nt <- 10000 pt <- 0 for(kk in 1:nt){ set.seed(12+kk*144) xx1 <- abs(rnorm(50, mean = 0, sd = 1)) xx2 <- abs(rnorm(50, mean = 0, sd = 1)) xx <- c(xx1, - xx2) ttest1 <- t.test(xx, mu = 0) pp <- ttest1$p.value if (pp < 0.05){ pt <- pt +1 } } pt <- pt/nt print(pt) }正規分布に従うデータを作成する方法がややひねくれています。結果は、0.05に近くなるはずなのに0.0018になりました。正規分布に従うデータを作成するときに普通の方法を使うと0.0517になりました。このような違いが生じるのはなぜでしょうか。

miya (2011-05-02 (月) 10:11:04)

polr関数を用いて,順序ロジットモデルを推計しています.

SUMMARY()を利用すると,推計結果が表示されます.

その際,AIC指標が表示されますが,尤度比は表示されません.

初期尤度,最終尤度,ならびに尤度比を求めたいのですが,polr関数にどのようなオプションを付ければよいのか,教えていただけると助かります.

もしかすると,定義式にしたがって,自分で計算式を作成して計算するしか方法がないのでしょうか.

ウルトラ初心者 (2011-04-18 (月) 15:33:39)

BioconductorのDESeqというパッッケージを使ってます。ほとんどコピペ程度でしか使えてません。plot(res$baseMeanA, res$baseMeanB, pch=20, cex=.1, col = ifelse( res$padj < .1, "red", "black" ))というコマンドで散布図がマニュアルに載っていて、そのままコピペしてかけていました。

resという表のpadjカラムの値がが0.1より小さければ赤、それ以外を黒という風にプロットされています。

さて、別のパッケージBaySeqで統計解析しか結果もこの散布図に反映させたいと考えました。

そこで、一つカラムを増やしてanalysisとなづけ、DESeqで有意なデータを1、BaySeqで有意なデータを2、DESeqでもBaySeqでも有意なデータを3、それ以外を0というように入力しました。

そこで、analysisカラムをみて1ならば赤、2ならば青、3ならば緑、0ならば黒というように上のplotコマンドを改良したいのです。

たぶん、ifを重ねて使っていけばいけそうなのですが、どのようにググってよい物かわかりません。

全くの丸投げ質問で恐縮ですが、よろしくお願いします。

さと (2011-04-17 (日) 05:21:20)

現在、クアッドコアのCPUを搭載したWINDOWSマシンにRをインストールして利用しています。

そのうえで、for文を使って繰り返し計算を行っていますが、非常に時間がかかっております。

Rを立ち上げて計算させても一つのコアしか使わないので、マルチコアの資源を有効に使えておりません。

仕方がないので、Rを4つ一度に立ち上げて、for文の繰り返しを, 1:25, 26:50, 51:75, 76:100というように分けて実行しています。

これで計算時間は短くなるのですが、もっとスマートにやる方法をご教授いただければ幸いです。

UNIX環境で使える multicore というパッケージは見つけたのですが、WINDOWSで使える方法を見つけられませんでした。

こちらの環境ですが、

OS: Windows 7 Professional, Service Pack 1

プロセッサ: Intel(R) Core(TM) i7 CPU M620 @ 2.67GHz

実装メモリ(RAM): 8.00GB

システムの種類:64ビット オペレーティングシステム

なにとぞよろしくお願いいたします。

Tetsu (2011-01-27 (木) 22:59:49)

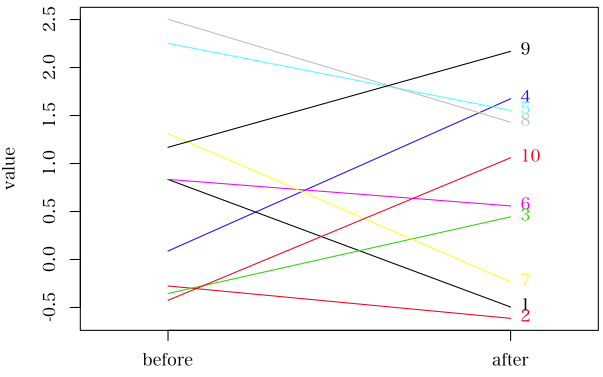

現在、ts.plotを使用して、時系列データの作図をしております。

その際に、1つの点を黒丸、もう一方の点を白抜き三角でプロットを行っております。

三角が手前に来るようにデータ系列の指定の順番を変えたり、par(plot=new)を使用して重ね書きをしてみたのですがうまくいきません。

結局、三角の中身が白で塗りつぶされていないのが問題だと思うのですが、pchで指定可能な白三角と黒丸を一通り試したところ、全て同様の図が表示されてしまいました。

このような問題を解決する方法は無いのでしょうか?

あと、一点質問があります。

作図をする際に見易くするために、軸に主目盛りと副目盛りをつけようとしております。

このような場合はaxis()を2回使用して、目盛りの長さが異なる軸を重ねて描く以外に方法はないのでしょうか?

教えていただけないでしょうか?

よろしくお願いいたします。

Natsu (2011-01-26 (水) 00:02:56)

Rをインストールして、Rコマンダーを使いたいのですが、パッケージからRコマンダーを選ぶと、以下のように出てしまいます。install.packages(NULL, .libPaths()[1L], dependencies = NA, type = type) 中で警告がありました: 'lib = "C:/PROGRA~1/R/R-2.12.1/library"' は書き込み可能ではありません 以下にエラー sprintf(msg, userdir) : <83>シ<e3>Ν縺吶k縺溘a縺ォ蛟倶ココ逧<84>縺ェ繝ゥ繧、繝悶Λ繝ェ '%s' 繧剃ス懊j縺溘>縺ョ縺ァ縺吶°<ef>シ<9f> に不正なマルチバイト文字がありますどのようにすればインストールできるのでしょうか?

初歩的な質問で申し訳ないのですが、教えてください。

S.K (2011-01-21 (金) 23:19:26)

GAMを用いてデータ解析をしているのですが、変数選択の方法が分からなくて

困っています。web上にはstep.gamというものがあるそうなのですが、どのパッケージに入っているかもわからない状態です。何かご意見を頂けないでしょうか。よろしくお願い致します。

R初心者 (2011-01-10 (月) 09:58:15)

R初心者です。

JavaからRserveを利用して、Rを起動しようとしてます。

そこである程度同時実行をさせて、最終的に200件ほどの要求をRserveになげるようにしています。そこで、問題なのですが、Rserveからコネクションエラーが数十件返ってきます。そのコネクションエラー数は毎回毎回まちまちで数も特定できません。私が調べた限りでは、Rserveでコネクションの制限を設定している部分がないことから現状なぜこのようになるか不明な状態です。

そこでもしこのような現状に対する情報をお持ちでしたら、教えていただけないでしょうか。よろしくお願いいたします。

H.A (2010-12-13 (月) 21:07:38)

はじめまして

大学で企業財務を勉強しているものです。

さて、初歩的な質問で恐縮なのですが、Rでパネル分析を行った際に、企業固定効果の係数を出力することはできないのでしょうか?

各企業ごとの企業固定効果を分析上使用する必要があるため、それらをぜひとも抽出したいのです。

もしコードなどをご存じのかたがいましたらご教授お願いします。

XC (2010-12-11 (土) 12:04:28)

はじめまして

Rを調べ出しの初心者です

MATLAB系のスクリプトをRで動くようにする変換プログラムを作っているのですが、元のスクリプト群で多用されている、スカラを返す補間関数がマニュアルを探しても見付かりませんでした。

例えば、エンジン回転数ー発生トルクの2次元のマップ(回転数1000毎とか)、rpm_tqがあったとして、任意の、例えば2850回転の時の発生トルクであれば、

interp1()を使用して、

tq = interp1(rpm_tq(:,1), rpm_tq(:,2), 2850)

(rpm_tq(:,1)、 rpm_tq(:,2)は、回転数とトルクのベクタになります)

の様になっているので、Rで

tq <- interp1(rpm_tq[1], rpm_tq[2], 2850)の様に書けると嬉しいのですが

皆様のご教示をいただけましたら幸甚です。

arima (2010-10-31 (日) 15:09:12)

直線的なトレンドのある時系列に対してarima(時系列,order=(1,1,0))とすると、AR部分の係数が出力されるのみで定数項が出力されません。

これにpredictを施しても、定数項がないため、将来の値が一定となってしまいます。

定数項を出力させるためにはどうすればよいのでしょうか。

宜しくお願い致します。

風の歌を聴け (2010-10-30 (土) 10:23:53)

いつも参考にさせていただいております。

splancsのK関数を求めるkhat関数について質問させていただきます。

ランダム分布のsimulation envelopeの上下限を求めるシミュレーション回数(nsim)はどのように決めるのでしょうか?19回や99回などが多く使われているようですが、回数はどのように決めるのでしょうか?また、回数が多いほうが上下限の幅が狭くなるのでしょうか?谷村晋さんの新刊「空間地理データ分析」(共立出版)を拝見しましたがnsim=99の例がのっていました。

よろしくお願いいたします。

ST (2010-10-29 (金) 23:46:16)

クラスター分析での項目名についてです。

Rコマンダーを使用してデータを読み込んでいます。

クラスター分析を行い、樹形図を表示させた場合、各項目が項目名にならず、1からの連番になってしまいます。(項目名がAA,BB,CCでも1,2,3になるということです。)

どのようにすれば項目名が表示されるようになるのでしょうか?

よろしくお願いします。

TKです (2010-09-16 (木) 17:54:37)

リッジトレースをRで実行したいのですが、どのようにすればいいですか?

プログラムを作るしかないですか?

リッジ回帰のコマンドは一応あるのですが、実行してはみたものの、あまり使い道がないと思うのですが。

atsuo (2010-07-26 (月) 18:01:11)

�FEARのdeaでは、CCRとBCCとNIRSの結果は出ます。さらに、NDRSの結果を出すことは可能でしょうか?

�deaの分析を行うためにFEARのdeaを改良したいと考えた場合、元のソースプログラムを手に入れる方法はありますか。(もしかしたら、基本的な質問かもしれません。申し訳ありません。Rを最近始めたばかりです。なんとかヒントをいただけませんでしょうか。よろしくお願いします。)

kazuaki (2010-06-03 (木) 01:11:15)

目的関数 : x[1]^2+x[2]^2+...+x[n]^2

制約条件 : Ax=b , x>=c

xとcはn次元ベクトル,bはm次元ベクトル,行列Aはn*m行列。

xが決定変数。

上記の最適化問題(最小化問題)を解きたいのですが、適切な手法やパッケージが特定できずにおります。

shigeru (2010-04-09 (金) 06:35:07)

2元配置分散分析を行う前の等分散性の検定についてお伺いします。たとえば、要因A(2水準)と要因B(3水準)で繰り返しのある2元配置実験データが

y A B

y1 A1 B1

y2 A1 B2

y3 A1 B3

・・・

のような形で得られているときに、

bartlett.test(y ~ A * B)

とすると、自由度はdf=1となり、また

bartlett.test(y ~ B * A)

とすると、df=2となり、最初に出てくる要因しか評価されていないようです。AとBの組み合わせ要因(この場合はdf=2×3-1=5)に対して等分散性の検定をするにはどうすればよいのでしょうか。AとBの組み合わせからCという要因を新たにつくって対処することもできるでしょうが、その場合でも少し面倒になるような気がします。簡単に対処する方法はないのでしょうか。ご教示頂ければ大変助かります。

> set.seed(20100409)

> d <- data.frame(y=rnorm(24),

+ A=gl(2, 12, labels=c("A1", "A2")),

+ B=gl(3, 4, 12, labels=c("B1", "B2", "B3")))

> d$temp <- as.integer(d$A)*10+as.integer(d$B) # 策を弄する

> d$C <- factor(d$temp, # 新たに factor 変数を作る

+ labels=c("A1B1", "A1B2", "A1B3", "A2B1", "A2B2", "A2B3"))

> d

y A B temp C

1 0.807748961 A1 B1 11 A1B1

2 0.513417877 A1 B1 11 A1B1

3 -0.156009578 A1 B1 11 A1B1

4 -0.192902834 A1 B1 11 A1B1

5 0.043651547 A1 B2 12 A1B2

6 -1.530954060 A1 B2 12 A1B2

7 -1.984433103 A1 B2 12 A1B2

8 0.416585172 A1 B2 12 A1B2

9 -0.001342267 A1 B3 13 A1B3

10 0.364838567 A1 B3 13 A1B3

11 1.182524866 A1 B3 13 A1B3

12 -1.087637431 A1 B3 13 A1B3

13 -1.552197067 A2 B1 21 A2B1

14 0.323540547 A2 B1 21 A2B1

15 -0.635204370 A2 B1 21 A2B1

16 -2.889526450 A2 B1 21 A2B1

17 0.223709445 A2 B2 22 A2B2

18 0.118526662 A2 B2 22 A2B2

19 0.172598117 A2 B2 22 A2B2

20 1.846951151 A2 B2 22 A2B2

21 0.673207028 A2 B3 23 A2B3

22 1.080020322 A2 B3 23 A2B3

23 1.383334771 A2 B3 23 A2B3

24 -0.260967601 A2 B3 23 A2B3

> bartlett.test(y~C, d)

Bartlett test of homogeneity of variances

data: y by C

Bartlett's K-squared = 3.125, df = 5, p-value = 0.6807

今の例では,以下の方でもよい

> set.seed(20100409)

> d <- data.frame(y=rnorm(24),

+ A=gl(2, 12, labels=c("A1", "A2")),

+ B=gl(3, 4, 12, labels=c("B1", "B2", "B3")))

> d$C <- factor(paste(d$A, d$B, sep=""), # 今の例ではこの方がよいかな?

+ labels=c("A1B1", "A1B2", "A1B3", "A2B1", "A2B2", "A2B3"))

> d

y A B C

1 0.807748961 A1 B1 A1B1

2 0.513417877 A1 B1 A1B1

途中省略

23 1.383334771 A2 B3 A2B3

24 -0.260967601 A2 B3 A2B3

> bartlett.test(y~C, d)

Bartlett test of homogeneity of variances

data: y by C

Bartlett's K-squared = 3.125, df = 5, p-value = 0.6807ohgi (2010-03-20 (土) 10:46:20)

仰木と申します.

Rで時系列グラフをplot()を使って描画していますが,実験最中に取れたデータ(約数十万行分)を描画して,必要そうな部分,注目したい部分を拡大して描画したいとき,Scilabではマウス右クリックでエリア指定の拡大ができるのですが,Scilabではあいにく今回の実験データが最大メモリ許容量を超えてしまうため,Rで同じことができないかと思っています.Rでデータの読み込みと全体描画はできるのですが,グラフ画面上で拡大したい部分をマウス操作で拡大するようなことはできないでしょうか?

もちろん,描画する範囲をスクリプトで描けば再描画することはわかっていますが,次々にその時刻を計算して拡大し,閲覧する作業が必要なので出来ればグラフ画面上で出来ないか,と思っています.

「できない」という答えでもよいので教えていただけませんでしょうか.

あんどう (2010-03-14 (日) 20:57:00)

Help にある .rds, .rdb, .rdx はどのように開くのですか。

boston (2010-03-08 (月) 05:47:02)

test.R はcat("Hello World")だが、test.Routに出力されない

R --vanilla < test.R > test.Routは出力される BATCHの書き方に問題がありますか

初心者 (2010-02-15 (月) 02:52:47)

パッケージSOMの、関数somの学習回数は何回なんでしょうか?

あんどう (2010-02-07 (日) 12:28:45)

lmの処理を調べようとtest_lma.Rを作成し実行すと、match.call()で以下にエラー match.call() : 'match.call' がその中から呼び出されたクロージャを見付けることができません。となります。 プログラムの冒頭は以下のとおりで

formula <- y ~ 1 + x xx <- c(1.386294, 2.079442 ,2.772589, 3.465736) yy <- c(0.06254298 ,0.71444544, 1.27103337, 1.28339677) ww <- c( 1.0000000 ,0.5000000, 0.3333333, 0.2500000) data <- data.frame(x = xx, y = yy, w = ww) subset <- 0 weights <- ww na.action <- 0 method <- "qr" model <- TRUE x <- FALSE y <- FALSE qr <- TRUE singular.ok <- TRUE contrasts <- NULL offset <- 0 ret.x <- x ret.y <- y cl <- match.call() mf <- match.call(expand.dots = FALSE)これ以降はlmのままです。

目的は余分な処理を削除したいのです。

> cl <- match.call() エラー: match.call() was called from outside a function > mf <- match.call(expand.dots = FALSE) エラー: match.call() was called from outside a functionエラーメッセージの言わんとしていることは,「関数の外で match.call なんかやってもだめだよ〜」ということかな?

あんどう (2010-02-06 (土) 08:50:29)

libraryに関数を追加する方法を教えてください。

新たな関数を作り既存の関数をリンクさせたいのですが。

.Rをつくり cl <- match.call()を組み込んだのですがエラーになります。新たな関数をlibraryに追加できればエラーがなくなると考えています。

こうや (2010-01-18 (月) 11:13:26)

それぞれの説明変数に対する回帰係数が応答変数のカテゴリーごとに出ると思うんですが、それらの係数がどのカテゴリーと対応しているかがよく分かりません。

教えていただけないでしょうか。

吉川 (2010-01-14 (木) 17:37:24)

Rで極値統計をやっております。

extRemes, ismev を使ってGEVの推定を行っています。

gev.fit(x)を使って推定を行うと、

グンベル分布・ワイブル分布・フレシェ分布の中から推定されます。

これを、グンベル分布のみで推定したい場合にはどのようにしたらよいでしょうか。

ご存知の方がいらっしゃいましたら、よろしくお願いいたします!

genri (2010-01-03 (日) 13:51:31)

どう計算しているのか原理をお教えください。

この関数はdist構造のデータを使って計算します、たとえば距離マトリクスhogeにたいして

hclust( as.dist(hoge), method="ward")

で結果を返します。

Ward'sの方法では、クラスター間の距離はクラスターの統合によって増加した分散によって定義されています。そこで、距離マトリクスを算出した最初のデータがないと距離が算出できないのではないかと思うのです。

どうやって距離マトリクスからwardの距離を算出しているのでしょう?

a<-rnorm(10000, sd=2, mean=10) b<-rnorm(10000, sd=1, mean=0) var(a)+var(b) var(a-b)同じくらいの値が出てくるはず。

zhang (2009-12-07 (月) 10:25:06)

おはようございます。張@弘前大学です。R初心者で何か間違ったらご指摘ください。

今研究で,リンゴの形状推定を行っています。リンゴのお尻のくぼみを三次元計測して,2次元正規分布関数として推定しようと考えています。

R初心者で,色々調べたら,kde2d()やbked2d()でできるらしいが,しかし,最終的に出力してほしいのは中心値(μ1,μ2)と標準偏差(σ1,σ2)です。これでできるでしょうか?

ほかに何か方法がありませんか?宜しくお願いします。

Shigeru (2009-11-21 (土) 17:17:18)

等分散性の検定にコクランのC検定を使った文献をよくみかけますが、どのような方法なのでしょうか。またRでは実行可能でしょうか。お教えいただけるとありがたいです。

Cochran's C test A test, introduced by Cochran in a 1941 paper, for equality of variance in m normal populations having unknown means and having sample variances denoted by . Let be the ...などという説明があったりしますけど,少なくと r-project.org のトピックには上がっていないようです。 -- 河童の屁 2009-11-21 (土) 20:54:36

b.b. (2009-11-04 (水) 10:50:45)

質問です。

スプライン平滑化を行ってグラフを得たのですが、

xがある値の時の平滑化されたyの値を出力するには

どうしたらいいのでしょうか?

koba (2009-09-03 (木) 12:51:05)

線形不等式制約付きの最適化関数constrOptimにてhessianでヘッセ行列を表示しようとしてもエラーが出てしまいます。

そもそも存在しないのでしょうか?

dtak (2009-08-13 (木) 07:06:37)

はじめまして、dtak と申します。

R (version 2.9.1 i386-apple-darwin8.11.1) でのMap関数(mapplyのラッパー関数)の振る舞いについて少し気になることがありましたので、投稿いたします。

Mapを用いて関数のリストを作ろうとしたのですが、Mapの引数fの内部で作られるクロージャでのみ評価されるfの引数が、最後の要素の値で上書きされてしまいました(なんだかややこしいですね、以下の単純化したコードをみてください)。> Map (function (x) x(), Map (function (y) {function () y}, c(1, 2, 3))) ## list(1, 2, 3) が返ることを期待 [[1]] [1] 3 [[2]] [1] 3 [[3]] [1] 3 >あらかじめ評価してしまうことで回避することはできるのですが、

> Map (function (x) x(), Map (function (y) {y;function () y}, c(1, 2, 3))) [[1]] [1] 1 [[2]] [1] 2 [[3]] [1] 3 >(遅延評価が行われるのであっても)少し奇妙な印象を受けました。これはこのような挙動をするものと考えるべきなのでしょうか、それとも不具合と考えるべきなのでしょうか?

ご存知の方がおられましたら、よろしくお願いいたします。

fall (2009-07-07 (火) 13:28:37)

パッケージMASSのplorを用いて順序ロジスティックを行おうと考えております。

ここで私が困っていることが以下のような内容であります。

(目的変数にhelpでは”factor”を指定しなければならないと書かれており、数値を目的変数に入れるとエラーになってしまいます。目的変数を1,2,3など順序のある数値として解析をおこなうためのパッケージやplorの設定方法があるのであれば、教えて頂きたいと思います。)

どうぞよろしくお願いいたします。

かわお (2009-06-23 (火) 23:14:25)

非線形の連立方程式を解くプログラミングを教えて下さい。

例えば、

x^2+y^2=5, 2×x^2+y=4の解x,yを解く方法が知りたいです。

よろしくお願いします。

たけぼう (2009-06-14 (日) 01:53:04)

R超初心者です。

ある半導体関連装置のサポートエンジニアをやっております。担当している装置はPC上で実行されるプログラムに従って動作するようなシステムです。

担当している装置が出力する日付、時間を含んだエラーログを見る機会が多く、その解析にRを利用できないかと考え入門しました。 担当している装置はログファイルの出力が「コマンド実行履歴」と「エラーログ」に分かれて記録されているので、「エラーが発生したとき、その装置は何をしていたか?」を調べるのに毎回エクセルで悪戦苦闘していましたが、この部分をRで一発で視覚的に表示できないかな?、と考えています。ログのフォーマットは次の通りです(csv)。

[エラーログ]

YYYY/MM/DD, HH:MM:SS, ALARM1

YYYY/MM/DD, HH:MM:SS, ALARM2:[コマンド実行履歴]

YYYY/MM/DD, HH:MM:SS, COMMAND1

YYYY/MM/DD, HH:MM:SS, COMMAND2:「上記二つの時系列ファイルから、両者の因果関係を視覚的に表示したい」

というのがやりたいことなのですが、Rでできそうでしょうか?

ヒント・アイディアだけでも良いので、何か閃いた方はご教示下さいませ。

路地裏の少年 (2009-05-25 (月) 22:57:16)

低水準作図の繰り返しコマンドについて教えてください。

データは以下のようになっています。

緯度 経度 年

35 156 2000

38 165 2000

37 150 2001

38 148 2001・・・・

年毎の緯度経度のプロット図(20年分、各図の題名にはその年を充てたいと思っています)を書かせたいと思っています。

年ごとに抽出すれば、書けるのですが、20回繰り返せねばなりません。

初歩的な質問で恐縮ですが、よろしくお願いします。

df<-data.frame(lat=c(35,38,37,38),

long=c(156,165,150,148),

year=c(2000,2000,2001,2001)

)

cat(deparse(df),fill=T)

library (maps);

par(ask=T)

lapply(unique(df$year),function(y)

{

cat(y,fill=T)

longlat<-df[df$year==y,c("long","lat")]

plot (longlat,

xlim = c(135, 155),

ylim = c(32, 50),

axes = F, main = y, pch = 20)

map ("world2", xlim = c(135, 155), ylim = c(32, 50), add = T)

map.axes()

dev.copy(pdf, file = paste(y,".pdf",sep=""))

dev.off()

}

)

cat(deparse(df),fill=T)とかすると, 編集した小さなデータの切り出しが簡単でしょ?ま (2009-04-16 (木) 19:13:38)

非線形最小二乗法を実施する関数として,nlsがありますが,このポアソン分布版はありませんでしょうか?教えていただければ幸いです。

x <- c(1:10) y <- c(10,10,9,8,5,3,2,1,0,0) plot(y~x)

K.K (2009-01-27 (火) 16:15:38)

クラスター分析で、plotされた樹形図の細かい統合部分をsplancsのzoomで見ようとしましたが、樹形図が表示されないまま拡大されてしまいます。

plotされた樹形図をzoomで細かく表示させる方法はありませんか?

y.t (2009-01-15 (木) 18:10:28)

MASSパッケージにある順序ロジットの関数 polr() に 定数項を入れたいのですがどうすればよいでしょうか?

yuki (2008-12-16 (火) 01:49:28)

WinBUGSではDICは簡単に計算できるコマンドがあるようですが,BRugsでもそのようなコマンドはあるのでしょうか?

大津起夫 (2008-12-05 (金) 17:33:15)

R-2.8.0 を CentOS5.2 x64上でコンパイルし、make check したところ, tests/Examples/methods-Ex.Rの実行でエラーが生じます。 173行目あたりの setMehods("f","B0", function(x) c(x@b0^2, callNextMethod()))) 実行時にsprintf実行例外が発生してしまいます。これは他の版などで生じていないのでしょうか? また、すでに知られたバグでしょうか?

エラーログ> f <- function(x) class(x) > > setMethod("f", "B0", function(x) c(x@b0^2, callNextMethod())) 以下にエラー sprintf(gettext(fmt, domain = domain), ...) : 引数が少なすぎます Calls: setMethod -> message -> gettextf -> sprintf 実行が停止されましたOSは gcc 4.1.2環境ですが、コンパイルはIntel C++ 11.0 +Intel ifort 11.0+MKL 10.0でおこなっています。

下記が、configure.siteの指定、および ./configure の引数です(インストールマニュアルにある B.Ripley先生となかまさんの指定にしたがっていますが、config.siteのパラメータは -mpを-ieee-fpにしました)。

上記の命令は2回目以降はエラーを起こしません。上記の箇所の直前に try(setMethods(....)) )のように同様の命令を挿入すると、テストをパスします。

また,CentOS5.2のパッケージ compat-libstdc++33-3.2.3-61 から/usr/lib64/libstdc++.so.5をインストールしています。

--- config.site ---- CFLAFGS="-g -O2 -wd188 -ip -std=c99" F77=ifort FFLAGS="-ieee-fp -g -O3" CXX=icpc CXXFLAGS="-g -O3 -ieee-fp" FC=ifort FCFLAGS="-g -O3 -ieee-fp" ICC_LIBS=/opt/intel/Compiler/11.0/074/lib/intel64 IFC_LIBS=/opt/intel/Compiler/11.0/074/lib/intel64 LDFLAGS="-L$ICC_LIBS -L$IFC_LIBS -L/usr/local/lib64" SHLIB_CXXLD=icpc ----- configure 実行引数 ----- OMP_NUM_THREADS=8 MKL_LIB_PATH=/opt/intel/Compiler/11.0/074/mkl/lib/em64t MKL=" -L${MKL_LIB_PATH} \ -Wl,--start-group \ ${MKL_LIB_PATH}/libmkl_intel_lp64.a \ ${MKL_LIB_PATH}/libmkl_intel_thread.a \ ${MKL_LIB_PATH}/libmkl_core.a \ -Wl,--end-group \ -liomp5 -lguide -lpthread -lgomp" ./configure --with-lapack="$MKL" --with-blas="$MKL"リストの終わり

patch < methods.patchのパス名とする。R-ja.poが修正される。

(cd po; make remove-potcdate.sed; make en@quot.insert-header) (cd po; make methods.pkg-update)8) make check を 実行すると問題なくとおる。

Rcommander利用者 (2008-09-02 (火) 10:45:00)

線形モデルでの変量効果(ランダム効果)・混合効果の解析方法を教えてください。変数の指定方法などわかりません。よろしくおねがいします。

むかしちゃん (2008-06-25 (水) 22:20:15)

統計用語にJACKNIFE という物騒な用語をインターネットで見つけましたが

どんなところでどんな風に使うのですか?

気になった人 (2008-05-20 (火) 09:32:44)

Rの魅力の一つは、各関数が比較的詳しい参考実行コードを持っており、関数の使い方がわかることです。もう一つ豊富な組み込みデータセットがあり、関数参考実行コードはしばしばそれを用いることで、単に参考のための参考に止まらない迫真性を与えることができます。

ところで逆ができるでしょうか。つまり、ある組み込みデータセット(例えば co2)を例示用コードで参照している関数を一覧することです。

例えば Linux なら端末から次のような命令を実行すればそれらしいことができますが、Rには元々そうした機能は無い?

$ grep -r "co2" /usr/lib/R/* | grep "/help"

NP (2008-04-22 (火) 14:27:46)

Rを用いてCumulative incidence curveを書くところまではできたのですが、tick marksを打ち切りとなったものの観察期間を示すためにつけろといわれました。どのようにすればできるでしょうか。教えてください。よろしくお願いいたします。

for (j in 1:nrow(x$est)) {

temp <- as.integer(unlist(strsplit(rownames(x$est)[j], " ")))

temp <- ftime[fstatus == 0 & group == temp[1]]

temp2 <- timepoints(fit, temp)

mapply(function(x, y) segments(x, y, x, y+0.02, col=col[j]),

sort(temp), temp2$est[j,])

}#ref(): File not found: "fig.png" at page "Q&A (初級者コース)/13"

legend("topleft", legend = rownames(x$est), x.intersp = 2,

bty = "n", xjust = 1, col = col, lty = lty, lwd = lwd)

for (j in 1:nrow(x$est)) {

temp <- as.integer(unlist(strsplit(rownames(x$est)[j], " ")))

temp <- ftime[fstatus == 0 & group == temp[1]]

temp2 <- timepoints(fit, temp)

mapply(function(x, y) segments(x, y, x, y+0.02, col=col[j]),

sort(temp), temp2$est[j,])

}

out <- list(test = tests, est = tfit$est, se = sqrt(tfit$var))> ( x <- read.csv("bmt.csv", header=TRUE, sep=";") )

dis ftime status

1 0 13 2

2 0 1 1

3 0 72 0

4 0 7 2

途中省略

34 1 32 0

35 0 12 1

で,プログラムはちゃんと挿入できていますね。> CumIncidence(x$ftime, x$status, x$dis)

+-------------------------------------------------------------------+

| Cumulative incidence function estimates from competing risks data |

+-------------------------------------------------------------------+

Test equality across groups:

Statistic p-value df

1 1.302 0.253915 1

2 7.082 0.007785 1

Estimates at time points:

0 10 20 30 40 50 60 70

0 1 0.05882 0.1176 0.1765 0.1765 0.1765 0.1765 0.1765 0.1765

途中省略

0 2 0.05882 0.12631 0.12667 0.12077 0.12077 0.12077 0.12077 0.12077

1 2 0.00000 0.11558 0.11558 0.11558 0.11558 0.11558 0.11558 0.11558

以上で終了し,tick mark のついている図が描かれており,warning なんて出ないのですけど。

それと,今更なんですが,「グラフ自体はお示しいただいたのと同じものがかけるのですが」って,上に掲示した図から tick mark を除いたものということでいいのですね?UO (2008-04-09 (水) 11:48:43)

皆さんに相談があります。

RでAutoregressive Conditional Durationモデルを使いたいのですが。

可能でしょうか?

ご存知の方がいらっしゃっいましたら、教えてください。

rowhelp (2008-04-07 (月) 10:57:23)

はじめまして、現在、Rを使用し遺伝子解析を始めたばかりです。

データフレーム内のある特定の列に含まれる文字列をrownameに変換したいと思います。

どのような作業を行うのが一番よろしいでしょうか。

ご教授をお願いいたします。

> DF <- data.frame(A=letters[1:4], B=runif(4), C=rnorm(4))

> DF

A B C

1 a 0.1429617 0.8767259

2 b 0.7656706 0.2077312

3 c 0.5311202 -0.6043531

4 d 0.9375921 1.0804659

> rownames(DF) <- DF[,1]

> DF

A B C

a a 0.1429617 0.8767259

b b 0.7656706 0.2077312

c c 0.5311202 -0.6043531

d d 0.9375921 1.0804659

> DF <- DF[,-1]

> DF

B C

a 0.1429617 0.8767259

b 0.7656706 0.2077312

c 0.5311202 -0.6043531

d 0.9375921 1.0804659> DF.new <- data.frame(DF, row.names="A")

> DF.new

B C

a 0.79124741 1.2432360

b 0.03667521 -1.0248516

c 0.78015687 0.1808611

d 0.30211288 0.2649450yuta (2008-04-03 (木) 16:43:46)

こんにちは。いつも参考にさせていただいています。

以下に示すような折れ線グラフと縦線プロット(plot()のtype="h")の混在したグラフがあります。このグラフに凡例を付けたいのですが、図にもあるように、legend()を普通に使うだけではラインはすべて横線になってしまいます。(plotのスクリプト省略) par(xpd=NA) legend(locator(1),c("a-pro","a-height","b-pro", "b-height"),col=c("black","black","Royalblue","Royalblue"), lwd=c(2,3,1,1.5),pch=c(1,NA,1,NA))凡例中で縦線を使う方法はあるのでしょうか。お尋ねいたします。

#ref(): File not found: "QA.png" at page "Q&A (初級者コース)/13"

legend(locator(1),c("a=pro","a-height","b-pro",

"b-height"),col=c("black","black","Royalblue","Royalblue"),

lty=c(1,0,1,0),lwd=c(2,0,1,0),pch=c(1,15,1,15))

#ref(): File not found: "QA2.png" at page "Q&A (初級者コース)/13"

たいち (2008-02-12 (火) 18:20:13)

こんにちは。こんなデータがあるとします(実際はもっと長く,同じschoolに属するデータの個数は一定ではありません)。school y x 1 1 4 1 2 1 3 2 3 1 2 3 4 5 4 2 5 5 5 3 6 5 3 4 7 8 4 3 8 8 4 3 9 8 1 2ここから,同じschoolに属する人のxとyだけをランダムに抽出したいのですが,どのようにすればいいのでしょうか?

よろしくお願いします。

> A <- data.frame(school=sample(1:3, 10, 1),x =sample(1:4,10,1), y=sample(10:14,10,1)) > A school x y 1 2 1 12 2 1 4 10 3 1 1 12 4 1 1 13 5 1 1 14 6 3 1 12 7 3 4 12 8 2 4 13 9 3 3 13 10 2 1 11 > A1 <- A[A$school==1,,] > A1 school x y 2 1 4 10 3 1 1 12 4 1 1 13 5 1 1 14 > A1[sample(seq(ncol(A1)),3),,] # school=1 から3ケースを非復元ランダム抽出 school x y 2 1 4 10 4 1 1 13 3 1 1 12 > A1[order(sample(seq(ncol(A1)),3)),,] # 行番号を整列させたければ school x y 2 1 4 10 3 1 1 12 4 1 1 13

使用歴だけは長い人 (2008-02-06 (水) 14:10:12)

ルート権限の無いシステムに個人的にパッケージをインストールしようとしています。ほとんどのパッケージは問題なく個人ディレクトリにインストールできるのですが、(これまた個人的にインストールした)外部ライブラリへのラッパーであるパッケージをインストールしようとすると、(当然でしょうが) /usr/local/lib を参照しようとしてエラーになります。こうしたとき必要なライブラリ位置をRに教えてあげるにはどうすればよいのでしょうか。ちなみに問題のパッケージは gsl でこれは GNU GSL ライブラリーへのラッパーです。OS は Linux, R 2.6.1 を使用しています。GSL ライブラリは個人ディレクトリにインストール済みです。管理者に GSL をインストールしてもらえば済むことでしょうが、同様の問題が今後も起きそうで、何とか個人的にインストール出きると便利なのですが。うまい方法があれば教えてください。パッケージのインストールにはいつも R CMD INSTALL xxx.tar.gz としています。

> install.packages("hoge",lib="~/R/library",

configure.args = "CPPFLAGS = -I~/include LDFLAGS = -L~/lib")

とすると(configure.argsの内容はあくまで例ですので、自分の指定したいオプションに書き換えてください) 、どうなりますか?どこにインストールしたかは、

> library()で分かります。~/R/libraryに入れたpackageを使うには、.RenvironにR_LIBS=~/R/libraryを足す必要があるかも。現在のパスは、

> .libPaths() [1] "~/R/library" "/usr/local/lib/R/library"これで確認できます。-- 谷村 2008-02-12 (火) 20:59:56

* Installing * source packages 'gsl'... checking for gcc... gcc checking for C compiler dafault output... configure: error C compiler cannot create executables

$ tar xzf gsl_1.8-8.tar.gz && cd $(tar tzf gsl_1.8-8.tar.gz |head -n1) $ pwd /tmp/gsl $ ./configure LDFLAGS="/opt/local/lib" CPPFLAGS="-I/opt/local/include" checking for gcc... gcc checking for C compiler default output... configure: error: C compiler cannot create executables See `config.log' for more details.正しいオプションは下記です。

$ ./configure LDFLAGS="-L/opt/local/lib" CPPFLAGS="-I/opt/local/include" checking for gcc... gcc checking for C compiler default output... a.out checking whether the C compiler works... yes [以下略]参考になりますでしょうか。

大学生K (2008-01-24 (木) 04:45:22)

Rでパワーアナリシスをできる検定方法は、

t-test,anova,propのほかにはないのでしょうか?

個人的にノンパラメトリックを含め、いろいろな検定手法に対する、パワーアナリシスを行う必要がありまして・・・ご教授ください。

田島 (2008-01-18 (金) 22:06:14)

はじめまして。田島と申します。突然のお尋ねで恐縮ですがよろしくお願いいたします。

WindowsXpにてR-2.6.1+MinGWにて下記のCコードをコンパイルしました。コンパイルに関するエラーは出ませんので、includeの問題はなさそうですが、seq[i]という入力ベクトルにどんな値が入っていても返り値であるsfというベクトルのすべての要素に0が返ります。ためしに、すべての返り値にsin(1.0)という固定値を代入するようにしても0が返るはずはないのですが、すべて0と返ります。私だけの環境で生じている可能性もあろうかと思いますので、初心者Q&Aがふさわしいかもしれませんが、なぜか書き込みができませんでしたので、こちらに投稿させていただいております。

その他の四則演算をするコードでは、期待した結果が返ります。

あまりコンパイルするような作業の経験はないのですが、なんかのパスが悪いのかと思いますが、お恥ずかしいことにかなり検索などもしましたがどこに問題があるか見当がつかない状況です。三角関数を使いたいだけということですので、四則演算で計算するアルゴリズムをつかって計算すればいいのですが、本来できることができていないのであれば、非常に気持ち悪いことですし、今後のために理解を深めたいということもありまして、お尋ねしているしだいです。

もし、ほかにお尋ねすべき適切なセッションがあれば、ご指導いただければ幸いです。どうぞよろしくお願いいたします。

test1.c#include <math.h> void test1(double *seq, int *seqn, double *sf) { int i; for(i=0;i<=*seqn-1;i++){ sf[i] = sin(seq[i]); } }やったこと

Rcmd SHLIB test1.cR上でやったこと

dyn.load("test1.dll") a<-seq(0,pi,length=10) .C("test1",as.double(a),length(a),sf=double(length(a)))$sf

こはく (2008-01-12 (土) 22:14:03)

繰り返しのない2元配置(乱塊法または反復測定一元配置(対応のある一元配置?))で分析できるデータがあります。

これをボンフェローニの補正をおこなって多重比較するために、たとえば

a <- rep(1:3, each=4)

b <- rep(1:4, 3)

x <- c(7, 8, 5, 8, 1, 14, 16, 11, 7, 7, 6, 8)

pairwise.t.test(x,a,p.adjust.method="bonferroni")

pairwise.t.test(x,b,p.adjust.method="bonferroni")

ってかんがえたのですが、Rをはじめたばかりでよく分かりません。

ご意見いただけるとうれしいです。

atte (2007-12-01 (土) 11:05:31)

scatterplot3dのグラフを回転させたいのですが、angleではxy方向しか回転できません。xz、yz方向に回転する方法はないのでしょうか。

PC1 PC2 PC3 a -0.2138188 -0.09690295 -0.056538208 b -0.1983966 -0.06068939 0.108130244 c -0.3581248 -0.04182101 0.157024270 d -0.2755906 -0.07243737 0.004878913 e -0.4614072 -0.02512825 0.006534084 f -0.3580950 -0.11927931 0.036777825 g 0.2977400 0.60951743 0.180188932 h 0.3043281 0.62594929 0.290022187 i 0.1160385 -0.55632764 0.073677929 j 0.7941420 -0.39650995 0.289428417 k 0.4994019 -0.38653550 -0.234907993 l 0.3296465 0.32195986 -0.691875477 m -0.2982350 -0.06277819 -0.159138712 n -0.1776291 0.26098297 -0.004202413で、次のようにrglを試してみました。

pcalabel<-row.names(pca3) #各プロットにつけたいラベルの名前。

rgl.bg(color=c("white","black"))

rgl.lines(c(-1,1),0,0,color="black")

rgl.lines(0,c(-1,1),0,color="black")

rgl.lines(0,0,c(-1,1),color="black")

rgl.texts(c(1,0,0),c(0,1,0),c(0,0,1),

text=c("PC1","PC2","PC3"),color="blue")

rgl.points(pca3,color=heat.colors(1000),size=2)

rgl.texts(pca3[,1],pca3[,2],pca3[,3],pcalabel,adj = 1) #ここでラベル付けにトライ

どこかplotのtype="h"をrgl.pointsのところに入れたらエラーが出たので、省きました。rp.plot3d {rpanel} R Documentation

Interactive display of a plot of three variables

Description

This function produces a scatterplot of three variables, using the rgl package

for three-dimensional display.

Usage

rp.plot3d(x, y, z, xlab = NA, ylab = NA, zlab = NA,

axes = TRUE, type = "p", size = 3, col = "red",

xlim = NA, ylim = NA, zlim = NA, ...)

Arguments

x,y,z vectors of observed values.

xlab a character variable used for the first axis label.

ylab a character variable used for the second axis label.

zlab a character variable used for the third axis label.

axes a logical variable determining whether the axes are shown.

type a character variable controlling the type of plotting.

If the value is set to "n", the points are not plotted.

size the size of the plotted points.

col the colour of the plotted points.

xlim the plotting range for the first variable.

ylim the plotting range for the second variable.

zlim the plotting range for the third variable.

... other rgl parameters which control the appearance of the plotted points.

Details

The plot is produced by appropriate calls to the rgl package. This allows

interactive control of the viewing position. Other objects may subsequently be

added to the plot by using rgl functions and data which are centred and scaled

by the returned values indicated below.library(rgl)

open3d()

pcalabel<-row.names(pca3) #各プロットにつけたいラベルの名前。

rgl.bg(color=c("white","black"))

rgl.lines(c(-1,1),0,0,color="black")

rgl.lines(0,c(-1,1),0,color="black")

rgl.lines(0,0,c(-1,1),color="black")

rgl.texts(c(1,0,0),c(0,1,0),c(0,0,1),

text=c("PC1","PC2","PC3"),color="blue")

rgl.points(pca3,color=heat.colors(1000),size=2)

text3d(pca3[,1],pca3[,2],pca3[,3],text=pcalabel,adj =1) #text3d()を利用似非R使い (2007-11-30 (金) 16:50:43)

初めて投稿させていただきます。

Rを用いた統計の教科書の中で、display()とあるのですが、その通り書き込んでもエラーが出ます。display()は削除されたか、別の関数に置き換わったのでしょうか?

SAStoR (2007-11-19 (月) 16:23:14)

初めて投稿させていただきます.

barplot()を使って棒グラフを作成したいのですが,長いラベル(全角16文字程度)がついています.dotchartのようにラベルを横に表示させるにはどうすればよいでしょうか.棒グラフの場合,horiz=Tを指定してもラベルは垂直方向になってしまうため,全て表示がされず困っています.

”barplot(),text(),names,長いラベル”の組み合わせで検索してみましたが,うまく情報を見つけられませんでした.

どうぞよろしくお願いいたします.A1 <- c(9,8,19,8,2,23,2,10) A1label<-c("AAAAAAA","BBBBBBBBBBBBBBBBBBBBBBB","CCCCCCCCCCCCCC", "DDDDDDDDDDDD","EEEEEEEEEEEEEEEEEE","FFFFFFFFFFFFFFFFFF", "GGGGGGGGG","HHHH") barplot(A1,names=A1label,horiz=T)

Saito (2007-11-13 (火) 15:55:26)

皆様、的確なご指摘ありがとうございました。

それぞれのコメントにお答えする前に、まずマルチポストに関してお詫び申し上げなければなりません。その件に関しては非常に軽率であり、マナーに欠けた行為であったと反省しております。統計学関連なんでも掲示板に投稿したあとに自分の質問がその掲示板に不適切だと判断してこちらに投稿したのですが、もう少しインターネット上のルールを勉強してから投稿するべきでした。さらに言葉を重ねますと、統計学関連なんでもありの掲示板に書き込みをしたあと確認を怠り、こちらの掲示板で皆様の非難の声を聞いてから統計学なんでもありの掲示板にコメントがなされているのを知った次第です。皆様に不快な思いをさせてしまい申し訳ありませんでした。

また、中級者用掲示板にこのような初心者の質問をしてしまったこともお詫びいたします。私の全くの勘違いなのですが、昨日の時点では初級者用掲示板がスパム防止のため封鎖した、というようなことが書いてあったので。しかし今はそんな文はどこにも記載されておらず、完全に私の勘違いでした。皆様にご迷惑をかけてしまい、申し訳ありませんでした。お詫びの言葉にもなっていないかもしれませんが、なにとぞご容赦ください。

>簡単でいいですから疑問点が再現できるような例(もしくは組込みデータを使った例)をつけてください。

質問する側として当然の配慮が欠けていました。申し訳ありません。私が扱っているデータは以下のような感じです。すみません何度も試したのですが、うまく表示できませんでした。> x StandardLength Feed Area 1 100 10 N 2 100 11 N 3 100 12 N 4 100 13 N 5 100 14 N 6 100 15 N 7 100 16 N 8 100 17 N 9 100 18 N 10 100 19 N 11 100 20 N 12 100 10 N 13 150 21 W 14 150 22 W 15 150 23 W 16 150 24 W 17 150 25 W 18 150 26 W 19 150 27 W 20 150 28 W 21 150 29 W 22 200 31 S 23 200 32 S 24 200 33 S 25 200 34 S 26 200 35 S 27 200 36 S 28 200 37 S 29 200 38 S 30 200 39 S > result=lm(StandardLength~Feed+Area) #StandardLengthを独立変数、 FeedとAreaを従属変数として重回帰 > summary(result) Call: lm(formula = StandardLength ~ Feed + Area) Residuals: Min 1Q Median 3Q Max -4.422e-14 -1.798e-15 1.179e-15 4.160e-15 9.431e-15 Coefficients: Estimate Std. Error t value Pr(>|t|) (Intercept) 1.000e+02 9.435e-15 1.060e+16 < 2e-16 *** Feed 2.209e-15 6.171e-16 3.579e+00 0.00139 ** AreaS 1.000e+02 1.332e-14 7.506e+15 < 2e-16 *** #問題2の該当箇所。 AreaW 5.000e+01 7.750e-15 6.452e+15 < 2e-16 *** --- Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1 Residual standard error: 9.815e-15 on 26 degrees of freedom Multiple R-Squared: 1, Adjusted R-squared: 1 F-statistic: 1.791e+32 on 3 and 26 DF, p-value: < 2.2e-16 > sd(Feed) #問題3の該当箇所。 今となっては恥ずかしいかぎりです。 [1] 9.123986 > sd(AreaS) 以下にエラーsd(AreaS) : オブジェクト "AreaS" は存在しません #問題1の該当箇所。 sd()が計算されないため、 前に投稿したやり方では標準化できませんでした。>result() とは? >summary()のことだと,思いますよ(^_^)

ご指摘のとおりです。Summary(result)の間違いでした。申し訳ありません。

>問題3はあなたの理解通りですが、なぜ両者が同じだと思ったのですか(そもそも sd() で何を計算したのかそこがわからぬ)

単純に標準誤差という言葉で表されるので同じ意味なのかな、と。

>稲垣宣生著「数理統計学改訂版」定理12.5(正規誤差仮定の下での回帰係数の分布)を見てください。

ご紹介ありがとうございます。また私の書いた問題3の中で、「その違いを述べている参考書は見当たりませんでした」とありますが、これは統計学的にではなく、Rの参考書の話です。誤解があったようで失礼致しました。

>sd() で,従属変数の標準偏差を調べたのでは?推測に過ぎませんが。

推測のとおりです。説明不足、配慮不足でした。申し訳ありません。

>問題1は,そもそも,変数の単位に明確な意味があるケースなのですから,標準偏回帰係数を算出する必要性が薄い気がします。

ご指摘のとおりです。カテゴリカルデータの傾きを知ったところで意味がないのは承知しているのですが、以前読んだ論文にカテゴリカルデータにも関わらず、GAM Coefficientというものを算出しているものがあったので…。現在本当にその意味(Coefficientを回帰係数と訳すこと)であっているのか読み直しているところです。

>他のソフトウェアでは,おそらく,カテゴリカルデータを0, 1で表現して,連続変量と同様の算出法をしていると思いますので,ご確認して,ご報告頂けると幸いです。

>問題2は,? contrasts を読むとわかるかと思います。

>問題3は,すでにご紹介された教科書を参照なさると解決するかと思います。

丁寧なご回答ありがとうございました。自分の勉強不足を実感しました。少し勉強してみます。稚拙なコメントしか返せず申し訳ありません。

>推測の必要はないので以下のように答えておきます。…

わかりやすい説明ありがとうございました。返す言葉もありません。もう一度勉強させてください。

この掲示板をマナーを守って利用している方々にご迷惑をおかけしたことを重ねてお詫び申し上げます。

StandardLength の予測値 = 100 + 0*Feed + 0*AreaN + 50*AreaW + 100*AreaSというもの。Feed にかかる係数は,実際は 2.209e-15,AreaNに掛かっている係数0は,ベースラインを示すので本当の0。

StandardLength の予測値バージョンII = 150 + 0*Feed - 50*AreaN + 0*AreaW + 50*AreaSそういうこと。-- 2007-11-13 (火) 17:13:48

Saito (2007-11-12 (月) 15:39:20)

初めて投稿させていただきます。

現在、統計ソフトRを使って卒業論文用のデータを解析しているのですが、重回帰をしているときに3つほど問題が出てきてしまいました。もしどなたか解決法をご存知でしたら、ご教授のほどよろしくお願いします。

問題1.カテゴリカル型データの標準化偏回帰係数が計算されない。

私は連続型とカテゴリカル型を同時に重回帰にかけているのですが、連続型のほうは

res <- lm(y~x1+x2+x3)

sdd <- c(0,sd(x1),sd(x2),sd(x3))

stb <- coef(res)*sdd/sd(y)

のような形でできたのですが、カテゴリカル型データはできません。しかし種々の参考書を見ると、カテゴリカル型データでも標準化偏回帰係数が出力されており、途方に暮れております。

問題2.カテゴリカル型データで一つの項目に複数の場合があるとき、うち一つが表示されない。

正確には表示されないことが問題なのではなくて、計算できないことが問題です。

例えば、

Yield=fertileのような関係を調べたいときに、カテゴリカル型データであるfertileの中にfertile1,fertile2,fertile3があったとします。これをそのまま重回帰にかけると、fertile2,fertile3の偏回帰係数やp値は表示されるのですが、fertile1は表示されません。Minitabの場合でしたら普通、fertile1の偏回帰係数はfertile1,fertile2,fertile3を足して、0になるように計算できる(らしい)のですが、Rはどうもそうではないような気がします。おそらく基準点のとり方が違うと思うのですが、どなたかRでの基準点をご存知でしたら教えていただけないでしょうか。

問題3.重回帰を行った際に、result()で出力される結果に含まれるStd.Errorと、sd()で出力される結果が違う。

おそらく前者が傾きに対する標準誤差の計算結果で、後者がデータそのものの標準誤差ではないか、という予測はしているのですが私の調べた限り、その違いを述べている参考書は見当たりませんでした。データがカテゴリカル型であった場合には、sd()では出力されないのに、Std.Errorでは出力されているので、傾きに対する標準誤差なのかな、と。せめて傾きに対する標準誤差の計算方法がわかれば検算できるのですが、それもわからなかったため質問させていただきました。

以上の3つです。もしどなたか解決法をご存知でしたら、ご教授のほどよろしくお願いします。

星野 (2007-11-01 (木) 14:42:36)

ヒストグラムのソースなのですが、# 2 群のヒストグラム hist2 <- function( x1, # 第一群のデータ x2, # 第二群のデータ brks=NULL, # 階級分割点 ...) # barplot に引き渡す任意の引数 { if (is.null(brks)) { # 階級分割点が与えられないときには,適切に設定 brks <- hist(c(x1, x2), right=FALSE, plot=FALSE)$breaks } c1 <- hist(x1, breaks=brks, right=FALSE, plot=FALSE)$counts # 度数1 c2 <- hist(x2, breaks=brks, right=FALSE, plot=FALSE)$counts # 度数2 barplot(rbind(c1, c2), beside=TRUE, space=c(0, 0.2), # 棒を並べて描く names.arg=brks[-length(c1)], # 横軸の目盛りラベル等 axisnames=TRUE, axis.lty=1, ...) }というソースを用いているのですが、このソースだとx1、x2が数値でないといけないというエラーがでてきてしまいます。また、Rに関係する本でヒストグラムについてみても同じように数値の例ばかりです...。これだと、1000個のデータをヒストグラムにする場合に入力が無理ではないでしょうか?データフレームからベクトルにして、ヒストグラムを描くような方法はないのでしょうか?よろしくお願いします。

data(USArrests) USArrests str(USArrests) x1<-USArrests$Murder x2<-USArrests$Rape str(x1) str(x2) hist2(x1,x2)

if (is.data.frame(x1)) x1 <- as.matrix(x1) if (is.data.frame(x2)) x2 <- as.matrix(x2)

x <- data.frame(matrix(1:12,ncol=3,dimnames=list(1:4,c("AAA","BBB","CCC"))))

x$"AAA"

x$AAA

x$AA

x$A

どれも同じ結果になるので、とっても幸せになれますね -- akira 2007-11-04 (日) 00:48:04> x <- data.frame(matrix(1:12,ncol=3,dimnames=list(1:4,c("AAA","BBB","CCC"))))

> x["AAA"]

AAA

1 1

2 2

3 3

4 4

> x[,"A"]

NULL> x[[1]] # 成分をベクトルとして取り出す「古風な」しかた [1] 1 2 3 4 > x[["AAA"]] [1] 1 2 3 4 > x[["A"]] # 二重鈎括弧演算子も補完機能を持つことも今回初めて知った [1] 1 2 3 4

R : Copyright 1997, Robert Gentleman and Ross Ihaka

Version 0.49 Beta (April 23, 1997)

R is free software and comes with ABSOLUTELY NO WARRANTY.

You are welcome to redistribute it under certain conditions.

Type "license()" for details.

[Previously saved workspace restored]

Error: workspace file corrupted -- no data loaded

Error in device("X11", as.character(c(display[1], paper)), as.double(c(width, : unable to start device X11

> x <- data.frame(matrix(1:12,ncol=3,dimnames=list(1:4,c("AAA","BBB","CCC"))))

> x$"AAA"

[1] 1 2 3 4

> x$AAA

[1] 1 2 3 4

> x$AA

[1] 1 2 3 4

> x$A

[1] 1 2 3 4青木.学生 (2007-10-31 (水) 14:17:21)

gstatでクリギングを行いたいのですが、予測グリッドデータの作成方法がわからなくて難航しています。

gstatマニュアルを読んで「RのGRASSパッケージにおいて国際横メルカトール・グリッドに変換した」ということはわかったのですが、具体的な方法がわからずにいます。

どなたかご存知の方がいらっしゃればご教示願えないでしょうか?

ちなみに現在The R BookについているR Ver1.9.0を使っています。

> xy <- expand.grid(1:100, 1:100) # これが予測位置グリッド座標

> names(xy) <- c("x", "y")

> g.dummy <- gstat(formula = z ~ 1, locations = ~x + y, dummy = TRUE,

beta = 0, model = vgm(1, "Exp", 15), nmax = 20)

> yy <- predict(g.dummy, newdata = xy, nsim = 4)緑茶 (2007-10-16 (火) 15:41:17)

RでARFIMAXも推定することはできるのでしょうか?

出来るのであれば、よかったらやり方を教えてください。

等々力渓谷 (2007-09-24 (月) 04:43:47)

CPUよりも浮動小数点計算が高速で並列処理に向いていると言われる、最近のGPU(Graphics Processing Unit)ですが*1、Rでもこれを非グラフィックの数値計算に利用するプロジェクトはあるのでしょうか?

堀内 (2007-09-02 (日) 11:46:25)

実験計画を作成するにあたり、検出力80%以上となるようにサンプル数を設定したいと考えておりますが、その際比較する2群のサンプル数を同数ではなく、1:9もしくは2:8程度としたいと考えております。

他のソフト(SAS、Power and precisionなど)ではこのような設定での算定ができるようですが、power.prop.testに関するマニュアル等を見る限りではやり方が見当たりません。

対応方法をご存知の方がいらっしゃればご教示願えないでしょうか?

(特別な引数設定の仕方がある!他の関数でできる!アドインを入れてこのようにコーディングすればできる!など)

片方のサンプルサイズNc,もう一方のサンプルサイズNt,その比r(=Nc/Nt)

Pc, Pt は属性を持つものの割合,Qc=1-Pc, Qt=1-Pt

P =(r Pc + Pt) / (r+1)

Zα=qnorm(α/2, lower.tail=FALSE)

Zβ=qnorm(β)

Nt ={Zα*sqrt((r+1) P Q)+Zβ*sqrt(r Pt Qt +Pc Qc)}^2 /(r(Pt-Pc)^2)

まちがいなく伝わったかどうか分からないので,浜島先生の本25-26ページを参照してください -- 2007-09-04 (火) 09:59:44> library(Hmisc)

> foo <- function(N) {

power <- bpower(p1=P1, p2=P2,

n1=N, n2=ceiling(Nratio*N), alpha=Alpha)

if (power >= Power) { # 要求パワーを越えた時点でストップ

cat(N, ceiling(Nratio*N), power, fill=TRUE); stop()}

}

> P1 <- 0.3; P2 <- 0.5; Nratio <- 0.2; Alpha=0.05; Power = 0.8

> sapply(100:10000, foo)

266 54 0.8003697

以下にエラーFUN(100:10000[[167L]], ...) : # これはループを中断したことによる注意で無視可能

> P1 <- 0.3; P2 <- 0.5; Nratio <- 0.3; Alpha=0.05; Power = 0.8

> sapply(100:10000, foo)

195 59 0.8002799

以下にエラーFUN(100:10000[[96L]], ...) :

> P1 <- 0.3; P2 <- 0.35; Nratio <- 0.3; Alpha=0.05; Power = 0.8

> sapply(100:10000, foo)

2954 887 0.8002141

以下にエラーFUN(100:10000[[2855L]], ...) :

> P1 <- 0.3; P2 <- 0.35; Nratio <- 1; Alpha=0.05; Power = 0.8

> sapply(100:10000, foo)

1377 1377 0.8002008

以下にエラーFUN(100:10000[[1278L]], ...) :power.prop.test2 <- function( p1=NULL, p2=NULL, n1=NULL, r=NULL, sig.level=0.05, power=NULL)

{

if (sum(sapply(list(p1, p2, n1, r, sig.level, power), is.null)) != 1) {

stop("p1, p2, n1, r, sig.level, power のどれか一つだけを NULL とする")

}

power.function <- quote(bpower(p1=p1, p2=p2, n1=n1, n2=ceiling(n1*r), alpha=sig.level))

if (is.null(power)) {

power <- eval(power.function)

}

else if (is.null(n1)) {

n1 <- uniroot(function(n1) eval(power.function)-power, c(1, 1e7))$root

}

else if (is.null(p1)) {

p1 <- uniroot(function(p1) eval(power.function)-power, c(1e-5, 1))$root

}

else if (is.null(p2)) {

p1 <- uniroot(function(p2) eval(power.function)-power, c(1e-5, 1))$root

}

else if (is.null(r)) {

r <- uniroot(function(r) eval(power.function)-power, c(1e-5, 1000))$root

}

else if (is.null(sig.level)) {

sig.level <- uniroot(function(sig.level) eval(power.function)-power, c(1e-5, 0.99999))$root

}

else {

stop("internal error")

}

METHOD <- "Power calculation of the tow-sample proportion test."

structure(list(p1=p1, p2=p2, n1=ceiling(n1), n2=ceiling(n1*r), r=r,

sig.level=sig.level,power=power, alternative="two.sided",

method=METHOD), class="power.htest")

}

> power.prop.test2(p1=P1, p2=P2, n1=NULL, r=0.2, power=0.8)

Power calculation of the tow-sample proportion test.

p1 = 0.3

p2 = 0.5

n1 = 266

n2 = 54

r = 0.2

sig.level = 0.05

power = 0.8

alternative = two.sided

> power.prop.test2(p1=P1, p2=P2, n1=NULL, r=1, power=0.8)

Power calculation of the tow-sample proportion test.

p1 = 0.3

p2 = 0.5

n1 = 93

n2 = 93

r = 1

sig.level = 0.05

power = 0.8

alternative = two.sided

> power.prop.test2(p1=P1, p2=P2, n1=266, r=NULL, power=0.8)

Power calculation of the tow-sample proportion test.

p1 = 0.3

p2 = 0.5

n1 = 266

n2 = 54

r = 0.1992972

sig.level = 0.05

power = 0.8

alternative = two.sided

> power.prop.test2(p1=P1, p2=P2, n1=266, r=0.2, power=NULL)

Power calculation of the tow-sample proportion test.

p1 = 0.3

p2 = 0.5

n1 = 266

n2 = 54

r = 0.2

sig.level = 0.05

power = 0.8003697

alternative = two.sided## 二項分布 B(n,p),B(m,p) に従う独立標本 N 個を有意水準 1-alpha で

## 両側検定したとき棄却される割合(標本検出力)を計算する関数

> foo <- function(N,n,p,m,q, alpha) {

X <- rbinom(N,n,p) # B(n.p) に従う標本N個

Y <- rbinom(N,m,q) # B(m,q) に従う標本N個

phat <- (X+Y)/(n+m) # 帰無仮説p=qの下での共通比率の推定値

S <- sqrt((1/n+1/m)*phat*(1-phat)) # 帰無仮説の下での(X/n-Y/m)の標準偏差推定値

z <- qnorm(1-alpha/2) # 両側検定棄却限界値

mean(abs(X/n - Y/m)/S > z) # N 回の検定で棄却される標本比率

}

> bar <- function(n) { # m=0.2*n のケース

x <- foo(2e6, n, p, ceiling(0.2*n), q, alpha)

cat(k, ceiling(0.2*n), x, fill=TRUE)

}

# 実行例

> p=0.3; q=0.5; alpha=0.05; beta=0.8

> set.seed(1); sapply(260:300, bar)

260 52 0.7882775

261 53 0.793533

262 53 0.795987

263 53 0.791743

264 53 0.7943355

265 53 0.797369

266 54 0.802263 # 標本検出力が初めて80%を越える標本数(bpower関数の場合,266 54 0.8003697,とほぼ一致)

267 54 0.799412

268 54 0.801248

269 54 0.8035085

.................Blueblink (2007-08-22 (水) 01:18:17)

スプラインを用いたセミパラメトリック回帰をRで行いたいと考えております。まず,mgcvライブラリのgam関数を用いることを試みました。

こちらやこちらの文献では,gam関数のsオブジェクトを,平滑化スプラインを表すために用いています。例えば次のスクリプトで,変量Ozoneを3つの平滑化スプライン関数の和で説明する,加法モデルを求めることができるものとしています。>library(mgcv); data(airquality) >airq.gam<-gam(Ozone~s(Solar.R)+s(Wind)+s(Temp),data=airquality) >summary(airq.gam)ところが,help(gam)で見られるヘルプによると,mgcvのgamにおけるノンパラメトリック項(smooth term)には,罰則付きの回帰スプライン(Penalized Regression Spline)もしくは自由度を固定した回帰スプラインを用いると書いてあります。私の理解では,平滑化スプラインは共変量の数と同数の節点を用いますが,罰則付き回帰スプラインは計算負荷低減のため節点の数を抑えるもので,両者は異なります。

私は罰則付きの回帰スプラインの理論が良くわからないので,できればスプラインとして平滑化スプラインを用いたいのですが,本当にmgcvライブラリのgam関数で平滑化スプラインを用いることができるのでしょうか?

ご存知の方がいらっしゃいましたら,ご教授頂ければ幸いです。

どうぞよろしくお願いいたします。

有吉 (2007-07-11 (水) 17:15:20)

1万×3千〜4千ぐらいのサイズの行列(各要素は非負の実数)の特異値分解をしたいと思っています。

WindowsXPでR2.4を使って、

options("object.size"=160e+006)

memory.limit( size = 3072)

と設定してsvd()したのですが、メモリが足りなくなってできませんでした。

それで、転置行列とかけ合わせて3千〜4千×3千〜4千の対称行列にして固有値分解することにしたら、eigen()はできました。でも、そこでメモリ(ヒープ?)が足りなくなって、その後は行列演算ができなくなりました。

そこでいったんquit()してRを起動しなおして、行列演算を1つして、quit()して、起動しなおして、...の繰り返しになって作業が進みません。

上記のようなサイズの行列の特異値分解や固有値分解をして、さらに行列演算を続けていくにはどうしたらいいか教えていただけないでしょうか?

# 64bitOSで、64bitモードでmakeしたRを使えば、それで解決?

岩田 (2007-07-08 (日) 18:33:35)

はじめまして。最近 R を使い始めた、岩田と申します。RjpWiki の皆様の努力のおかげで、R に関する情報が手軽に手にはいることを、感謝しています。

さて、qcc を使って X-Bar 管理図を作成したいと思っています。元となるデータは Excel で一つの列に納めて作成し、csv として書き出したものを、read.csv で R に読み込ませました。

X-Bar 管理図を作成するには、このデータをサブグループに分けなくてはなりませんが、qcc にそのような機能はありますか? それとも、事前に複数列にまたがるテーブルに整形しなくてはならなかったのですか? たとえばサブグループサイズが5の場合、R または Excel 上で簡単に複数列にまたがるテーブルに整形しなおす方法はありますか? 皆様のお知恵を拝借できればと思います。

17 5 8 26 15 26 15 26 5 0 26 ...これを、5つごとのサブグループに区切って、X-Bar 管理図を作るのがねらいです。グループの区切り方は、具体的には、

17 サブグループ1 5 サブグループ1 8 サブグループ1 26 サブグループ1 15 サブグループ1 26 サブグループ2 15 サブグループ2 26 サブグループ2 5 サブグループ2 0 サブグループ2 26 サブグループ3 ...とする予定です。 qcc に自動で区切る機能があれば、それが一番手っ取り早いと思いますが、もしない場合は、データを整形して R または qcc に渡してあげなくてはならないだろうと予想しています。事前にデータを整形する場合のテーブルは、

サブグループ1 17, 5, 8, 26, 15 サブグループ2 26, 15, 26, 5, 0 サブグループ3 26, ...としなくてはならないようです。 以上で、私がやりたいことが伝わりましたでしょうか? 引き続きアドバイスをよろしくお願いいたします。 -- 岩田 2007-07-08 (日) 20:31:50

> x

[1] 1 14 19 5 8 4 8 10 1 4 16 7 3 18 8 20 4 1 8 12 7 8 3 12 10

[26] 19 5 15 8 9

> xx <- matrix(x, 6, 5, byrow=TRUE)

> xx

[,1] [,2] [,3] [,4] [,5]

[1,] 1 14 19 5 8

[2,] 4 8 10 1 4

[3,] 16 7 3 18 8

[4,] 20 4 1 8 12

[5,] 7 8 3 12 10

[6,] 19 5 15 8 9

> as.data.frame(xx)

V1 V2 V3 V4 V5

1 1 14 19 5 8

2 4 8 10 1 4

3 16 7 3 18 8

4 20 4 1 8 12

5 7 8 3 12 10

6 19 5 15 8 9x <- rnorm(1:20)

y <- c(rep(1, 4), rep(2, 6), rep(3, 10))

z <- data.frame("dat"=x, "sub.g"=as.factor(y))

とか -- 2007-07-09 (月) 17:10:02Ovation (2007-06-12 (火) 11:11:51)

Rでwavelet変換をやっていますが、コンター図を描こうとしたら、> filled.contour(Time,Frequency,t(z),nlevel=50,color.palette=topo.colors) 以下にエラーdiff(x) : 既定引数の再帰的な参照ですというエラーが出ました。

原因が分かる方、ご教授いただけると幸いです。

kd (2007-06-12 (火) 10:17:56)

NAN値もcプログラムに渡す方法はあるでしょうか?

試しに下記のcプログラムを書いて実験を行いますと,.C() のところでエラーを出すようで,

NAN値を含むデータはcプログラムに渡らないようです.#include <R.h> void countnan(double *x, int *n, int *count) { int i; for (i=0,*count=0;i<*n;i++) if (ISNAN(x[i])) (*count)++; } > countnan <- function(x){ n=length(x); .C("countnan",arg1=as.double(x), arg2=numeric(n),arg3=numeric(1))$arg3 } > x<-c(1, NA , 3 , 4) > countnan(x) 以下にエラーcountnan(x) : 外部関数の呼び出し(引数 1) 中に NA/NaN/Inf があります

> countnan <- function(x){

.C("countnan",arg1=as.double(x),

arg2=length(x),arg3=integer(1),NAOK=TRUE)$arg3 }

> countnan(c(1,2,NA,4))

[1] 1

cソースは

#include <R.h>

void countnan(double *x, int *n, int *count)

{

int i;

for (i=0,*count=0;i<*n;i++)

if (ISNAN(x[i])) (*count)++;

(*count)--;

if (ISNAN(R_NaReal)) (*count)++;

}パックマン (2007-06-07 (木) 16:28:32)

R で Windows CSSを利用している例はあるのでしょうか?

とも (2007-06-06 (水) 16:49:44)

クラスタリング結果のデンドログラムを解析して、ノードごとの高さやリーフの情報を得る関数を書いています。

ノードやリーフの情報をベクトルとして取得する方法を教えてください。例えば、("leaf","leaf","node","node")のような形で返してほしいです。

dendrapplyという関数を参考にして書いたコードを示しました。

ノードやリーフの情報を再帰的に取得して表示することはできます。

dendrogramでRjpWikiやGoogleを検索してみましたが分かりませんでした。

引数の参照渡しの方法が分かるとできると思います。

dendrapplyはもとのデンドログラムのグラフ構造と同じ構造を返してくるので使えませんでした。DNapplyTest <- function(d) { if (!is.leaf(d)) { for (j in seq_along(d)) Recall(d[[j]]) cat("node:",attr(d,"height"),"?n") }else{ cat("leaf:",labels(d),"?n") } } > DNapplyTest(as.dendrogram(hclust(dist(USArrests)))) leaf:Florida leaf:North Carolina node:38.52791 ... node:87.32634 node:168.6114 node:293.6228

## 文字列が長すぎるので適宜改行しています

> dhc <- as.dendrogram(hclust(dist(USArrests)))

> x <- capture.output(dendrapply(dhc, function(n) {cat(labels(n),"?n"); cat(attr(n,"height"),"?n")}))

> xx <- x[1:198] # 手作業で末尾につく無意味な部分を削除

> xx[5:20]

[5] "Florida North Carolina "

[6] "38.52791 "

[7] "Florida "

[8] "0 "

[9] "North Carolina "

[10] "0 "

[11] "Delaware Alabama Louisiana Alaska Mississippi South Carolina Maryland

Arizona New Mexico California Illinois New York Michigan Nevada "

[12] "64.99362 "

[13] "Delaware Alabama Louisiana Alaska Mississippi South Carolina "

[14] "48.72515 " lines(c(apx[c1], hc$height[i], hc$height[i], apx[c2]),

c(apy[c1], apy[c1], apy[c2], apy[c2]))f<-function(X){

ret<-NULL

f<-function(x){

if(is.leaf(x)){

attr(x,"label")

}else{

r<-c(sapply(x,f),recursive=T)

ret<<-rbind(ret,list(leafs=r,size=attr(x,"members"),height=attr(x,"height")))

r

}

}

f(X)

ret

}

r<-f(as.dendrogram(hclust(dist(USArrests), "ave")))関数定義

dend2nodelist <- function(hc) {

GetElement <- function(i, j) {

if (i < 0) {

if (j < 0) return(c(hc$labels[-i], hc$labels[-j]))

else return(c(hc$labels[-i], GetElement(hc$merge[j,1], hc$merge[j,2])))

} else {

if (j < 0) return(c(GetElement(hc$merge[i,1], hc$merge[i,2]), hc$labels[-j]))

else return(c(GetElement(hc$merge[i,1], hc$merge[i,2]),

GetElement(hc$merge[j,1], hc$merge[j,2])))

}

}

n <- length(hc$height)

leafs <- NULL

size <- integer(n)

for (i in 1:n) {

labels <- GetElement(hc$merge[i,1], hc$merge[i,2])

size[i] <- length(labels)

leafs[i] <- list(labels)

}

return(cbind(leafs=leafs, size=size, height=hc$height))

}

実行例

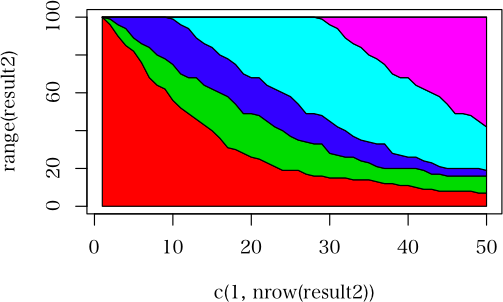

> hc <- hclust(dist(USArrests[1:10,]))

> result <- dend2nodelist(hc)

> result

leafs size height

[1,] Character,2 2 16.80625

[2,] Character,2 2 23.19418

[3,] Character,2 2 25.09303

[4,] Character,3 3 36.73486

[5,] Character,3 3 45.18296

[6,] Character,3 3 60.98073

[7,] Character,6 6 77.19741

[8,] Character,9 9 148.7357