![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

新規投稿はできません。

初心者のための R および RjpWiki に関する質問コーナー

過去の記事のアーカイブ。

きむ (2011-01-07 (金) 18:12:19)

いつも参考にさせていただいています。

現在、緯度経度で座標が指定されている地域標準メッシュ(3次メッシュ)の座標をある地点を基準としたx,y座標に換算しようとしています。

そこで、RjpWikiの、「RでGPS」を参考にlibrary(sp)のspDistsN1という関数を用いて距離を出そうとしているですがうまくいきません。library(sp) ll <- matrix(c(34, 34, 138, 139), ncol=2) km <- spDistsN1(ll, ll[1,], longlat=T) sum(zapsmall(km))とすると110.96kmとなりますが正確には92.38kmが正?また、

library(sp) ll <- matrix(c(34, 35, 139, 139), ncol=2) km <- spDistsN1(ll, ll[1,], longlat=T) sum(zapsmall(km))とすると結果が0になってしまいます。使用方法に誤りがあるのだと思いますがhelp等でも良くわかりません。すみませんが使用方法をご指導ください。

また、今のところ上記関数を用いて基準点からの距離で各メッシュの座標を設定しようとしていますが、直接緯度経度をx,y座標(平面直角座標系)に変換できる関数等がありましたら教えていただけると助かります。基本的な質問で恐縮ですがよろしくお願いいたします。

> library(sp)

> ll <- matrix(c(34, 35, 139, 139), ncol=2)

> km <- spDistsN1(ll, ll[1,], longlat=T)

> sum(zapsmall(km))

[1] 84.13467

> ll

[,1] [,2]

[1,] 34 139

[2,] 35 139

> km

[1] 0.00000 84.13467

> zapsmall(km)

[1] 0.00000 84.13467

> sum(zapsmall(km))

[1] 84.13467

どうなっているんでしょうね。 -- 河童の屁は,河童にあらず,屁である。 2011-01-07 (金) 19:04:12> library(sp) > ll <- matrix(c(139, 139, 34, 35), ncol=2) > km <- spDistsN1(ll, ll[1,], longlat=T) > sum(zapsmall(km)) [1] 110.8055なおRのバージョンは2.10.1であり、これを緯度-経度で入力すると結果が0になります。(ver2.9.2では河童様の結果のように84.13km)

> library(sp) > ll <- matrix(c(34, 35, 139, 139), ncol=2) > km <- spDistsN1(ll, ll[1,], longlat=T) > sum(zapsmall(km)) [1] 0次に東経138-139度、北緯34度の距離を出す場合(当初質問の1番目のケース)、測量計算で92.38kmとなるのに対して、経度-緯度で入力すると値が0となります。(逆に緯度-経度で入力すると110.96km)。

> library(sp) > ll <- matrix(c(138, 139, 34, 34), ncol=2) > km <- spDistsN1(ll, ll[1,], longlat=T) > sum(zapsmall(km)) [1] 0

yamada (2011-01-07 (金) 13:46:05)

表のような結果をsink(),print()でテキストファイルに出力しています。実際にクリップボードに格納したいのは、一列目の行ラベルを除いた、jp,hk,usの列だけですが、テキストファイルで範囲選択をすると、行ラベルを含んでしまいます。現在は、エクセルでスペース区切りを指定して開いていますが、スペース区切り等開くまでの操作が手間です。そこで、行ラベルを出力しないか、あるいは、行ラベル付きのデータで行ラベル除いて出力する方法はないでしょうか。jp uk us 1 -3.030863e-02 -2.523841e-02 -4.387615e-03 2 -1.594305e-02 -1.853893e-02 -1.499784e-02 3 9.720749e-03 8.167201e-03 1.648989e-02 4 -1.138466e-02 5.133008e-03 1.188763e-03

tadashi (2011-01-05 (水) 15:08:35)

やりたいことは、1列しかないCSVファイルを2つ読み込んで、共通部分を出力したいのです。できるだけ簡単に行う方法はあるでしょうか?

read.cvs で読み込むと下記のようにうまくいきません。

CSVから、データの作り方がうまくないのだと思いますが、どのコマンドを使えばいいのかがわかりません。> a <- read.csv('temp.1', header=FALSE) > b <- read.csv('temp.2', header=FALSE) > a V1 1 1 2 2 3 3 > b V1 1 3 2 4 3 5 > intersect(a, b) data frame with 0 columns and 0 rows

松代 (2010-12-31 (金) 14:08:35)

グレンジャー因果性の検定量をrestrictで制約した残差と制約無し残差を使って計算すると、教科書の計算結果(Eview)やエクセルの計算結果と大幅な違いが出ました。原因は制約付残差の違いでした。restrictの計算精度は悪いのでしょうか。

hashi (2010-12-30 (木) 17:22:31)

いつもお世話になっております。

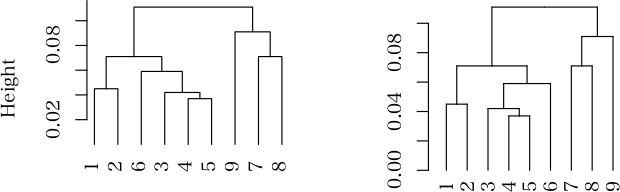

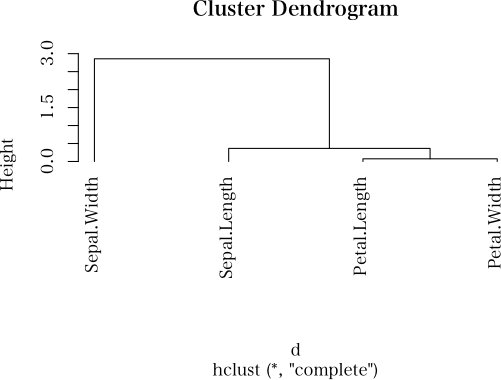

デンドログラムの回転方法ですが、青木先生著「Rによる統計解析」P230、図6.26を「初級Q&A アーカイブ(6)クラスター図を横向きで描画したい」の方法、horiz = T を前項のスクリプトのどの場所に挿入すれば回転したデンドログラムが表現できるのでしょうか。以下前項のスクリプトです。set.seed(123) x <- round(matrix(rnorm(100), ncol=5), 3) d <- dist(x) ans <- hclust(d^2, method="ward") pdf("cluster.pdf", height=375/72, width=500/72) plot(ans, hang=-1) dev.off()hang=-1の後ろに書き加え計算すると、

"horiz"はグラフィックスパラメータではありませんとメッセージが出ます。

> hc <- hclust(dist(USArrests)^2, "cen") > par(mar = c(4,1,1,7)) > plot(as.dendrogram(hc), horiz = T)は,ちゃんと動くのだから,

set.seed(123)

x <- round(matrix(rnorm(100), ncol=5), 3)

d <- dist(x)

ans <- hclust(d^2, method="ward")

pdf("cluster.pdf", height=375/72, width=500/72)

plot(as.dendrogram(ans), horiz=TRUE) # @@@ ここをこのように変更する

dev.off()

ということでしょう。 -- 河童の屁は,河童にあらず,屁である。 2010-12-30 (木) 17:35:14akira (2010-12-30 (木) 14:20:04)

いつもありがとうございます.

mvpartパッケージのrpart関数について質問です.

ヘルプを見ると、分岐指標に"gini"と"information"を選べるような記載がありますが、引数"parms"を変更しても結果が変わらないように思います.

同志社大の金先生のHPには、引数"split"とありますが、rpart関数、rpart.control関数は引数"split"を持たないようです.

一方、rpartのコード(40〜63行目ぐらいと思っていますが…)ではparmsが規定しているように見えます.

ご存知の方、いらっしゃいませんか?

> library(rpart)

# @@@ information を使用

> fit <- rpart(Kyphosis ~ Age + Number + Start, data=kyphosis,

+ parms=list(split='information'))

> fit2 <- rpart(Kyphosis ~ Age + Number + Start, data=kyphosis,

+ parms=list(split='gini'))

>

> library(rpart)

> fit <- rpart(Kyphosis ~ Age + Number + Start, data=kyphosis,

+ parms=list(split='information'))

> fit

n= 81

node), split, n, loss, yval, (yprob)

* denotes terminal node

1) root 81 17 absent (0.79012346 0.20987654)

2) Start>=12.5 46 2 absent (0.95652174 0.04347826) *

3) Start< 12.5 35 15 absent (0.57142857 0.42857143)

6) Age< 34.5 10 1 absent (0.90000000 0.10000000) *

7) Age>=34.5 25 11 present (0.44000000 0.56000000)

14) Number< 4.5 12 5 absent (0.58333333 0.41666667) *

15) Number>=4.5 13 4 present (0.30769231 0.69230769) *

# @@@ gini を使用(デフォルト)

> fit2 <- rpart(Kyphosis ~ Age + Number + Start, data=kyphosis,

+ parms=list(split='gini'))

> fit2

n= 81

node), split, n, loss, yval, (yprob)

* denotes terminal node

1) root 81 17 absent (0.7901235 0.2098765)

2) Start>=8.5 62 6 absent (0.9032258 0.0967742)

4) Start>=14.5 29 0 absent (1.0000000 0.0000000) *

5) Start< 14.5 33 6 absent (0.8181818 0.1818182)

10) Age< 55 12 0 absent (1.0000000 0.0000000) *

11) Age>=55 21 6 absent (0.7142857 0.2857143)

22) Age>=111 14 2 absent (0.8571429 0.1428571) *

23) Age< 111 7 3 present (0.4285714 0.5714286) *

3) Start< 8.5 19 8 present (0.4210526 0.5789474) *松代 (2010-12-28 (火) 15:54:34)

パッケージVARSを使うために解説書どおりに以下のコマンドを打ち込みましたが、最後コマンドの後に“以下にエラー Canada$e : $ operator is invalid for atomic vectors”という警告が出ました。対応策をご存じの方教えてください。> library(vars) > data(Canada) > layout(matrix(1:4, nrow = 2, ncol = 2)) > plot.ts(Canada$e, main = "Employment", ylab = "", xlab = "")

これ以上の情報はディレクトリ '/Library/Frameworks/R.framework/Versions/2.12/Resources/library/vars/doc' にある以下のビニエット中にあります: vars: VAR, SVAR and SVEC models (source, pdf)いずれにせよ「現行の文書中にはない」。私は,新しい文書を見ているので,古い文書に間違った(当時は正しかったのだろう)情報が書いてあるかもしれないという認識はなかった。

松代 (2010-12-25 (土) 00:07:03)

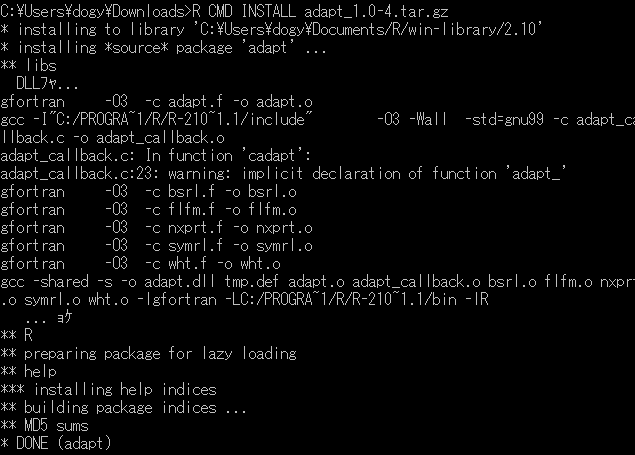

Windows7+R64 2.12.1でパッケージadaptをインストールできません。解決方法をご教示ください。> install.packages("adapt")~ パッケージを ‘C:\Users\fujimot\Documents/R/win-library/2.12’ 中にインストールします (‘lib’ が指定されていないので) --- このセッションで使うために、CRANのミラーサイトを選んでください --- 警告メッセージ: In getDependencies(pkgs, dependencies, available, lib) : package ‘adapt’ is not available

install.packages("cubature",dep=T) # インストール

library(cubature) # パッケージの呼び出し

?adaptIntegrate # 関数のヘルプ

f <- function(x) cos(x) # 1変数関数の場合

adaptIntegrate(f, 0, pi/2)

g <- function(x) { # 2変数関数の場合

exp(-(x[1]^2+x[2]^2)/2)/(2*pi)

}

adaptIntegrate(g, c(-3, -3), c(3, 3))ランゲル・ハンス (2010-12-21 (火) 09:00:38)

いつも掲示板を参考にさせていただいております。

以前も同じような質問をさせていただいたので、大変恐縮です。

NとMを10区間に区切って、その区間内に入るdの合計と平均を求めたいと思います。

下記の例(results1,results2)ではいくつかNAが出ます。NAを0として計算する方法を教えていただけないでしょうか?

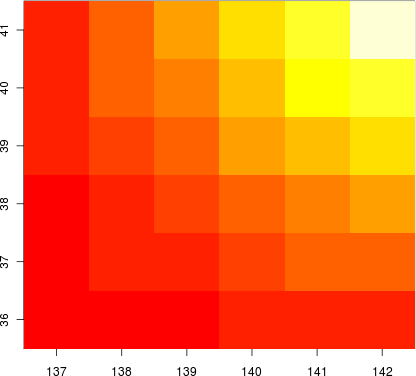

最終的には区間にすべて色の入るlevelplotを作図したいと考えています。N <- c(0, 1, 3, 7, 12, 20, 30, 45, 50, 81) M <- c(10, 20, 40, 60, 65, 75, 90, 95, 98, 100) d <- runif(10, 0, 10) data <- data.frame(cbind(N, M, d)) by1 <- cut(data$N, seq(0, 100, 10), right=TRUE, include.lowest=TRUE) by2 <- cut(data$M, seq(0, 100, 10), right=TRUE, include.lowest=TRUE) results1 <- cbind(tapply(data$d, list(by1, by2), sum)) results2 <- cbind(tapply(data$d, list(by1, by2), mean)) results1 results2 library(lattice) levelplot(results1) levelplot(results2)どうぞよろしくお願いいたします。

なつ (2010-12-20 (月) 22:13:28)

Rを使って,特定の値が連続して出現する回数の最大値を計算する方法を探しています。

例えば,特定の値=1としまして,a <- c(0, 1, 1, 1, 0, 0, 1, 1) b <- c(1, 1, 1, 1, 1, 0, 1, 0)という2つのオブジェクトがあるとします。

この場合,aからは3,bからは5という値を計算したいということです。

何か良い方法がありましたら,教えて頂ければ幸いです。

初歩的な質問で申し訳ありませんが,よろしくお願いいたします。

max(diff(c(0, which(b != 1), length(b)+1))-1)

yos (2010-12-19 (日) 20:39:01)

よろしくおねがいします.

1分おきで1日(0~1440分)に計測された,ある値があります.

1列目が,時間(0,1,2,...,1440)

2列目が,その時間における値(10, 40, ..., 50)

3列目が,グループ(A, B, C)

これを,

X軸を,例えば1時間おきの24分割

Y軸を,A, B, Cの3分割

で,値の平均値をプロットしたいのですが,色々調べてもどうしても方法が分かりません.

ご教授いただけないでしょうか

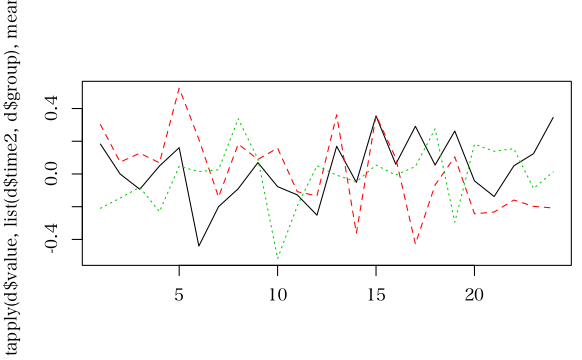

set.seed(123) d <- data.frame(time=0:1440, value=rnorm(1441), group=sample(factor(LETTERS[1:3]), 1441, replace=TRUE)) d$time2 <- d$time%/%60 d$time2[d$time2 == 24] <- 23 d$time2 <- factor(d$time2) matplot(tapply(d$value, list(d$time2, d$group), mean), type="l")

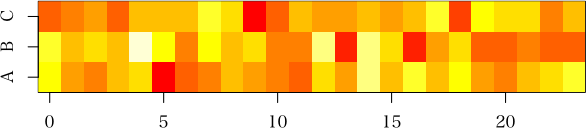

image(x=0:23, y=1:3, tapply(d$value, list(d$time2, d$group), mean), yaxt="n", ylab="", xlab="") axis(2, at=1:3, labels=LETTERS[1:3], pos=-0.5)

Kai (2010-12-12 (日) 15:31:30)

こんにちは。

lm()でデータAの一次回帰式を求め、predict()でデータBを回帰します。A_res <- lm(formula=Volume ~ Girth, data=trees) # データAの回帰結果 B <- trees+rnorm(dim(trees)[1]*dim(trees)[2]) # データBの作成 B_res <- predict(A_res, B$Girth) # データBの回帰B_resの回帰結果から自由度調整済み決定相関係数を求めたいのですが、どのようにすればよいのでしょうか?

ヘルプファイルを読む限りではse.fitという引数が関係ありそうな気がしたのですが、そこから先がよくわかりませんでした。

Rは2.11.1, OSはMac 10.5.8です。宜しくお願いします。

> trees <- data.frame(Volume=c(56, 54, 33, 58, 49), Girth=c(62, 44, 37, 57, 50)) > A_res <- lm(formula=Volume ~ Girth, data=trees) > B <- trees+rnorm(dim(trees)[1]*dim(trees)[2]) > B_res <- predict(A_res, newdata=B) # 予測値 > Se <- sum((B$Volume-B_res)^2) # 残差平方和 > n <- nrow(B) # データ数 > St <- var(B$Volume)*(n-1) # 全平方和 > MSe <- Se/(n-2) # 残差の平均平方 > MSt <- St/(n-1) # 全体の平均平方(不偏分散) > (CorrectedR2 <- 1-MSe/MSt) # 自由度調整済み決定係数という名前には当てはまらない,訳のわからない統計量 [1] 0.3946343

kouka (2010-12-11 (土) 22:07:24)

R全くの初心者です。igraphのパッケージは下記のようにインストールされるのですが、> utils:::menuInstallLocal() パッケージ 'igraph' は無事に開封され、MD5 サムもチェックされましたパッケージを読み込む際に、

> library(igraph) エラー: パッケージ 'igraph' は 'arch=i386' に対してインストールされていません。と表示されます。原因を教えていただけませんか?

YK (2010-12-11 (土) 19:53:30)

はじめまして。

被験者間因子と被験者内因子を含む分散分析に関する質問です。

先日、中級Q&Aに投稿した内容ですが、初級Q&Aが適切ではないかというご指摘をいただき、こちらに再投稿します。

Rのaov、nlmeパッケージのlme、carパッケージのAnovaと岡田先生のrep.aovで同じ結果が得られるのですが、SPSSや桐木先生のWEBの結果と一致しません(SPSSと桐木先生の結果は一致します)。

下記にサンプルを示します。

P値はfactor1, factor2, timeの順に0.044, 0.441, 0.017となりますが、SPSSや桐木先生のWEBでは順に0.042, 0.397, 0.575となります。

ダミーの結果を加えて被験者内因子の水準を3にしてみても結果は一致しません。

他のサンプルデータでも結果が一致するときとしないときがあるようです。

SPSSはType IIIで計算していますが、R側でtype IIIを指定しても一致しません。

原因についてどなたかご教示いただけましたら幸いです。ID <- factor(rep(c(1:32),2)) factor1 <- factor(c(0, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 1, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 1, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 1, 0)) factor2 <- factor(c(0, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 1, 0, 1, 0, 1, 1, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 1, 0, 1, 0, 1, 1, 1, 0, 1, 0, 1, 0)) time <- factor(c(rep(1,32), rep(2,32))) result <- c(102.56, 101.80, 123.72, 74.16, 34.12, 61.52, 54.08, 115.08, 58.96, 60.24, 111.68, 122.20, 45.04, 104.84, 121.48, 125.20, 45.48, 217.00, 39.40, 157.48, 119.96, 65.80, 4.44, 39.40, 65.80, 90.20, 45.48, 117.72, 83.04, 156.40, 42.72, 110.92, 135.52, 22.60, 129.08, 127.76, 149.12, 69.92, 73.24, 97.12, 114.92, 54.56, 170.08, 71.60, 179.96, 57.08, 199.88, 126.48, 59.56, 120.40, 53.56, 127.12, 66.48, 75.24, 268.64, 90.88, 102.48, 147.84, 116.84, 84.40, 147.84, 138.76, 122.96, 120.04) df <- data.frame(ID, factor1, factor2, time, result) rep.aov(result ~ I(time) + B(factor1, factor2) + S(ID), df)

net (2010-12-10 (金) 19:24:00)

R初心者です.

ネットワーク分析をして,ネットワーク図を描くときに,辺の太さを辺ごとに調整できるとされています.太さを与えるデータはベクトルでも隣接行列でもよいという解説がありました.

たとえば,重み付きグラフの隣接行列(たとえばwg)でグラフを描き,その重みに応じて各辺の太さを変えたい場合,辺の太さを指定するedge.lwdをつかって具体的にどのように表現したらいいでしょうか.

ちなみに,wgは作業ディレクトリにあるcsvファイルで,

wg<-as.matrix(read.csv("XXXXX(ファイル名)".csv))

で既に定義してあるとします.

私は,

gplot(wg,

edge.lwd = wg)

として,グラフを描こうとしたら,エラーで「使われていない引数があります」として,edge.lwd = wgがでてしまいました.

具体的なスクリプトを教えていただけたら幸いです.

library(sna)

wg <-as.matrix(read.csv("test.csv",header=TRUE))

gplot(wg,

edge.lwd = wg)

test.csvのなかみ

A,B,C,D,E,F

0,8,0,0,0,0

0,0,0,1,0,1

0,6,0,0,0,0

0,0,0,0,0,0

0,0,0,0,0,2

1,0,0,0,2,0しょう (2010-12-10 (金) 02:48:02)

スペース区切りのテキストファイル(数百万行*9列)をRに読み込もうとしています。

ただ、元データの8列目が「備考」欄のため、scan(file="xxx.txt", sep="")を使うと備考のない部分は区切りのスペースと同じ扱いを受けてしまい、matrixを使って行列化するときにずれてしまいます。

read.tableを使うと「'289' 行目には,8 個の要素がありません」とエラーがでてしまい、読み込んでくれません。(288行目までは備考がなく、289行目で初登場のため)

read.delim("xxx.txt")を使うと、空白の備考欄に「NA」を入れてくれ、一番理想に近いのですが、1行目に備考がないため8列のフレームが作られてしまいます。

read.delimで列数を設定できればよいのですが、可能でしょうか?googleやRの書籍などで探したのですが見当たりませんでした。解決方法があればお教え願えると幸いです。よろしくお願いいたします。

R version=2.9.2, OS=Vista

ファイル

1 2 3 4 5 6 7 8

11 12 13 14 15 16 17 18

21 22 23 24 25 26 27 28 comment

31 32 33 34 35 36 37 38

実行結果

> read.delim("test.txt", header=FALSE, sep=" ")

V1 V2 V3 V4 V5 V6 V7 V8 V9

1 1 2 3 4 5 6 7 8

2 11 12 13 14 15 16 17 18

3 21 22 23 24 25 26 27 28 comment

4 31 32 33 34 35 36 37 38 #ファイル 1 2 3 4 5 6 7 8 11 12 13 14 15 16 17 18 21 22 23 24 25 26 27 28 31 32 33 34 35 36 37 38 41 42 43 44 45 46 47 48 51 52 53 54 55 56 57 comment 58 61 62 63 64 65 66 67 comment 68 71 72 73 74 75 76 77 78 #実行結果 read.delim(file="test.txt",sep="",header=F) V1 V2 V3 V4 V5 V6 V7 V8 1 1 2 3 4 5 6 7 8 2 11 12 13 14 15 16 17 18 3 21 22 23 24 25 26 27 28 4 31 32 33 34 35 36 37 38 5 41 42 43 44 45 46 47 48 6 51 52 53 54 55 56 57 comment 7 58 NA NA NA NA NA NA 8 61 62 63 64 65 66 67 comment 9 68 NA NA NA NA NA NA 10 71 72 73 74 75 76 77 78

4 31 32 33 34 35 36 37 38 NA 5 41 42 43 44 45 46 47 48 NA 6 51 52 53 54 55 56 57 comment 58 7 61 62 63 64 65 66 67 comment 68 8 71 72 73 74 75 76 77 78 NAみたいになるだけでしょう。その後で8列と9列をちゃんと解釈して代入し直せばよいですけど(面倒)。

txt <- readLines("test.txt")

n <- length(txt)

dat <- matrix(0, n, 9)

for (i in 1:n) {

str <- unlist(strsplit(txt[i], " "))

if (length(str) == 8) {

str[8:9] <- c("", str[8])

}

dat[i,] <- str

}

dat

実行結果

[,1] [,2] [,3] [,4] [,5] [,6] [,7] [,8] [,9]

[1,] "1" "2" "3" "4" "5" "6" "7" "" "8"

[2,] "11" "12" "13" "14" "15" "16" "17" "" "18"

[3,] "21" "22" "23" "24" "25" "26" "27" "" "28"

[4,] "31" "32" "33" "34" "35" "36" "37" "" "38"

[5,] "41" "42" "43" "44" "45" "46" "47" "" "48"

[6,] "51" "52" "53" "54" "55" "56" "57" "comment" "58"

[7,] "61" "62" "63" "64" "65" "66" "67" "comment" "68"

[8,] "71" "72" "73" "74" "75" "76" "77" "" "78"まさ (2010-12-08 (水) 17:45:28)

R commanderを動かそうとしている初心者です。MacOSX10.6、Rのバージョンは2.12.0です。install.packages("Rcmdr", dependencies=TRUE)

の後に、library(Rcmdr)

と入力すると以下のメッセージが来ました。

要求されたパッケージ tcltk をロード中です

Tcl/Tkインターフェースのロード中

となり、それから特に何も起こりません。 この後少し打ち込もうとすると、それ以上入力できず、終了せざるをえない状況です。良い解決策を教えていただけないでしょうか?またX11は立ち上がった状況でやってはいますが、解決できていません。よろしくご教授下さい。

also installing the dependencies ‘aplpack’, ‘relimp’ URL 'http://cran.md.tsukuba.ac.jp/bin/macosx/leopard/contrib/2.12/aplpack_1.2.3.tgz' を試しています Content type 'application/x-gzip' length 2077295 bytes (2.0 Mb) 開かれた URL ================================================== downloaded 2.0 Mb URL 'http://cran.md.tsukuba.ac.jp/bin/macosx/leopard/contrib/2.12/relimp_1.0-2.tgz' を試しています Content type 'application/x-gzip' length 37864 bytes (36 Kb) 開かれた URL ================================================== downloaded 36 Kb URL 'http://cran.md.tsukuba.ac.jp/bin/macosx/leopard/contrib/2.12/Rcmdr_1.6-2.tgz' を試しています Content type 'application/x-gzip' length 2647612 bytes (2.5 Mb) 開かれた URL ================================================== downloaded 2.5 Mb ダウンロードされたパッケージは、以下にあります /var/folders/mL/..../downloaded_packagesのようなログがコンソールに出ましたか?出ていないなら,インストールはうまくいっていないでしょう。

要求されたパッケージ tcltk をロード中です

Tcl/Tkインターフェースのロード中 終了済

要求されたパッケージ car をロード中です

要求されたパッケージ MASS をロード中です

要求されたパッケージ nnet をロード中です

要求されたパッケージ survival をロード中です

要求されたパッケージ splines をロード中です

Rcmdrのバージョン 1.6-2

次のパッケージを付け加えます: 'Rcmdr'

The following object(s) are masked _by_ '.GlobalEnv':

partial.cor

The following object(s) are masked from 'package:tcltk':

tclvalue

となるはずなので,やはりどこかおかしいのでしょう。なお,【X11については,ユーザは何にもしなくてもかまいません】。どこらあたりから脇道にそれているのかわかりますか?質問君 (2010-11-27 (土) 18:29:37)

plotの使いかたで質問です。x <- c(10, 20, 30, 40, 50, 60, 70, 80, 90, 100) y <- c(5, 6, 7, 1, 3, 5, 6, 7, 1, 3)これらのデータで、x[1]の時、y[1]をプロットし、x軸にそのままxの値を10〜100まで表示したいのですが、どうやればよいのでしょうか?

よろしくお願いします。

plot(x, y, xaxt="n") axis(1, at=x)とでもするかな?グラフの横幅はある程度大きくしないと総ての目盛り数字は書かれない(逆に言えば,総ての目盛り数字が書かれるまで横幅を大きくしてね)。

ランゲル・ハンス (2010-11-26 (金) 15:14:51)

aggregate関数について質問させていただきます。

以下のようなデータフレーム(data)があったとき、cut 関数で N を 10 区間に区切って、その区間における d の合計を求めたいと思います。ある区間において NA がある場合、NA を 0 として合計する方法を教えていただけないでしょうか?下記の例では (50, 60], (60, 70], (70, 80] の区間の合計を 0 としたいと思います。

どうぞよろしくお願いいたします。N <- c(0, 1, 3, 7, 12, 20, 30, 35, 50, 91) d <- runif(10, 0, 10) data <- data.frame(cbind(N, d)) by1 <- cut(data$N, seq(0, 100, 10), right=TRUE, include.lowest=TRUE) agg <- aggregate(data$d, by=list(by1), FUN="sum") agg

> cbind(sapply(levels(by1), function(x) sum(d[by1 == x])))

[,1]

[0,10] 21.574116

(10,20] 8.055110

(20,30] 3.415935

(30,40] 2.436897

(40,50] 9.260387

(50,60] 0.000000

(60,70] 0.000000

(70,80] 0.000000

(80,90] 0.000000

(90,100] 5.495600

> cbind(sapply(split(d, by1), function(y) sum(y))) # なども> table(by1)

by1

[0,10] (10,20] (20,30] (30,40] (40,50] (50,60] (60,70] (70,80] (80,90] (90,100]

4 2 1 1 1 0 0 0 0 1

> sapply(split(d, by1), function(x) length(x)) # これでもよいですけどね。大げさです。

[0,10] (10,20] (20,30] (30,40] (40,50] (50,60] (60,70] (70,80] (80,90] (90,100]

4 2 1 1 1 0 0 0 0 1超初心者 (2010-11-20 (土) 15:53:12)

空行の実行方法とプロンプト上で改行を行なう方法を教えてください!!

マニュアル等いろいろ探したんですが、全くわかりません。

初歩的すぎて申し訳ございませんが、よろしくお願いします。

> library(sem)次に,read.moments 関数,入力しますね。

> cor.1 <- read.moments(diag=FALSE, names=c("年齢", "個人年収",

+ "教育年数", "職業威信"))

そうすると,コンソールには「1:」というプロンプトが出ます。プロンプトに応じて,

1: 0.12107847 2: -0.28075478 0.2329769 4: -0.04963399 0.3954726 0.2921118を入力しますね。この入力が終わるとプロンプトは

7:になります。このあと,何も入力せずに,リターンキーを押すのです(つまり,空行を入力したことになるんだけど)。

Read 6 itemsと表示され,入力が完了した事になります。

cor.1を入力すれば,cor.1 の内容が表示されるでしょう。 -- 河童の屁は,河童にあらず,屁である。 2010-11-21 (日) 19:21:16

困り果ててます (2010-11-19 (金) 18:48:40)

日本語を含む固定長ファイルを読み込みたいのですが,うまくいきません。123あ 456 321いう789のような内容の test.txt というファイルがあり,1件目のデータをV1="123", V2="あ ", V3="456" と読みたいのですが,

read.fwf("test.txt", width=c(3, 4, 3))だと意図したように読めません。

readChar("test.txt", c(3, 4, 3), useByte=TRUE)としてみたのですが,1行目しか読めません。

解決法をご存知の方がいらっしゃいましたら是非 ご教示ください。

よろしくお願いします。

> read.fwf("test.txt", width=c(3, 2, 3))

V1 V2 V3

1 123 あ 456

2 321 いう 789

Macintosh 版の R では,全角でも半角でも,「一文字は一文字」ということですね。lc <- Sys.getlocale("LC_CTYPE")

Sys.setLocale("LC_CTYPE", "C")

read.fwf("test.txt", width=c(3, 4, 3))

Sys.setLocale("LC_CTYPE", lc)

とすればよいのかな?前後に余分な面倒な指定が必要なのか?Windows では,読み取り幅を,バイト単位で指定するということか。 -- 河童の屁は,河童にあらず,屁である。 2010-11-19 (金) 20:38:40> sessionInfo() R version 2.10.1 (2009-12-14) i386-pc-mingw32 locale: [1] LC_COLLATE=Japanese_Japan.932 LC_CTYPE=Japanese_Japan.932 [3] LC_MONETARY=Japanese_Japan.932 LC_NUMERIC=C [5] LC_TIME=Japanese_Japan.932 attached base packages: [1] stats graphics grDevices utils datasets methods baseです。もとのデータを編集するのは極力避けたいので,半角の空白2文字を全角空白1文字にするといった対処法は避けたいのと,例では全角文字しか出しませんでしたが,2行目の「いう」に相当するところに「ABCD」などの半角文字が入るケースもあり,半角2文字を全角1文字に変換するだけでは意図した読み込みができません。 他の環境のことはわかりませんが,Windowsでは読取幅を指定すると全角半角を問わず1文字単位で数えるようなので,読み取り幅をバイト単位で指定する方法がわからず,質問しました。-- 困り果ててます 2010-11-22 (月) 14:59:38

> lc <- Sys.getlocale("LC_CTYPE")

> Sys.setlocale("LC_CTYPE", "C")

[1] "C"

> a <- read.fwf("test.txt", width=c(3, 4, 3))

> Sys.setlocale("LC_CTYPE", lc)

[1] "Japanese_Japan.932"

> a

V1 V2 V3

1 123 あ 456

2 321 いう 789

のように、ちゃんとよめたけどなあ。 -- 河童の屁は,河童にあらず,屁である。 2010-11-22 (月) 15:27:44> lc <- Sys.getlocale("LC_CTYPE")

> Sys.setlocale("LC_CTYPE", "C")

[1] "C"

> test <- read.fwf("test.txt", width=c(3, 4, 3))

> Sys.setlocale("LC_CTYPE", lc)

[1] "Japanese_Japan.932"

> test

V1 V2 V3

1 123 あ 4 56

2 321 いう78 9

やはり文字単位でしか読み込めませんでした... -- 困り果ててます 2010-11-22 (月) 21:26:55con <- file(description="test.txt", open="r", encoding="shift-jis")

lc <- Sys.getlocale("LC_CTYPE")

Sys.setlocale("LC_CTYPE", "C")

test <- read.fwf(con, width=c(3, 4, 3))

Sys.setlocale("LC_CTYPE", lc)

test

close(con)

> test

V1 V2 V3

1 123 あ 4 56

2 321 いう78 9

のように,文字コードを指定して読み込もうとしてみたのですが,やはり結果は同じでした。 -- 困り果ててます。 2010-11-22 (月) 22:47:03> lc <- Sys.getlocale("LC_CTYPE")

> Sys.setlocale("LC_CTYPE", "E")

[1] "English_United States.1252"

> test <- read.fwf("test.txt", widths=c(3, 4, 3))

> Sys.setlocale("LC_CTYPE", lc)

[1] "Japanese_Japan.932"

> test

V1 V2 V3

1 123 あ 456

2 321 いう 789

ありがとうございました。 -- 困り果ててます 2010-11-23 (火) 14:11:15質問君 (2010-11-18 (木) 22:04:57)

エクセルでMM法を乱数で実行してるのですが、Rの乱数の方が良いと聞いたので、Rでも試したいのですが、エクセルとの擬似乱数比較について、Rが優れているなど分かりやすく、紹介されてるサイトや記事はないのでしょうか?たしかにエクセルよりも、乱数関数は多いです。性能的にはどうなのでしょうか?

探しても見当たりませんでした。もし、ご存知の方がいらっしゃれば、お願いします。

NT (2010-11-17 (水) 20:14:57)

3 段階評価 (0, 1, 2) の尺度の項目母数を grm 関数によって求めてみました。

出力結果の二行のみ示すと以下の通りとなります。Extrmt1 Extrmt2 Dscrmn Item1 -1.719 -0.126 1.553ここで Extrmt1 とは評価点 0 と 1 の項目曲線が交わる地点のθの値、Extrmt2 とは評価点 1 と 2 の項目曲線の交わる地点のθの値と解釈してよいのでしょうか。

ご教示願います。

Saito (2010-11-17 (水) 01:37:43)

いつもお世話になっております。

この手の話は既出かと思い検索しましたが、見つけることが出来なかったので質問させてください。

ある座標セットaを持っています。この座標セットには、座標とそれに付随する価が入っています。もう一つ別の座標セットbを持っています。こっちには、座標しか入っていません。今、座標bに最も近い座標aの持つ付随値を補間したいと考えています。下記にサンプルプログラムを示します。> ###座標とそれに付属する価### > a <- data.frame( + expand.grid(Long=seq(11, 13), + Lat=seq(20, 23)), + value=seq(1, 12) + ) > ###マッチさせる数### > num <- 1000 > > ###座標しか分かっていない### > b <- data.frame(long=runif(num, 11, 13), + lat=runif(num, 20, 23) + ) > head(b) long lat 1 12.00220 21.48183 2 11.14583 21.13535 3 12.31510 20.28334 4 11.54138 21.18872 5 11.66167 20.76173 6 12.52289 21.27551 > ###全ての組み合わせから最近接距離を持つ座標を特定### > dis <- NULL > for(i in 1 : nrow(b)) { + dis <- sqrt((b[i, 1] - a[, 1])^2 + (b[i, 2] - a[, 2])^2) + b[i, 3] <- a[which(dis==min(dis))[1], 3] #i番目のbがどのaに最も近いか探し出 してマッチング + } > head(b) long lat V3 1 12.00220 21.48183 5 2 11.14583 21.13535 4 3 12.31510 20.28334 2 4 11.54138 21.18872 5 5 11.66167 20.76173 5 6 12.52289 21.27551 6

しかし、実際にはaもbも超巨大で、この方法だとものすごく時間がかかることがあります。上記プログラムをもっと高速化するにはどうすればよいでしょうか。どなたかわかる方がいらっしゃいましたら、ご助言頂けると幸いです。

> a <- data.frame(

+ expand.grid(Long=seq(slong, elong),

+ Lat=seq(slat, elat)),

+ value=seq(1, elong*elat)

+ )

> b <- data.frame(long=runif(num, slong, elong),

+ lat=runif(num, slat, elat)

+ )

>

> dis <- NULL

> pp_a <- ppp(x=a[, 1], y=a[, 2], c(slong, elong), c(slat, elat))

> pp_b <- ppp(x=b[, 1], y=b[, 2], c(slong, elong), c(slat, elat))

>

> system.time(

+ for(i in 1 : nrow(b)) {

+ dis <- sqrt((b[i, 1] - a[, 1])^2 + (b[i, 2] - a[, 2])^2)

+ b[i, 3] <- a[which(dis==min(dis))[1], 3] #i番目のbがどのaに最も近いか探し 出 してマッチング

+ }

+ )

user system elapsed

17.19 0.00 17.20

>

> system.time(

+ b[, 4] <- a[nncross(pp_b, pp_a)$which, 3]

+ )

user system elapsed

0.01 0.00 0.02

>

> head(b)

long lat V3 V4

1 54.32715 76.365028 7554 7554

2 90.84222 7.004393 691 691

3 88.88978 93.650574 9389 9389

4 61.72731 8.535613 862 862

5 73.77037 6.405291 574 574

6 95.42776 92.221599 9195 9195カワウソ (2010-11-15 (月) 19:11:55)

はじめまして。

n個の従属変数(y1,y2,…,yn)と一つの独立変数xに関して,if構文を使って以下のような作業を一度に行うにはどのようにプログラムを書いたらよいのでしょうか?lm(y1 ~ x + g) lm(y2 ~ x + g) ・ ・ ・ lm(yn ~ x + g)

> iris.ancova <- for (i in 2:4) lm(iris[,i]~iris[,1] + iris[,5]) > summary(iris.ancova) Length Class Mode 0 NULL NULL > iris.ancova <- for (i in 2:4) summary(lm(iris[,i]~iris[,1] + iris[,5])) > iris.ancova NULL

for (i in 2:4) print(summary(lm(iris[,i]~iris[,1] + iris[,5])))

ダルビ (2010-11-10 (水) 21:24:20)

初めまして。

Rコマンダーで特定のデータセットを削除するにはどうすればよいのでしょうか?

いろいろなデータセットができてしまって困っています。

お手数ですが、よろしくお願います。

Jam (2010-11-08 (月) 17:07:02)

初めまして。

clusterライブラリで利用できるk-meansとpamの挙動について質問です。

2次元のxy座標で示せるデータをk-meansとpamでクラスタリングをしていて気になることがありました。それはpamの実行結果が毎回同じであるということです。

私の解釈として、どちらの手法も初期のランダムサンプルに結果が依存するため、クラスタリング結果は同じデータ・設定で実行したとしても毎回変わると思っています。確かにk-meansでは実行の度に結果は変わることは確かに確認できるのですが、pamではクラスタリング結果が毎回同じです。

クラスタリング結果が同じというのは、plotした図、result$centers (k-meansの場合)、result$medoids (pamの場合)を見て判断しています。データ数は1000弱です。

これはどういうことなのでしょうか?pamのランダムサンプルはクラスタリング結果に依存する、つまり結果は毎回多少でも異なってくると思うのです。k-menansの$cnetersは実行のたびに異なるが、pamの$medoidsは毎回同じ値になることは以下のプログラムで確認しました。

検証プログラム。library(cluster) # (x, y)形式のデータを読み込む data <- read.table(var.in_file, header=F, sep="\t") ################ # pam clustering # ################ data.clust <- pam(data, 10) data.clust$medoids ################ # k-means clustering # ################ data.clust <- kmeans(data, 10) data.clust$centers

MKI (2010-11-06 (土) 05:26:32)

散布図にLOESS()で平滑化曲線を加えたあと、その信頼区間を合わせてグラフに描画したいのですがそれらしい関数が見あたらず、もしどなたかご存じでしたら教えて下さい。できれば信頼区間を95%以外にも自分で変更できれば助かります。

nan (2010-10-31 (日) 18:35:42)

初めまして。

リストの成分にアクセスしたいのですが、例えば以下のようなデータについて> test <- function(x) {y=log(x); z=sin(x); return(list(value=x, log=y, sin=z))} > test(1:3) $value [1] 1 2 3 $log [1] 0.0000000 0.6931472 1.0986123 $sin [1] 0.8414710 0.9092974 0.1411200$logの[0.0000000]や$sinの[0.9092974]にアクセスするにはどのようにすれば良いのでしょうか?

宜しくお願いします。

> foo <- test(1:3) > class(foo) [1] "list" > class(foo$log) [1] "numeric" > foo$log[1] [1] 0 > foo$sin[2] [1] 0.9092974

のの (2010-10-31 (日) 04:07:34)

データフレームxの中の列名(変数名)aについて> attach(x) > x <- ifelse(a=="", NA, a)とすると、空の値を欠損値NAと指定できます。

しかし、aがfactorだった場合には、factorの性質が失われてしまうようです。

何かもっとエレガントな方法はあるのでしょうか?> x <- subset(x, a != "") > table(a, useNA="always")これも違うようです。

MKI (2010-10-29 (金) 22:29:49)

多変量解析を行い、意味のありそうな説明変数を取り出す作業をした後、それをブートストラップ法によってreliabilityを確認するよう求められました。Rでやってみたいと思いますが、「entry criteriaをp<=0.10にしてretention criteriaをp<0.05で確認する」ように指示されましたがstepAICでできるのでしょうか。方法としては

1.スプレッドシートからランダムにサンプリング(重複あり)

2.一般化線形モデルに当てはめ

3.stepAIC???で残った説明変数を抽出

4.1〜3を1000回繰り返す

といった感じになるかと思うのですが3.の部分が方法として正しいのかどうか分かりません。あるいは同じようなこと(多変量解析+ブートストラップ法)ができるパッケージはありますか。もしご存じでしたら教えて下さい。

hashi (2010-10-28 (木) 05:34:07)

Q&A (初級者コース)/11であった「任意の X 軸と曲線との交点(Y 値)の値の算出」の逆のことをしたいのです。

以下がデータです。x <- c(2:10) y <- c(0.084, 3.642, 12.472, 27.262, 47.035, 67.439, 83.974, 92.767, 100) plot(x, y, xlim = c(2, 10), ylim = c(0, 100)) lines(spline(x, y, n = 20), col = 2)このとき、abline(h = 5) を作図したときスプライン曲線との交点を読みたいのですが、どのようにしたらよいのでしょうか。

どうかよろしくご教授お願いいたします。

solve.spline <- function(x, y, y.val, x.init)

{

fun <- splinefun(x, y)

x <- x.init

repeat {

x2 <- (y.val-fun(x))/fun(x, 1)+x

if (abs(x-x2) < 0.0001) return(mean(c(x, x2)))

x <- x2

}

}

使用例

> solve.spline(x, y, 5, 4.5) # y=5 になる

[1] 3.205662 # x の値

> solve.spline(x, y, 30, 6) # y=30 になる

[1] 5.150513 # x の値

> fun <- splinefun(x, y) # これがスプライン曲線の関数

> fun(5.150513) # x=5.150513 のとき

[1] 30.00001 # y=30.00001 になってるMKI (2010-10-27 (水) 13:17:49)

データフレームの各列毎にある条件(たとえば0.1以上など)を満たす要素をカウントするにはどうしたらよろしいでしょうか。apply関数で各列のmeanなどは簡単に得られますが、似たような方法でカウント数を得ることは可能でしょうか。

sh (2010-10-27 (水) 09:17:04)

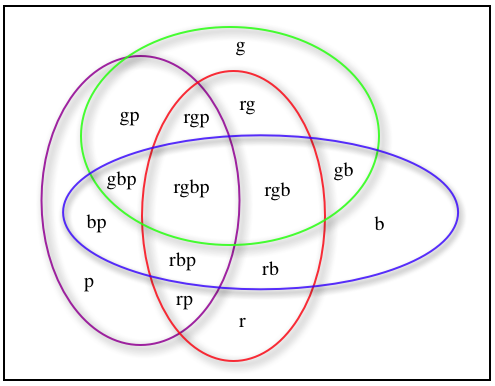

4つの集合のベン図をRで描くにはどうすればよろしいでしょうか? [参考文献] http://ja.wikipedia.org/wiki/ベン図 多数の集合のベン図 http://www.ats.ucla.edu/stat/r/faq/venn.htm R FAQ: How can I generate a Venn diagram in R? vennDiagram Can't plot Venn diagram for more than 3 sets

venn4 <- function(counts, col=c("red", "green", "blue", "purple"), lwd=2, labels=NULL, delta.y=7, ...)

{

elp <- function(x0, y0, a, b, col, lwd)

{

theta <- 0:360/180*pi

x <- x0+a*cos(theta)

y <- y0+b*sin(theta)

lines(x, y, col=col, lwd=lwd)

}

plot(c(0, 254), c(0, 202), type="n", axes=FALSE, xlab="", ylab="", ...)

x0 <- c(112, 116, 125, 68)

y0 <- c( 88, 134, 90, 90)

a <- c( 45, 78, 95, 45)

b <- c( 75, 50, 43, 75)

for (i in 1:4) {

elp(x0[i], y0[i], a[i], b[i], col=col[i], lwd=lwd)

}

# "" r g rg b rb gb rgb p rp gp rgp bp rbp gbp rgbp

loc.x <- c(170, 120, 160, 118, 185, 135, 169, 134, 58, 89, 60, 91, 50, 90, 61, 95)

loc.y <- c( 30, 30, 150, 144, 80, 67, 112, 104, 36, 36, 138, 137, 85, 66, 107, 103)

text(loc.x, loc.y-!is.null(labels)*delta.y, labels=counts)

if (!is.null(labels)) {

text(loc.x, loc.y+delta.y, labels=labels)

}

}

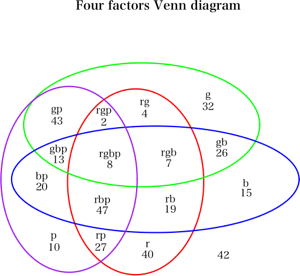

venn4(d$counts, labels=c( "", "r", "g", "rg", "b", "rb", "gb", "rgb", "p", "rp", "gp", "rgp", "bp", "rbp", "gbp", "rgbp"),

main="Four factors Venn diagram")

> d

r g b p counts

1 0 0 0 0 42

2 1 0 0 0 40

3 0 1 0 0 32

4 1 1 0 0 4

5 0 0 1 0 15

6 1 0 1 0 19

7 0 1 1 0 26

8 1 1 1 0 7

9 0 0 0 1 10

10 1 0 0 1 27

11 0 1 0 1 43

12 1 1 0 1 2

13 0 0 1 1 20

14 1 0 1 1 47

15 0 1 1 1 13

16 1 1 1 1 8

venn4(d$counts, labels=c( "", "r", "g", "rg", "b", "rb", "gb", "rgb", "p", "rp", "gp", "rgp", "bp", "rbp", "gbp", "rgbp"),

main="Four factors Venn diagram")

ランゲル・ハンス (2010-10-26 (火) 10:29:21)

いつも掲示板を参考にさせていただいています。

さて、下記の行列mの各行の値を逆順にして、行列m2を作りたいと思います。

行列操作でmからm2を作る方法、あるいはdからm2を作る方法をご教示いただけないでしょうか?d <- c(1, 2, 3, 4, 5, 6, 7, 8, 9) m <- matrix(d, 3, 3, byrow=TRUE) d2 <- c(3, 2, 1, 6, 5, 4, 9, 8, 7) m2 <- matrix(d2, 3, 3, byrow=TRUE)どうぞよろしくお願いいたします。

yorudan (2010-10-25 (月) 17:22:10)

ハフ変換を行うためのパッケージはありますか!?

のの (2010-10-24 (日) 03:42:03)

library(gregmisc)を導入して、excelシートからデータを直接取り込む方法を試しています。

いくつかおかしな挙動をみつけたので書き込みます。

こちらの環境は、MacOS10.6.4, GUI版R version 2.11.1 (2010-05-31) x86_64-apple-darwin9.8.0 です。

他の環境で、同じ状況が再現するのかも教えて欲しいです。

1. エクセルシートの中で、"'’"または"…"を使っていると次のエラーが出る。Wide character in print at /Library/Frameworks/R.framework/Resources/library/gdata/perl/xls2csv.pl line 262.調べた範囲では、たぶん内部処理でperlに文字列を渡すときに文字コードエラーを起こしているのだと思います。ただデータは正しく取り込まれるので実質的な問題はないように思います。

これがサンプルファイルです。

2. サンプル数が増えてしまう

こちらの方が問題が大きいです。Rはエラー表示しませんが、変なレコードが追加されて、データフレームに影響を与えます。

試行錯誤して、""',"この文字列を含むとおかしくなることは再現できました。

これがサンプルファイルです。

まだ、library(gregmisc)開発サイトの方は良く調べていないのでこれから調べて何か分かればこの記事を更新する予定です。

MKI (2010-10-22 (金) 13:29:37)

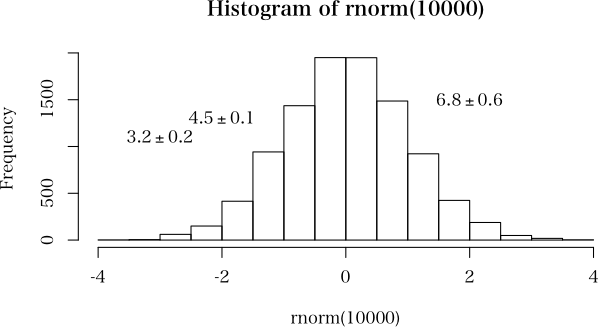

図(グラフ)の中に平均(変数)+/-標準偏差(変数)を書き込みたいのですがexpressionを使用してもうまくいきません。ひとつひとつ数字を書き込めば

可能ですが、変数などと組み合わせて表示する方法はないでしょうか。

plot(hist(rnorm(10000)))

mean <- c(3.2, 4.5, 6.8)

sd <- c(0.2, 0.1, 0.6)

x <- c(-3, -2, 2)

y <- c(1100, 1300, 1500)

for (i in 1:3) {

str <- sprintf("text(%f, %f, labels=expression(%f%%+-%%%f))", x[i], y[i], mean[i], sd[i])

eval(parse(text=str))

}

plot(hist(rnorm(10000)))

mean <- c(3.2, 4.5, 6.8)

sd <- c(0.2, 0.1, 0.6)

x <- c(-3, -2, 2)

y <- c(1100, 1300, 1500)

str <- sprintf("text(%f, %f, labels=expression(%f%%+-%%%f))", x, y, mean, sd)

eval(parse(text=str))しげゆき (2010-10-18 (月) 10:39:18)

XPでR2.11.1の初心者です。よろしくお願いします。

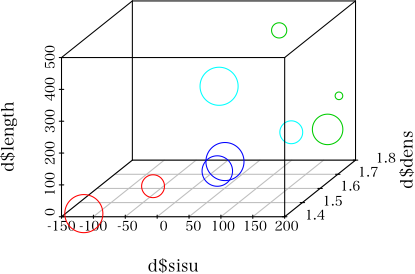

scatterplot3dでプロットの色、サイズを変えた図を作成していますが、色はデータどおりいきましたが、サイズがデータと食い違ってうまくいきませんでした。

以下データで左3列がXYZ軸、colorが色4種類、sizeが5段階です。sisu dens length color size 1 -115 1.4 9.8 A 5 2 -62 1.6 7.0 A 3 3 108 1.7 452.0 B 2 4 174 1.8 202.0 B 1 5 184 1.7 141.0 B 4 6 11 1.7 10.2 C 4 7 23 1.7 40.0 C 5 8 -14 1.8 232.0 D 5 9 127 1.7 132.0 D 3 scatterplot3d(x=d$sisu, y=d$dens, z=d$length, color=c(2,3,4,5)[unclass(d$color)], cex.symbols=c(1,2,3,4,5)[unclass(d$size)])cexを書き出しましたが、データどおりでおかしくありませんでした。

> c(1,2,3,4,5)[unclass(d$size)] [1] 5 3 2 1 4 4 5 5 3どこか間違っているのでしょうか。

のの (2010-10-14 (木) 11:05:44)

いつもお世話になります。 例えば、次のようなベクトルが二つあるとき、x <- c(1:10) y <- c(20:40) test(x)とtest(y)の結果が1でtest(c(x,y))の結果が2となるような関数testを作りたいのですが、何か良い方法があれば是非教えて下さい。 test <- function(i) { text <- as.character(match.call()[2]) if (grep("^c", text) != 1) {1} else {grep(",", text)} }のようになるのかと考えましたが上手くいきません。

> test <- function(arg)

+ {

+ sum(unlist(strsplit(deparse(substitute(arg)), ""))==",")+1

+ }

> x <- 1:10

> y <- 21:26

> z <- 31:48

> test(x)

[1] 1

> test(c(x, y))

[1] 2

> test(c(x, y, z))

[1] 3Saito (2010-10-13 (水) 13:00:02)

いつもお世話になっています。

過去ログ等検索しましたが、見つからなかったので質問させてください。

座標と座標に付与されたデータからなる3列のデータセットがあります。今、座標が細かすぎるので、もう少し粗い解像度に変換したいのですが、その変換プログラムが上手くいきません。以下に例を示します。> ###仮想データセット### > ###x, yが座標で、zが値### > mat <- data.frame(expand.grid(x=1:6, y=1:4), z=1:24) > mat x y z 1 1 1 1 2 2 1 2 3 3 1 3 4 4 1 4 5 5 1 5 6 6 1 6 7 1 2 7 8 2 2 8 9 3 2 9 10 4 2 10 11 5 2 11 12 6 2 12 13 1 3 13 14 2 3 14 15 3 3 15 16 4 3 16 17 5 3 17 18 6 3 18 19 1 4 19 20 2 4 20 21 3 4 21 22 4 4 22 23 5 4 23 24 6 4 24 > ###y軸方向に足し合わせたときの行列を用意### > mat2 <- data.frame(matrix(0, ncol=ncol(mat), nrow=nrow(mat)/2)) > > ###x軸方向にも足し合わせたときの行列を用意### > mat3 <- data.frame(matrix(0, ncol=ncol(mat), nrow=nrow(mat2)/2)) > > ###y軸の値がx軸方向にいくつ詰まってるのか確認### > a <- as.numeric(summary(as.factor(mat[, 2]))[1]) > > ###y軸方向に何度足せばよいのか確認### > b <- length(levels(as.factor(mat[, 2]))) > > ###等比数列でy軸の値をx軸方向に詰まっている分だけ足し合わせ### > for (i in 1 : (b/2)) { + mat2[((i-1)*a+1):(i*a), ] <- + mat[((2*a)*(i-1)+1):((2*a)*(i-1)+a), ] + + mat[((2*a)*(i-1)+(1+a)):((2*a)*(i-1)+(a*2)), ] + } > mat2 X1 X2 X3 1 2 3 8 2 4 3 10 3 6 3 12 4 8 3 14 5 10 3 16 6 12 3 18 7 2 7 32 8 4 7 34 9 6 7 36 10 8 7 38 11 10 7 40 12 12 7 42 > ###同様にx軸についても### > for(i in 1 : (nrow(mat2)/2)){ + mat3[i, ] <- mat2[(2*(i-1)+1), ] + mat2[(2*i), ] + } > mat3 X1 X2 X3 1 6 6 18 2 14 6 26 3 22 6 34 4 6 14 66 5 14 14 74 6 22 14 82 > ###最終的に得たい座標セット### > ###周囲4つの値の平均となってほしい### > mat3/4 X1 X2 X3 1 1.5 1.5 4.5 2 3.5 1.5 6.5 3 5.5 1.5 8.5 4 1.5 3.5 16.5 5 3.5 3.5 18.5 6 5.5 3.5 20.5 >一応、上記のへたくそなプログラムでもおおよそのやりたいことは出来ているのですが、実は、まだ上記に含めていない条件が二つあります。

一つは、周囲4つの平均でなく周囲9つの平均や16の平均(つまり正方形で扱いたい)と任意に変えたいときに、上記のプログラムでは一から書き直しになります。

そこを明示的に加えたいのですが、上手く書けませんでした(例ではそもそも24行しかないので、9や16は難しいですが…)。

もう一つの条件は、z軸にNAが含まれている座標があるのですが、そのときはNAを抜いた数で平均を返したいのです。

例えば、

mat[1, 3] <- NA等とした時には、そのまま上記プログラムを走らせると最後までNA表記となり、やりたいことができません。

4で割るのではなく、そのときだけ上記例ですと3で割ってほしいのですが、複雑で出来ませんでした。

さらに、このデータ、実際は結構大きな行列(6万×3くらいです)ですので出来るだけベクトルで処理したいと思っています。

高速化した例ですと、大変助かります。

どなたか上記の条件で変換が出来る方がいらっしゃいましたら、ご教授頂けると幸いです。

関数

func <- function(mat, n2)

{

n <- sqrt(n2)

nr <- nrow(mat)

nc <- ncol(mat)

stopifnot(nr%%n == 0 && nc%%n == 0)

ans <- NULL

for (j in 0:(nc%/%n-1)*n) {

ind.j <- (j+1):(j+n) # j+1 から j+n までの列

for (i in 0:(nr%/%n-1)*n) {

ind.i <- (i+1):(i+n) # i+1 から i+n までの行

ans <- c(ans, mean(ind.i), mean(ind.j),

mean(mat[ind.i, ind.j], na.rm=TRUE))

}

}

return(data.frame(matrix(ans, ncol=3, byrow=TRUE)))

}

実行例

mat <- matrix(1:108, 9, 12)

mat[4,5] <- mat[7,3] <- mat[9,6] <- NA # 欠損値を適当にちりばめる

mat

(ans <- func(mat, 9)) # 9×12 行列を,3行×3列単位でまとめる

実行結果

> mat

[,1] [,2] [,3] [,4] [,5] [,6] [,7] [,8] [,9] [,10] [,11] [,12]

[1,] 1 10 19 28 37 46 55 64 73 82 91 100

[2,] 2 11 20 29 38 47 56 65 74 83 92 101

[3,] 3 12 21 30 39 48 57 66 75 84 93 102

[4,] 4 13 22 31 NA 49 58 67 76 85 94 103

[5,] 5 14 23 32 41 50 59 68 77 86 95 104

[6,] 6 15 24 33 42 51 60 69 78 87 96 105

[7,] 7 16 NA 34 43 52 61 70 79 88 97 106

[8,] 8 17 26 35 44 53 62 71 80 89 98 107

[9,] 9 18 27 36 45 NA 63 72 81 90 99 108

> (ans <- func(mat, 9))

X1 X2 X3

1 2 2 11.000

2 5 2 14.000

3 8 2 16.000

4 2 5 38.000

5 5 5 41.125

6 8 5 42.750

7 2 8 65.000

8 5 8 68.000

9 8 8 71.000

10 2 11 92.000

11 5 11 95.000

12 8 11 98.000

性能評価

> mat <- matrix(1:(500*500), 500) # セル数が25万

> system.time(func(mat, 4)) # これが,一番時間のかかる場合(単位は秒)

ユーザ システム 経過

35.414 49.723 85.492

> system.time(func(mat, 25))

ユーザ システム 経過

1.599 1.213 2.886

> system.time(func(mat, 100))

ユーザ システム 経過

0.277 0.030 0.407

###作成して頂いたfuncへ自分のデータを変換### > mat2 <- data.frame(expand.grid(x=1:6, y=1:4), z=1:(6*4)) > mat3 <- matrix(mat2[, 3], 6, 4) > func(mat3, 4) #確認 X1 X2 X3 1 1.5 1.5 4.5 2 3.5 1.5 6.5 3 5.5 1.5 8.5 4 1.5 3.5 16.5 5 3.5 3.5 18.5 6 5.5 3.5 20.5上記の変換で、作っていただいた関数用にデータ加工する方法はわかりました。本当にありがとうございました。ただ、実際のデータは座標が1から始まらないので変換する必要がありました。座標系を適当に1から与えてサンプルプログラムを提示した私のミスです。申し訳ありません。そこで、1から始まらない座標系にも作っていただいたプログラムが適用できる様に、以下のようなfunc2を作成してみました。

> ###1から始まらない座標系を与える###

> mat4 <- data.frame(expand.grid(x=seq(11, 16),

+ y=seq(3, 6)), z=1:24)

>

> ###番地を付け足す###

> mat5 <- data.frame(mat4, expand.grid(x2=1:length(levels(as.factor(mat4[, 1]))),

+ y2=1:length(levels(as.factor(mat4[, 2])))

+ ))

>

> ###座標を元の座標に戻すように改造###

> func2 <- function(mat, n2, MAT)

+ {

+ n <- sqrt(n2)

+ nr <- nrow(mat)

+ nc <- ncol(mat)

+ stopifnot(nr%%n == 0 && nc%%n == 0)

+ ans <- NULL

+ for (j in 0:(nc%/%n-1)*n) {

+ ind.j <- (j+1):(j+n) # j+1 から j+n までの列

+ for (i in 0:(nr%/%n-1)*n) {

+ ind.i <- (i+1):(i+n) # i+1 から i+n までの行

+

+ ###合致するものをsubsetで探してくる###

+ ans <- c(ans, mean(MAT[ind.i, 1]), mean(

+ subset(MAT[, 2],

+ MAT[, 4]==ind.i&MAT[, 5]==ind.j)),

+ mean(mat[ind.i, ind.j], na.rm=TRUE))

+ }

+ }

+ return(data.frame(matrix(ans, ncol=3, byrow=TRUE)))

+ }

###整合性の確認###

> func(mat3, 4)

X1 X2 X3

1 1.5 1.5 4.5

2 3.5 1.5 6.5

3 5.5 1.5 8.5

4 1.5 3.5 16.5

5 3.5 3.5 18.5

6 5.5 3.5 20.5

###整合性の確認###

> func2(mat3, 4, mat5)

X1 X2 X3

1 11.5 3.5 4.5

2 13.5 3.5 6.5

3 15.5 3.5 8.5

4 11.5 5.5 16.5

5 13.5 5.5 18.5

6 15.5 5.5 20.5

> 性能評価

> mat <- data.frame(expand.grid(x=101:600, y=101:600),z=1:(500*500))

> mat2 <- matrix(mat[, 3], 500, 500)

> mat3 <- data.frame(mat, expand.grid(x2=1:as.numeric(summary(as.factor(mat[, 1]))[1]),

+ y2=1:as.numeric(summary(as.factor(mat[, 2]))[1])

+ ))

>

> system.time(func2(mat2, 4, mat3))

ユーザ システム 経過

539.02 0.12 539.36 #約9分かかります。

> system.time(func2(mat2, 25, mat3))

ユーザ システム 経過

83.35 0.00 83.35

> system.time(func2(mat2, 100, mat3))

ユーザ システム 経過

20.77 0.00 20.77

もう目的は十分達成されていると思うので、お時間があれば、で構いません。

もし、座標を元に戻すやり方をもっと早く処理する方法をご存じの方がいらっしゃいましたらご教授頂ければ幸いです。 -- Saito 2010-10-14 (木) 14:17:19func <- function(mat, rv, cv, n2) # ★★ rv, cv を追加

{

n <- sqrt(n2)

nr <- nrow(mat)

nc <- ncol(mat)

stopifnot(nr%%n == 0 && nc%%n == 0)

ans <- NULL

for (j in 0:(nc%/%n-1)*n) {

ind.j <- (j+1):(j+n) # j+1 から j+n までの列

for (i in 0:(nr%/%n-1)*n) {

ind.i <- (i+1):(i+n) # i+1 から i+n までの行

ans <- c(ans, mean(rv[ind.i]), mean(cv[ind.j]), # ★★ rv, cv の平均を求める

mean(mat[ind.i, ind.j], na.rm=TRUE))

}

}

return(data.frame(matrix(ans, ncol=3, byrow=TRUE)))

}

#実行例

mat <- matrix(1:108, 9, 12)

mat[4,5] <- mat[7,3] <- mat[9,6] <- NA # 欠損値を適当にちりばめる

rv <- c(1,3,6,9,11,20,27,35,42) # ★★ 行方向の座標ベクトル(下の mat の表示の表側を参照)

cv <- c(2,4,6,7,8,11,13,16,19,22,25,27) # ★★ 列方向の座標ベクトル(下の mat の表示の表頭を参照)

rownames(mat) <- rv # これは付けなくても良いけど

colnames(mat) <- cv # 〃

mat

(ans <- func(mat, rv, cv, 9)) # 9×12 行列を,3行×3列単位でまとめる

> mat

2 4 6 7 8 11 13 16 19 22 25 27

1 1 10 19 28 37 46 55 64 73 82 91 100

3 2 11 20 29 38 47 56 65 74 83 92 101

6 3 12 21 30 39 48 57 66 75 84 93 102

9 4 13 22 31 NA 49 58 67 76 85 94 103

11 5 14 23 32 41 50 59 68 77 86 95 104

20 6 15 24 33 42 51 60 69 78 87 96 105

27 7 16 NA 34 43 52 61 70 79 88 97 106

35 8 17 26 35 44 53 62 71 80 89 98 107

42 9 18 27 36 45 NA 63 72 81 90 99 108

> (ans <- func(mat, rv, cv, 9)) # 9×12 行列を,3行×3列単位でまとめる

X1 X2 X3

1 3.333333 4.000000 11.000

2 13.333333 4.000000 14.000

3 34.666667 4.000000 16.000

4 3.333333 8.666667 38.000

5 13.333333 8.666667 41.125

6 34.666667 8.666667 42.750

7 3.333333 16.000000 65.000

8 13.333333 16.000000 68.000

9 34.666667 16.000000 71.000

10 3.333333 24.666667 92.000

11 13.333333 24.666667 95.000

12 34.666667 24.666667 98.000> mat2 <- data.frame(expand.grid(x=11:16, y=3:6), z=1:(6*4))

> mat3 <- matrix(mat2[, 3], 6, 4)

> rv <- c(11:16)

> cv <- c(3:6)

> func(mat3, rv, cv, 4) #確認

X1 X2 X3

1 11.5 3.5 4.5

2 13.5 3.5 6.5

3 15.5 3.5 8.5

4 11.5 5.5 16.5

5 13.5 5.5 18.5

6 15.5 5.5 20.5

自分の実際のデータに適用しても上手く動きました。非常に勉強になりました。重ね重ね、本当にありがとうございました。-- Saito 2010-10-14 (木) 18:45:12JJ (2010-10-12 (火) 20:17:51)

まったくの初級者です。

ポリコリック相関係数を用いた因子分析(最尤法、プロマックス)を3日間ほど悩んでいます。最終的に因子得点も算出したいと思っています。

現在までのところ、

factanal(covmat=cor(データ), factors=3,promax,regression)

という感じまでは来たのですが。。。数字は出ますが、これは一般の因子分析なのかと思っています。

ちなみにpolychor(x,y,)関数の場合、相関係数にはなので、相関係数行列にはなりませんよね。

まことに見当はずれかもしれませんが、誰か力を貸していただければありがたいです。

上記の corのままでは

library(psych) library(polycor) data(bfi) dat <- bfi[1:17] # 17項目のデータ pcr <- polychoric(dat) pcr # polychoric関数はrhoやtauといった複数の値を返す。polychoric関数のヘルプ参照 ans <- factanal(covmat=pcr$rho, factors=2, rotation="promax") ans

sayaka (2010-10-12 (火) 14:05:00)

以前、「T,Fを文字列として出力するには」でお世話になりました。

うまく説明するのが難しいのですが、下記の data のようなベクトルがあるとき、399,400,401・・のように数値が続いている場合に"何個続いているか"を下記の a のように出力したいと考えているのですが、どのようにすれば求めることが出来るでしょうか。

いろいろと試行錯誤したのですが、どうしても思いつきません。

data はあるデータ中のエラーデータの行番号を抽出したもので、エラーデータの開始位置と長さより削除するプログラムがあるために長さが必要です。

開始位置は下記のposiで求めました。

どうぞよろしくお願いします。> data [1] 14 41 73 152 296 297 399 400 401 402 418 419 420 421 422 423 424 425 426 427 428 429 [23] 430 431 451 452 453 454 460 461 466 500 501 502 503 504 505 506 507 508 > posi <- data[diff(c(0,data)) != 1] > posi [1] 14 41 73 152 296 399 418 451 460 466 500 > a [1] 1 1 1 1 2 4 14 4 2 1 9

菊亭 (2010-10-06 (水) 22:12:34)

現在XPでRを使っております。そのうち7にアップグレードしょうかと画策中ですが、VistaとRの相性がかなり悪かった(というかVistaが酷かった)記憶があります。7とRには既知の問題はありますでしょうか?

ランゲル・ハンス (2010-10-02 (土) 09:51:51)

plotrixにあるcolor2D.matplot関数について質問させていただきます。library(plotrix) x <- c(1, 0, 10, 5, 3, 6, 4, 5, 4, 3, 8, 5, 1, 0, 7, 5) data <- matrix(x, ncol=4) color2D.matplot(data, c(1, 0), c(0, 1), c(0, 1), show.values=TRUE)このmatirixの数値をカラー表示のマトリックスに変換して数値も表示したいと思います。

上記の例では変換できるのですが、マイナスがある場合のスケール変換の方法と色表示の方法をご教示いただけないでしょうか?

例えばyの場合についてy <- c(1, 0, 10, 5, -3, 6, -4, 5, 4, 3, 8, 5, 1, 0, 7, 5)よろしくお願いします。

隣は何をする人ぞ (2010-10-01 (金) 21:34:02)

psych パッケージを使って因子分析を行ったとき、因子負荷量の大きい順にソートしたときとしなかったときで、因子負荷量の値が異なったものが表示されます。単に因子単位に因子負荷量の絶対値の大きい順に並べ替えて表示するだけだと思うのですが、なぜ因子負荷量の値が異なるのでしょうか。訳がわかりません。library(psych) data(bfi) fa.parallel(bfi) fpa.out <- factor.pa(bfi, nfactors=3, rotate="promax") print(fpa.out) # 分析に使用した変数順そのまま print(fpa.out, sort=TRUE) # 因子負荷量の大きい順に並べ替えるで分析を行いました。並び順は異なっても、各変数の因子負荷量は同じはずです。

まず、print(fpa.out) の結果です。いくつかの変数だけを選択して掲載します。########## デフォルト(sort=FALSE)のとき > print(fpa.out) Factor Analysis using method = pa Call: factor.pa(r = bfi, nfactors = 3, rotate = "promax") Unstandardized loadings based upon covariance matrix PA1 PA2 PA3 h2 u2 H2 U2 A1 -0.22 0.08 0.01 0.0600 0.94 0.0600 0.94 : E4 0.74 -0.06 -0.15 0.4823 0.52 0.4812 0.52 : gender 0.20 0.15 0.00 0.0490 0.95 0.0490 0.95 education -0.03 -0.04 0.10 0.0099 0.99 0.0099 0.99 age 0.04 -0.09 0.14 0.0398 0.96 0.0398 0.96 PA1 PA2 PA3 SS loadings 3.30 2.66 2.15 Proportion Var 0.12 0.09 0.08 Cumulative Var 0.12 0.21 0.29 Standardized loadings item PA1 PA2 PA3 h2 u2 A1 1 -0.22 0.08 0.01 0.0600 0.94 : E4 14 0.73 -0.06 -0.15 0.4812 0.52 : gender 26 0.20 0.15 0.00 0.0490 0.95 education 27 -0.03 -0.04 0.10 0.0099 0.99 age 28 0.04 -0.09 0.14 0.0398 0.96次に、print(fpa.out, sort=TRUE) の結果です。

########## sort=TRUE を指定したとき > print(fpa.out, sort=TRUE) Factor Analysis using method = pa Call: factor.pa(r = bfi, nfactors = 3, rotate = "promax") Unstandardized loadings based upon covariance matrix PA1 PA2 PA3 h2 u2 H2 U2 E4 0.74 -0.06 -0.15 0.4823 0.94 0.339 0.66 : A1 -0.22 0.08 0.01 0.0600 0.73 0.076 0.92 gender 0.20 0.15 0.00 0.0490 0.58 0.078 0.92 : age 0.04 -0.09 0.14 0.0398 0.99 0.039 0.96 education -0.03 -0.04 0.10 0.0099 0.96 0.010 0.99 PA1 PA2 PA3 SS loadings 3.30 2.66 2.15 Proportion Var 0.12 0.09 0.08 Cumulative Var 0.12 0.21 0.29 Standardized loadings item PA1 PA2 PA3 h2 u2 E4 14 0.62 -0.05 -0.12 0.339 0.66 : A1 1 -0.25 0.09 0.01 0.076 0.92 gender 26 0.25 0.19 0.00 0.078 0.92 : age 28 0.04 -0.09 0.13 0.039 0.96 education 27 -0.03 -0.04 0.10 0.010 0.99Unstandardized loadings based upon covariance matrix については、並べ替えしてもしなくても、各変数の因子負荷量は同じです(これが当たり前だと思います)。

Standardized loadings については、並べ替えしたのとしないとでまるっきり違うものが表示されています。

なぜでしょう。

一応、psych クラスの print メソッド(psych:::print.psych) のソースもたどっては見たのですけど、明らかなバグというのではなく、書かれているプログラムがなぜそのようなパスをたどらなければならないのかがよくわかりませんでした(それ自身がバグと言うことなのかも知れませんが)。

多くの人が使っているパッケージなので、いまだにバグがあるとも思えませんが、不思議に思いましたので質問させて頂きます。

I finally had time to find the bug. It was not in factor.pa as I had hoped, but it was in the print routine which thus affected fa, as well as factor.pa. The sorted loadings are now sorted correctly, as are the communalities and uniquenesses. I have fixed this for version 1.0.93 which should be released sometime soon.だそうです。 -- 隣は何をする人ぞ 2010-11-28 (日) 23:12:19

のの (2010-09-29 (水) 02:16:00)

MacでGUI版Rを使っています。version.string R version 2.11.1 (2010-05-31)

エディタにコマンドを連ねて、メニュー>編集>実行をする場合、途中でエラーがあっても、止まらずに最後まで流れてしまいます。

コマンドリストの任意の場所でRの実行を止める方法を探しています。

readline(),stopifnot()などを試しましたがだめでした。

今のところquit()を入れると、そこで、保存するかどうか聞いてくるので目的は達成できているのですが、何かもっと良い方法はないでしょうか?

> try({ old <- options(warn=2) # これと,

+ a <- sqrt(-9)

+ print(,)

+ print("ok")

+ options(old) }) # これの対で囲む

Error in sqrt(-9) : # 最初のエラーでストップ

(警告から変換されました) 計算結果が NaN になりました

> try({ old <- options(warn=2)

+ a <- sqrt(9) # 修正した

+ print(,)

+ print("ok")

+ options(old) })

Error in .Internal(print.default(x, digits, quote, na.print, print.gap, :

'x'が見つかりません # 二番目のエラーでストップ

> try({ old <- options(warn=2)

+ a <- sqrt(9)

+ print(a) # ここも直した

+ print("ok")

+ options(old) })

[1] 3 # 全部うまくいった

[1] "ok"

その他に,tryCatch, withCallingHandlers, signalCondition, simpleError, simpleWarning, conditionCall, conditionMessage, withRestart, computeRestarts, findRestart, invokeRestart, invokeRestartInteractively, isRestart, restartDescription, restartFomals, .signalSimpleWarning, .handleSimpleError などを調べると良いでしょう。 -- 河童の屁は,河童にあらず,屁である。 2010-09-29 (水) 12:26:45while(1){ #エディタの最初に記載

+ ここから実行するコマンドリスト

+ 次のコマンド・・・

+ break #ここでRの実行を止める

+ 結果として実行されないコマンド

+ break;} #もし途中にbreakがない場合にはここで終了

このような方法も思いつきましたが、コマンドの結果を出力させるためにcat()を使わないといけなかったりと面倒な感じです。もう少し軽やかな方法があればと思っています。 -- のの 2010-09-30 (木) 04:56:16print(1) print() # Error print(2)と書いて[全て実行]すると、

> print(1) [1] 1 > print() # Error 以下にエラー print.default() : 要素 1 は空です; > print(2) [1] 2のように、エラー以降のprint(2)も実行されてしまう、と。 これを解決したいということであれば、単純にスクリプト全体をプロック化して

{

print(1)

print() # Error

print(2)

}

のようにするのはいかがでしょう。括弧が閉じたところでスクリプトが実行され、エラーが起こるとブロック全体が止まります。

> {

+ print(1)

+ print() # Error

+ print(2)

+ }

[1] 1

以下にエラー print.default() :

要素 1 は空です;

> # print(2)は実行されていない

もちろんこんなことせずとも、全体をファイルに保存してからsourceすれば、エラーの部分で止まって以降の処理は行なわれないわけですが。どうしても[全て実行]を使いたいということであれば、この方法が楽かと思います。 -- 2010-09-30 (木) 16:22:26shumei (2010-09-25 (土) 14:33:13)

Mac版R 2.11.1 をインストールした後、パッケージurcaをインストールしました。

urcaをロードし、パッケージの使用はできましたが、Rを起動するたびに未ロード状態にもどってしまいます。

何冊か書籍に当たってみましたが、該当する記述が見つからず、こちらに投稿させて頂きます。

パッケージのロード状態を維持するにはどうすればいいのでしょうか。それとも、これはRの仕様なのですか?

ご教授下さい。どうぞよろしくお願い致します。

/.Rprofileと教えるところを単に.Rprofileと書くと、説明された方は?.Rprofileを参照して、R_HOME/etc/Rprofile.siteのことではないかと思う人もいるだろう -- 2010-10-02 (土) 14:33:58

moyu (2010-09-21 (火) 14:54:22)

ヒストグラムで、ある一部の区間において細かく階級を分割したいのですが、どうしたらいいのか分かりません。ちなみに以下の操作をしました。hangseng = read.csv("ASIA/hangseng/hangsengdaily-1986dec31~2010jun11.csv") hangseng.ts = ts(rev(hangseng$Close),start=c(1986,12,31),frequency=248) ts.plot(hangseng.ts) ts.plot(diff(hangseng.ts)) hist(diff(hangseng.ts),breaks=30,col="magenta")histの中のbreaksをどういじったらいいのでしょうか??

breaks one of: ・ a vector giving the breakpoints between histogram cells, ・ a single number giving the number of cells for the histogram, ・ a character string naming an algorithm to compute the number of cells (see ‘Details’), ・ a function to compute the number of cells. In the last three cases the number is a suggestion only.あなたが指定した breaks=30 は,この中の 2 番目のものですよね。一番目の指定方法をとらないとね。どうやって良いかそれでもわからない?下の方の,Example の項にいくつか例があり,そのうちの breaks=c(12,20,36,80,200,1000,17000) というのがそれですよ。-- 河童の屁は,河童にあらず,屁である。 2010-09-21 (火) 17:10:12

初級者です。 (2010-09-20 (月) 18:11:38)

CentOS 5.5 に Rをインストールし、以下の操作をしました。pdf("test.pdf",family="Japan1") plot(1:10,ylab="test test") dev.off() embedFonts("test.pdf")すると、ylabに指定した"test test"文字列の間にある空白の位置に、「・」が表示されてしまいます。

正確には、"test ・test"という感じで、普通に半角スペースが表示されている上に、若干右側によって「・」が重なっているという感じです。

embedFonts()を呼ぶ前の状態では、「・」は表示されていません。

また、その状態で文章のプロパティから使用されているフォントを見ると、「KozMinPro-Regular-Acro」 「KozMinPro-Regular-Acro.Bold」 「KozMinPro-Regular-Acro.BoldItalic」 「KozMinPro-Regular-Acro.Italic」 「Symbol」 「ZapfDingbats」というフォントが使用されていると出ますが、embedFonts()を呼んだ後で同様にフォントを確認すると、「Sazanami-Gothic(埋め込みサブセット)」というフォントが使用されていると出ます。

何らかフォントの設定が足りないとは思い、いろいろ調べてみてはいるのですが、壁に当たった状態です。

同様の現象を解決された方がいらっしゃれば方法をご教示いただけないかと思い、こちらに投稿しました。

よろしくお願いいたします。

/KozMinPro-Regular-Acro << /FileType /TrueType /Path (/usr/local/share/fonts/ipafont/ipam.ttf) /CSI [(Japan1) 6] >> ;みたいに記述すれば良いと思います. -- なかま 2010-09-22 (水) 00:55:05

てるてるぼうず (2010-09-19 (日) 23:22:48)

関数のヘルプファイルを表示したいと思い、以下を実行するのですが、

?…またはhelp(…)毎回以下のようなエラーが出ます> ?glm 警告メッセージ: In file.show(temp, title = gettextf("R Help on '%s'", topic), delete.file = TRUE) : file.show():ファイル 'C:\DOCUME~1\蜿、蟾晏忽蠢予LOCALS~1\Temp\RtmpIDu7yb\Rtxt678418be' は存在しません > help("glm") 警告メッセージ: In file.show(temp, title = gettextf("R Help on '%s'", topic), delete.file = TRUE) : file.show():ファイル 'C:\DOCUME~1\蜿、蟾晏忽蠢予LOCALS~1\Temp\RtmpIDu7yb\Rtxt3d6c4ae1' は存在しません検索エンジン等で調べてはみましたが、未だ解決していません。

環境は以下の通りです。Microsoft Windows XP Professional Version 2002 Service Pack 3 Intel(R) Core(TM)2 Duo CPU E8400 @ 3.00GHz 2.99 GHz、976 MB RAM Rのバージョン R version 2.11.1 (2010-05-31)

sh (2010-09-16 (木) 11:50:21)

regexpr(pattern, text, perl = T)を実行したところ、以下のエラーが出力されました。patternの文字数(59291文字)を減らせば、正常に動作します。patternの文字数を減らすことなく、正常に動作させることは可能でしょうか?環境は、R version 2.11.1 (2010-05-31); x86_64-apple-darwin9.8.0です。以下にエラー regexpr(pattern, text, perl = T) : 追加情報: 警告メッセージ: In regexpr(pattern, text, perl = T) : PCREパターンのコンパイルエラー 'regular expression is too large' at ''

> text [1] "A11" "A12" "A13" "A14" "A15" "A16" "A17" "A18" "A19" "A20" "A21" "A22" [13] "A23" "A24" "A25" "A26" "A27" "A28" "A29" "A30" "A31" "A32" "A33" "A34" [25] "A35" "A36" "A37" "A38" "A39" "A40" > text1 <- gsub(pattern = "A11|A15|A20|A27",NA,text) # マッチしたものをNAで置き換え > text1 [1] NA "A12" "A13" "A14" NA "A16" "A17" "A18" "A19" NA "A21" "A22" [13] "A23" "A24" "A25" "A26" NA "A28" "A29" "A30" "A31" "A32" "A33" "A34" [25] "A35" "A36" "A37" "A38" "A39" "A40" > text2 <- gsub(pattern = "A29|A31|A35|A36|A39",NA,text1) > text2 [1] NA "A12" "A13" "A14" NA "A16" "A17" "A18" "A19" NA "A21" "A22" [13] "A23" "A24" "A25" "A26" NA "A28" NA "A30" NA "A32" "A33" "A34" [25] "A35" NA "A37" "A38" NA "A40" > is.na(text2) [1] TRUE FALSE FALSE FALSE TRUE FALSE FALSE FALSE FALSE TRUE FALSE FALSE [13] FALSE FALSE FALSE FALSE TRUE FALSE TRUE FALSE TRUE FALSE FALSE FALSE [25] TRUE TRUE FALSE FALSE TRUE FALSE > text[is.na(text2)] # マッチした文字列 [1] "A11" "A15" "A20" "A27" "A29" "A31" "A35" "A36" "A39"

> text <- paste('AAA11111', seq(11, 29), sep='')

> pattern = c('AAA1111111', 'AAA1111112')

> text %in% pattern

[1] TRUE TRUE FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSE

[12] FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSEg (2010-09-14 (火) 11:54:44)

例えば,A,B,C 3121234567890,10,20 3122345678901,20,30 3123456789012,30,40という中身のcsvファイルa.csvをread.csvで読み込ませると

> read.csv("a.csv") A B C 1 3.121235e+12 10 20 2 3.122346e+12 20 30 3 3.123457e+12 30 40となってしまいます.浮動小数点ではなくそのままの形で読み込ませるにはどうしたらいいでしょうか.

> (X <- read.csv("a.csv"))

A B C

1 3.121235e+12 10 20

2 3.122346e+12 20 30

3 3.123457e+12 30 40

> options(digits=22)

> X

A B C

1 3121234567890 10 20

2 3122345678901 20 30

3 3123456789012 30 40> options(digits=22) > 123456789012345 [1] 123456789012345 > 1234567890123456 [1] 1234567890123456 > 12345678901234567 # 近似による誤差が生じ始める [1] 12345678901234568 > 123456789012345678 [1] 123456789012345680 > 1234567890123456789 [1] 1234567890123456768 > 12345678901234567890 [1] 12345678901234567168 > 123456789012345678901 [1] 123456789012345683968 > 1234567890123456789012 # 浮動小数点表示になり始める [1] 1.234567890123457e+21

id (2010-09-12 (日) 21:34:03)

密度関数を直接積分することで、分布関数を求めてプロットしようとしているのですが、うまくいきません。

簡単に書きなおすと以下のようなコードで、実行するとエラーを吐きます。> pdf <- function(x) exp(-x) > cdf <- function(x) integrate(f, 0, x) > plot(cdf) 以下にエラー xy.coords(x, y, xlabel, ylabel, log) : 'x' and 'y' lengths differcdf(Inf) などとすると正常な答えを返してくれるので、関数として機能はしているようですがプロットしてくれません。

プロットするにはどうすればよいでしょうか?

ちなみに実際に考えている分布は beta prime distribution です。

この分布の cdf に出てくる 2F1 関数の扱いがわからず、上のような苦肉の策をしようと思っています。

> pdf <- function(x) exp(-x) > cdf <- function(x) integrate(f, 0, x) > plot(cdf) 以下にエラー match.fun(f) : オブジェクト 'f' がありません

> cdf <- function(x) sapply(x,function(t) integrate(pdf,0,t)$value)

sakura (2010-09-12 (日) 17:26:35)

Rで、pooled adjacent violator algorithm を使ったライブラリーには何があるのでしょうか?

mtanaka (2010-09-07 (火) 20:12:53)

for文で任意の関数に連番で命名したオブジェクトを入力する場合どのように記述すればよいのでしょうか?

for文内でのファイル名の記述様式がわかりません。関数 func() オブジェクト(入力データ): hoge01, hoge02, hoge03 オブジェクト(出力データ): piyo01, piyo02, piyo03 実行例 piyo01 <- func(hoge01) piyo02 <- func(hoge02) piyo03 <- func(hoge03)この上記の実行例をfor文で記述したいです。

どなたか、ご助言いただける方がいらっしゃいましたら、宜しくお願いいたします。

hoge01 <- 1 # 関数に作用させる対象

hoge02 <- 2

hoge03 <- 3

hoge04 <- 4

for (i in 1:4) { # それぞれの対象について func を作用させ,結果を格納することの記述

eval(parse(text=paste(sprintf("piyo%02i <- func(hoge%02i)", i, i))))

}

piyo01 # 結果を参照するときに,一々名前を引用しないといけない

piyo02 # 何の処理をすることなく,単に結果をファイルに書き出すだけであっても同じ

piyo03

piyo04

しかし,普通は以下のようにした方がもっと扱いやすいでしょう。

hoge <- 1:4 # 関数に作用させる対象を配列なりリストなりで表す

piyo <- func(hoge) # 関数を作用させ結果も配列やリストに格納する

# 場合によっては,for ループで処理しないといけない場合もあるだろう

piyo # 結果を引用するときも,配列やリストの要素を参照する

eval(parse(text=foo)) は,今のあなたのやりたいことのために使うものじゃないでしょう。> hoge1 <- 1; hoge2 <- 2; hoge3 <- 3; hoge4 <- 4

> N <- 4

> X <- vector("list",N)

> for (i in 1:N) X[[i]] <- eval(parse(text=paste("hoge",i,sep="")))

> str(X)

List of 4

$ : num 1

$ : num 2

$ : num 3

$ : num 4

> foo <- function(x) x^2

> Y <- lapply(X,foo)

> str(Y)

List of 4

$ : num 1

$ : num 4

$ : num 9

$ : num 16

> Y[[1]];Y[[2]];Y[[3]];Y[[4]]

[1] 1

[1] 4

[1] 9

[1] 16rcddnsj (2010-09-06 (月) 23:54:37)

Windows7でR version 2.11.1を使用しております。

サポートベクターマシンを試してみたくて、パッケージe1071をインストールし、関数svmを実行するところまでは、たどり着きました。

しかし、e1071に含まれているはずの関数predict.svmで予測しようとすると、「関数 "predict.svm" を見つけることができませんでした」とのエラーでpredict.svmを呼び出せませんでした。

操作はRcmdrのスクリプトウィンドウから実行しています。

このように、パッケージに含まれているはずの関数が呼び出せない場合、どのような原因とあるいは、対処法が考えられるのでしょうか?

Rの再インストール、パッケージe1071の再インストールなどはもちろん試しています。

sessionInfo() の実行結果は下記の通りです。R version 2.11.1 (2010-05-31) i386-pc-mingw32 locale: [1] LC_COLLATE=Japanese_Japan.932 LC_CTYPE=Japanese_Japan.932 LC_MONETARY=Japanese_Japan.932 LC_NUMERIC=C [5] LC_TIME=Japanese_Japan.932 attached base packages: [1] splines tcltk stats graphics grDevices utils datasets methods base other attached packages: [1] SparseM_0.86 e1071_1.5-24 class_7.3-2 Rcmdr_1.6-0 car_2.0-2 survival_2.35-8 nnet_7.3-1 [8] MASS_7.3-7 loaded via a namespace (and not attached): [1] tools_2.11.1どなたか、ご助言いただける方がいらっしゃいましたら、宜しくお願いいたします。

Usage:

## S3 method for class 'svm':

predict(object, newdata, decision.values = FALSE,

probability = FALSE, ..., na.action = na.omit)

分かりますよね? -- 2010-09-07 (火) 00:07:05ito (2010-08-31 (火) 20:12:14)

あるベクトルについて、他のベクトルの中のNAに対応する要素だけをNAに変換したいのです。よい方法はないでしょうか。x <- c(1,3,4,6,8,9) y <- c(1,NA,2,NA,3,4)変換後

> x [1] 1 NA 4 NA 8 9となるようにしたいのです。

ifelse(x[is.na(y)],NA)とか考えたのですが、うまくいきません。

よろしくおねがいします。

mapply(max, x, y)mapplyは1つ目の引数に指定した関数を2つ目以降に指定したベクトルから1つずつ取り出して実行する関数。 -- Spica 2010-08-31 (火) 20:18:23

func <- function(x, y)

{

nx <- length(x)

ny <- length(y)

if (nx <= ny) {

return(ifelse(is.na(y[1:nx]), NA, x))

}

else {

return(c(ifelse(is.na(y), NA, x[1:ny]), x[(ny+1):nx]))

}

}

# 長さが同じときには色々な方法がある

> x <- c(1,3,4,6,8,9)

> y <- c(1,NA,2,NA,3,4)

> func(x, y)

[1] 1 NA 4 NA 8 9

# x の長さが短いとき,x と同じ長さに y を切り詰めて,x, y を同じ長さにして処理

> x <- c(1,3,4,6,8)

> y <- c(1,NA,2,NA,3,NA)

> func(x, y)

[1] 1 NA 4 NA 8

# x の長さが長いとき,y と同じ長さに x を切り詰めて処理した後,残りの x を接続

> x <- c(1,3,4,6,8,9,10,11)

> y <- c(1,NA,2,NA,3,4)

> func(x, y)

[1] 1 NA 4 NA 8 9 10 11> 0*y [1] 0 NA 0 NA 0 0 > x + 0*y [1] 1 NA 4 NA 8 9

初心者 (2010-08-30 (月) 16:56:25)

いつもお世話になっております。

pls回帰分析をしたいのですが,Rですと,ベータは求められても,そのベータが有意かの検定はできないのでしょうか。またできるのなら,どのように行うのでしょうか。pls回帰分析を学ぶに当たり,岩田先生のpls回帰入門やAcreMaker様のホームページを見ましたが,有意かどうか扱っていませんでしたので,質問させて頂きました。

使用環境は、R2.11.1です。OSはWindowsVista です。

よろしくお願いします。

Saito (2010-08-27 (金) 08:52:15)

いつもお世話になっております。

似た様な質問はいくつかあったのですが、意外にも、条件抽出が複数で、かつ固定値ではなく、ベクトルで条件抽出をしている例が見当たらなかったので、質問させてください。

ある参照列(座標と価がセット)があるときに、それを参照して、新しい座標から、それにマッチングする価を参照したいと思っています。以下がサンプルプログラムです。

set.seed(1) a <- seq(1, 10) b <- seq(1, 10) c <- rnorm(100) ###参照列### d <- data.frame(expand.grid(a=a, b=b), c=c) ###当てはめたい座標### e <- data.frame(a=sample(a, 50000, rep=T), b=sample(b, 50000, rep=T)) ###これでは上手く動かない### subset(d$c, d$a==e$a & d$b==e$b) ###これでも### subset(d$c, d$a%in%e$a & d$b%in%e$b)

つまり、eの座標軸が与えられたときに、dの座標軸と対応させて、dの三列目(c列)を引っ張って来たいのです。

for文でやろうと思えばできるのですが、実際はもっとeが大きくて、for文が実行スピード的に使えません。%in%も、&が入っていなければ使えたのですが、この場合上手く動作しないようです。おそらく単純な問題だと思うのですが、思うようにいきません。

どなたか、分かる方がいらっしゃいましたら、ご教示いただけると幸いです。

d2 <- matrix(d$c, 10, 10) e2 <- as.matrix(e) d2[e2]つまり,この問題は表引きで,d$a, d$b が添え字の二次元配列で,その要素が d$c。d$a, d$b の添え字はちょうど R の二次元配列の順序と同じなので,d$c を matrix 関数で行列にするだけで済む。e$a, e$b を添え字と見て,その要素を取り出すのだから,単純な表引き。しかし,この場合,別に d2 や e2 など作る必要はなくて,

d$c[e$a+10*(e$b-1)]だけでよいことがわかってしまう。

> Ord <- data.frame(ord=seq(nrow(e))) # 本来の順序を示す作業用変数 > A <- merge(merge(cbind(e,Ord),d),Ord) # 欲しい結果 > AA <- A[,-1] # 作業用変数列が目障りなら > str(e) 'data.frame': 50000 obs. of 2 variables: $ a: int 3 3 6 3 2 6 6 2 3 8 ... $ b: int 6 8 4 8 7 8 4 2 6 7 ... > str(A) 'data.frame': 50000 obs. of 4 variables: $ ord: int 1 2 3 4 5 6 7 8 9 10 ... $ a : int 3 3 6 3 2 6 6 2 3 8 ... $ b : int 6 8 4 8 7 8 4 2 6 7 ... $ c : num 0.3411 0.6107 -0.415 0.6107 -0.0392 ... > str(AA) 'data.frame': 50000 obs. of 3 variables: $ a: int 3 3 6 3 2 6 6 2 3 8 ... $ b: int 6 8 4 8 7 8 4 2 6 7 ... $ c: num 0.3411 0.6107 -0.415 0.6107 -0.0392 ...

もしくは(こちらの方が直感的でわかり易い?)

> ed <- merge(cbind(e,Ord),d) > str(ed) 'data.frame': 50000 obs. of 4 variables: $ a : int 1 1 1 1 1 1 1 1 1 1 ... $ b : int 1 1 1 1 1 1 1 1 1 1 ... $ ord: int 32810 46779 23088 6441 17984 15437 12878 47025 38836 21870 ... $ c : num -0.626 -0.626 -0.626 -0.626 -0.626 ... > ed[order(ed$ord),][,-3] # 上のAAと同じもの

学生 (2010-08-26 (木) 22:48:35)

RでPLSを行おうとして追います。

PLSパッケージをインストールし,読み込んでも,「関数"PLS"を見つけることができませんでした」と返ってきます。

Rになれるための練習として,インターネット「岩田先生のPLS回帰入門」の「wine」についてPLSで分析しようとしているのですが上手くいきません。

何卒よろしくお願い致します。

> library(pls) # pls パッケージを使うために

次のパッケージを付け加えます: 'pls'

The following object(s) are masked from 'package:stats':

loadings

> plsr(foo, ...) # plsr というのが,あなたが使いたい関数ですよね> wine <- read.table("wine.txt")

> Y <- scale(wine[,1:3])

> X <- scale(wine[,4:7])

> library(pls)

次のパッケージを付け加えます: 'pls'

The following object(s) are masked from 'package:stats':

loadings

> wine.pls <- plsr(X, Y, 1:3, validation="CV")

以下にエラー formula.default(object, env = baseenv()) : invalid formula> library(pls)

> wine <- read.table("wine.txt")

> Y <- scale(wine[,1:3])

> X <- scale(wine[,4:7])

> wine.pls <- plsr(Y~X, 3, data=wine)

> summary(wine.pls)

Data: X dimension: 5 4

Y dimension: 5 3

Fit method: kernelpls

Number of components considered: 3

TRAINING: % variance explained

1 comps 2 comps 3 comps

X 70.45 98.35 100.0

Hedonic 70.53 70.71 100.0

Goes_with_meat 93.74 98.51 100.0

Goes_with_dessert 25.72 86.97 87.5

> coefficients(wine.pls, ncomp=2)

, , 2 comps

Hedonic Goes_with_meat Goes_with_dessert

Price -0.27140847 -0.2525422 0.01880366

Suger 0.06339537 0.3206223 0.78764141

Alcohol 0.28567521 0.3619657 0.27127454

Acidity 0.30722143 0.3730769 0.24272634> R574 <- read.csv("R574.txt")

> Y <- scale(R574[,9:10])

> X <- scale(R574[,5,8])

> R574.pls <- plsr(Y~X, 3, data=R574)

以下にエラー mvr(Y ~ X, 3, data = R574, method = "kernelpls") :

Invalid number of components, ncompま (2010-08-26 (木) 16:50:23)

図を作成した際に,x軸やy軸に添えられる数字が指数表示(1e-01,1e+01など)に自動的になります。これを回避したいのですが,どなたか方法を教えて頂けませんでしょうか?

何卒よろしくお願い申し上げます。

scipen.org <- getOption('scipen')

x <- seq(0, 0.001, 0.0001)

plot(x)

options(scipen=10)

plot(x)

options(scipen=scipen.org)atsuo (2010-08-23 (月) 11:52:39)

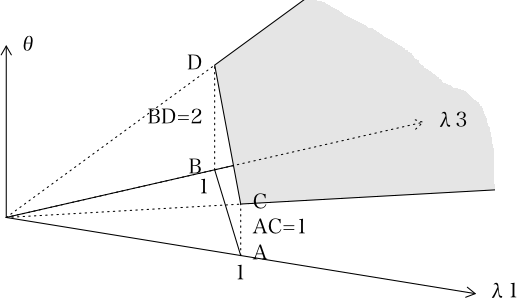

optimやconstrOptimで解決できないかと、あれこれやってみたのですが、

以下の線形計画問題を解決したいのです。

� 2*θ−2*λ[1]−2*λ[2]−1*λ[3] >= 0

� 1*θ−1*λ[1]−2*λ[2]−2*λ[3] >= 0

� 1 −1*λ[1]−1*λ[2]−1*λ[3] <= 0

� λ[1]+λ[2]+λ[3] >= 1

� λ[1]>=0

� λ[2]>=0

� λ[3]>=0

� �〜�の条件を満たし、θを最小にする問題です。

欲しいのはθの値とλ[1]、λ[2]、λ[3]の値です。

これはDEA分析なのですが、パッケージのFEARでも準備されていない解θが欲しいのです。

環境は、R2.11.1です。OSはWindows7 です。

> sim <- function(trial=10000, mx=1)

+ {

+ count <- 0

+ min.theta <- 10000

+ while(TRUE) {

+ lambda <- runif(3, min=0, max=mx) # 一様乱数発生 条件(5), (6), (7)

+ if (sum(lambda) >= 1) { # 条件(4)

+ theta <- max(lambda%*%c(1, 1, 0.5), lambda%*%c(1, 2, 2)) # θは(1)と(2)を満たす大きい方

+ if (theta < min.theta) { # それまでに見つかったものより小さければ書き出す

+ cat(theta, lambda, "\n")

+ min.theta <- theta # 見つかった解の候補で更新

+ ans <- c(theta, lambda)

+ count <- 0 # 空振り回数の更新

+ }

+ else {

+ count <- count+1 # 空振りが以下の回数続けば現在の解を最良とする

+ if (count > 1000000) return(ans)

+ }

+ }

+ }

+ }

> (ans <- sim()) # 出力は順に,θ,λ[1],λ[2],λ[3]

2.961947 0.9688506 0.2850662 0.711482

2.460659 0.9278959 0.2115464 0.5548352

1.890355 0.7575402 0.4784459 0.08796157

1.857158 0.2751631 0.7211324 0.06986522

途中省略

1.030237 0.9743367 0.00815206 0.01979813

1.029195 0.9880413 0.004979686 0.01559721

1.023945 0.9964487 0.005063805 0.008684346

[1] 1.023944978 0.996448677 0.005063805 0.008684346 # これが最終解

> # 念のために条件のチェック

> 2*ans[1]-2*ans[2]-2*ans[3]-ans[4] >= 0 # (1)

[1] TRUE

> ans[1]-ans[2]-2*ans[3]-2*ans[4] >= 0 # (2)

[1] TRUE

> sum(ans[2:4]) >= 1 # (3), (4)

[1] TRUE

> all(ans[2:4] >= 0) # (5), (6), (7)

[1] TRUE

z (2010-08-20 (金) 22:42:44)

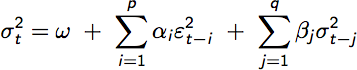

Coefficient(s)や、Hessian Matrixに標示される、muやomegaの解釈方法はどこを参照すればよいのでしょうか?ご教示頂ければ幸いです。

例) Coefficient(s):

mu ar1 ma1 omega alpha1

なるほど、貴重なアドバイスを有難うございます。出てきたGarch項を推計式の誤差項に代入する場合には、同時方程式を使う形になるのでしょうか? テキストを見比べて、自分で式を考えてみたのですが、なかなかうまくいきません。 アドバイス頂けると幸いです。宜しくお願い致します。 (fgarchはうまくInstallできなかったため、そちらのマニュアルを確認することは、失念していました。調べ方が甘く、すみませんでした。 ご丁寧にアドバイスをいただいて、有難うございました。)-- z 2010-08-31 (火) 19:05:42

rの初心者 (2010-08-20 (金) 16:28:28)

とあることでRを用いて多変量解析を行う必要が生じまして、ダウンロードしてインストールしました。ところがメッセージ言語は文字化けしているようで日本語で表示されません。ただし「ファイル」「ヘルプ」といった表示は正常です。どうすればよろしいでしょうか? よろしくお願いします。

z (2010-08-20 (金) 14:29:41)

RでTARCH(Threshold GARCH)をLoopで100社*10年分行おうと調べてみたのですが、該当する機能が見つかりませんでした。

RでTARCHするのと同じ結果を得られる機能がございましたらご教示頂けると幸いです。

宜しくお願いします。

青葉ほととぎす (2010-08-20 (金) 14:18:14)

最近、Rでプログラムを始めたものです(Vistaでversion 2.10.1を使用)。

あるプログラムを作っているときに不可解な結果がでて、いろいろ試した結果、forループのところに問題がることが分かってきました。

以下は、問題の部分だけを抜き出したものです。

初め実験1を行っていたのですが問題があり、実験2のように書き変えたところうまくいきました。sim.rate <- seq(0, 1, by=0.01) result.matrix <- matrix(0, nrow=length(sim.rate), ncol=2) # 実験1 for(i in sim.rate) { result.matrix[i*100, 1] <- result.matrix[i*100, 1]+1 } # 実験2 for(i in 1:length(sim.rate)) { result.matrix[i, 2] <- result.matrix[i, 2]+1 }この2つは以下のような異なる結果を出します。

[,1] [,2] [1,] 1 1 中略 [27,] 1 1 [28,] 2 1 [29,] 0 1 [30,] 1 1 中略 [56,] 1 1 [57,] 2 1 [58,] 0 1 [59,] 1 1 中略 [95,] 1 1そこで質問ですが、forループのリストしてベクトルを使ってはいけないのでしょうか?なぜこんな違いが生じるのかも教えていただけると助かります。

> result.matrix[0, 1] numeric(0)もう一つは,i は sim.rate という実数値をとるので,0.05*100 は 5 になるのですが,いつも,期待されるとおりの結果にはならないということに注意が必要です。以下のように,sim.rate の 26 〜 32 番目の要素は 0.25 〜 0.31 ですが,それを使って計算される添え字は as.integer(sim.rate[26:32]*100)つまり,100 倍して,小数部を除いたものなので,29 になってほしいところが 28 になっているのがわかるでしょう(29 はなく,28 が 2 回出ていますよね)。

> sim.rate[26:32] [1] 0.25 0.26 0.27 0.28 0.29 0.30 0.31 > as.integer(sim.rate[26:32]*100) [1] 25 26 27 28 28 30 31ようするに,コンピュータの中での実数は(整数値や,2 進数で循環小数にならずに正確に表現できる実数を除いて),あくまでも「近似値」なのです。近似値を整数倍して小数部を除くと,期待されるのとは違う結果になることがあるということです。

> s <- 0 > for (i in 1:100) s <- s+0.01 # 0.01 を 100 回足し込む > s # 結果を書いて見ると [1] 1 # ちゃんと 1 になっているように見えますが > s == 1 # 1 と等しいかどうか見てみると [1] FALSE # 1 とは等しくないということがわかります

ななしのごんべ (2010-08-12 (木) 19:53:54)

Windows7 Home Premiumで最新のRを入れたら、パッケージがインストールできません。「コンピューターにiconv.dllがないため、プログラムを開始できません。この問題を解決するには、プログラムを再インストールしてみてください。」というエラーウィンドウが出ます。どなたか解決策をご教示いただけるとありがたいです。

しょーじん (2010-08-11 (水) 14:36:14)

積分した値を計算に使おうと思ったところ,「二項演算子の引数が数値ではありません」と出てしまい,計算に使えません.

その値自体を調べると「0.5 with absolute error < 5.6e-15」とでます.

計算に使うためにはどうしたらよいのでしょうか?

> x <- integrate(dnorm, -1.96, 1.96) > x 0.9500042 with absolute error < 1.0e-11 > x + 2 以下にエラー x + 2 : 二項演算子の引数が数値ではありません > str(x) List of 5 $ value : num 0.95 $ abs.error : num 1.05e-11 $ subdivisions: int 1 $ message : chr "OK" $ call : language integrate(f = dnorm, lower = -1.96, upper = 1.96) - attr(*, "class")= chr "integrate" > x$value [1] 0.9500042 > x$value + 2 [1] 2.950004

z (2010-08-07 (土) 23:56:43)

OLSを試みています。

推計式はComp1=α+βcomp0なので、以下の要領で、Syntaxを書いたら、Errorが出ました。--Syntax----- Result1<-lm(comp1~comp0) --error-------- Error in eval(expr, envir, enclos) : object 'comp1' not found利用しているデータは下記の要領で、Comp0-90 まで、Dayは1-150まで。回帰式は、Comp<n>=α+βComp0 を Comp1-90まで順にComp0で回帰する予定です。

day comp0 comp1 comp2 comp3 comp4 1 -0.010873538 -0.017208413 0.009237875 0.000000000 -0.012048193 2 0.007344111 -0.001945525 -0.010297483 0.013313609 0.000000000 3 0.016795163 0.031189084 -0.019653179 0.002919708 0.034146341 4 0.006113627 0.003780718 0.004716981 0.010189229 0.007075472 5 -0.002080986 -0.007532957 0.011737089 0.010086455 0.145199063 6 0.005460344 0.001897533 -0.012761021 -0.021398003 0.022494888Comp2以降はLoopでの処理を試みる予定なのですが、Comp1についての式は間違っていないようなのにエラーが出るので、調べ方にも窮しています。

a <- vector(mode="list", length=90)

for (i in 3:92) {

a[[i-2]] <- lm(d[, 2] ~ d[, i]) # このような使い方のときには,第2引数にデータフレームは指定不要

}

また,投稿の仕方(投稿書式)についても確認してください。読みにくい質問は答えてやろうという気がわかないかも知れませんね。上の質問は書き直しました。あなたが投稿した後に表示されたものと比較してみてください。どのようにすれば上のように表示されるのか調べてください。b <- lapply(paste("comp", 1:90, sep=""), function(x) lm(comp0 ~ eval(parse(text=x)), d))for (i in comp1: comp90){lm(d[,0]~d[,i])}としてみたのですが、以下のようなErrorが出ました。 -- z 2010-08-09 (月) 15:48:16

> for (i in 1:90) {

+ lm(d[, 0] ~ d[, i])

+ }

Error in eval(expr, envir, enclos) : object 'd' not found

> for (i in 3:92) {

+ lm(result1[, 0] ~ result1[, i])

+ }

Error in result1[, 0] : incorrect number of dimensions

> for (i in comp1:comp89) {

+ lm(result1[, 0] ~ result1[, i])

+ }

Error: object 'comp89' not found

> for (i in comp1:comp3) {

+ lm(result1[, 0] ~ result1[, i])

+ }

Error in result1[, 0] : incorrect number of dimensions In addition:

Warning messages:

1: In comp1:comp3 : numerical expression has 150 elements: only the first used

2: In comp1:comp3 : numerical expression has 150 elements: only the first used

> lm(result1[, 0] ~ result1[, i])a <- vector("list", length=4) # lm の結果は list なので,必要なメモリを確保

for (i in 3:6) { # i は順に 3, 4, 5, 6 をとる

a[[i-2]] <- lm(d[, i] ~ d[, i-1]) # i=3 のとき,a[[1]] <- lm(d[,3] ~ d[,2]) が実行される

}

a

# function には順に 1, 2, 3, 4がわたされ,

# lm(eval(parse(text="comp1")) ~ eval(parse(text="comp0")), data=d) が実行される

# 最終的には lm(comp1 ~ comp0, data=d) が実行される "comp1" と comp1 は別物だということに注意

b <- lapply(1:4, function(i) lm(eval(parse(text=sprintf("comp%i", i))) ~

eval(parse(text=sprintf("comp%i", i-1))), data=d))

b

# lapply っていったって,for とそうは変わらないのだ

C <- vector("list", length=4)

for (i in 1:4) {

C[[i]] <- lm(eval(parse(text=sprintf("comp%i", i))) ~

eval(parse(text=sprintf("comp%i", i-1))), data=d)

}

C

それぞれの関数の引用について,なにをやっているのかを確認すること。> a <- vector("list", 10)

> class(a) # vector は第一引数で指定するオブジェクトを

[1] "list"

> length(a) # 第二引数で指定する個数分用意する

[1] 10

> a[[2]] <- c(1, 3, 5) # リストの2番目の要素に付値(代入)する

> a[[2]] # 結果を表示してみる

[1] 1 3 5

> parse(text="comp1")

expression(comp1) # comp1 が作られるが,それは expression である

attr(,"srcfile")

<text>

> comp1 = "test dummy" # 例えば comp1 が "test dummy" という文字列だとすれば

> eval(parse(text=sprintf("comp%i", i)))

# これは,comp1 ということになり,それを print で表示すると "test dummy" という文字列になる

[1] "test dummy"

> print(eval(parse(text=sprintf("comp%i", i)))) # 上と同じ

[1] "test dummy"

これくらい冗長に書けばよいかな? -- 河童の屁は,河童にあらず,屁である。 2010-08-09 (月) 16:19:20gqt<-lapply(1:88, function(i){

gqtest( lapply(1:88, function(i){

lm(eval(parse(text=sprintf("comp%i", i))) ~ eval(parse(text=sprintf("comp%i", 0))), data=dataset)

}), data= dataset,fraction=50, order.by=NULL) })

Error in terms.default(formula) : no terms component

どうアレンジしたら良いのでしょう? 調べ方等、アドバイスを頂けると幸いです。 宜しくお願い致します。 -- z 2010-08-31 (火) 19:00:42

z (2010-08-07 (土) 21:47:40)

二進も三進も行かず、困っています。データを読み込む行はエラーが出ないのですが、二行目から+が出て、どんな構文を打っても、+が続きます。どこが間違っているのでしょうか?

例えば、下記のようになります。dataset<-read.csv("C:/Users/(myname)/Documents/(foldername) /(sheet name).csv”, header=T) + attach (dataset) +

森の熊五郎 (2010-08-05 (木) 16:21:03)

X <- c(0.1, 0.2, 0.3, 0.4) Y <- c(0.3, 0.5, 0.8, 0.5) Z <- c(0.6, 0.5, 0.7, 0.9) sum(X) sum(Y) A <- rbind(X, Y) sum(A) sum(Z) B <- rbind(A, Z) sum(B)この式を繰り返し文 forを使って実行する方法を知りたい。

BASICでは例えば、A(20,10)の各要素を足し算する方法としてS=0 for I=1 to 20 for J=1 to 10 S=S+a(i,j) next nextなる文にて計算が出来ますが、Rの場合、内側のループはsum文で処理をするとして、外側のループをFor文で制御仕様とした場合、どのように文を組めば良いでしょうか?ご教示下さい。上記の例ではsum文とrbind文と使えばよいのですが、rbind文を使わず、for文を使って組む方法を知りたいと思います。

A <- matrix(1:16, nrow=4, ncol=4)

B <- matrix(1:20, nrow=4, ncol=5)

nrA <- nrow(A)

ncA <- ncol(A)

ncB <- ncol(B)

S <- matrix(NA, nrow=nrA, ncol=ncA+ncB)

for (i in 1:nrA) {

for (j in 1:ncA) S[i,j] <- A[i,j]

for (j in 1:ncB) S[i,j+ncA] <- B[i,j]

}

# もし一重ループなら

S <- matrix(NA, nrow=nrA, ncol=ncA+ncB)

for (i in 1:nrA) {

S[i,1:ncA] <- A[i,]

S[i,ncA+1:ncB] <- B[i,]

}a <- rbind(X, Y, Z)

S <- 0

for (i in 1:nrow(a)) {

for (j in 1:ncol(a)) {

S <- S+a[i, j]

}

}

print(S)

# 内側のループはsum文で というへんな要望に答えるなら

a <- rbind(X, Y, Z)

S <- 0

for (i in 1:nrow(a)) {

S <- S+sum(a[i, ])

}

print(S)

# でもそんなことする必要もなくて

a <- rbind(X, Y, Z)

S <- sum(a)

print(S)

# rbind する必要さえなくて

print(sum(c(X, Y, Z)))

# どれも,あなたのプログラムの最後に sum(B) としたのと同じ答えを得ることになりますよ?

# それともまさか,

S <- 0

for (i in c("X", "Y", "Z")) {

S <- S+sum(eval(parse(text=i)))

}

print(S)

# または

S <- 0

for (i in c(X, Y, Z)) {

S <- S+sum(i)

}

print(S)

# みたいなのをお望みで?まさかね〜yoshi (2010-08-02 (月) 14:56:40)

memory.limit()について質問です。

R上でmemory.limit()

[1] 1535memory.limit(T)

[1] 12memory.limit(F)

[1] 10

となります・ここでmemory.limit(4000)

[1] 4000

とした後はmemory.limit()

[1] 4000memory.limit(T)

[1] 12memory.limit(F)

[1] 10

となります。ここで質問なんですが「memory.limit()」「memory.limit(T)」「memory.limit(F)」の違いはなんなのでしょうか?今現在Rのメモリの上限のことで非常に困っています。また、皆さんはこのようなコマンドをどこから学んでいるのでしょうか?もし、良いWEBページ等がありましたら教えてくれると幸いです。

yoshi (2010-08-02 (月) 10:49:35)

パッケージ「R.huge」のパッケージの読み込みが上手くいきません。

私がやったことは

�CRANミラーサイトから「R.huge」のzipファイルをダウンロード

�RのGUIで「ローカルにあるzipファイルからのパッケージのインストール」で「R.huge」のインストール

→RのGUI上では「パッケージ 'R.huge' は無事に開封され、MD5 サムもチェックされました 」と表示

�RのGUIで「パッケージの読み込み」で「R.huge」を選択し実行

→RのGUI上で「要求されたパッケージ R.oo をロード中です

エラー: パッケージ 'R.oo' をロードできませんでした

追加情報: 警告メッセージ:

In library(pkg, character.only = TRUE, logical.return = TRUE, lib.loc = lib.loc) :

'R.oo' という名前のパッケージはありません 」と表示

このように�までは良いと思うのですが、�でエラーが表示されてしまい、パッケージ「R.huge」が読み込まれていないと思います。

これを解決する方法を自分でも探したのですが分らなかったため今回投稿さしていただきました。よろしくお願いします。

aMC (2010-08-01 (日) 06:07:54)

たとえば、2→10なので1桁目、5→101なので2桁目、7→0111なので4桁目、などのように、2進数表記した時、右から数えて最初にゼロが出現する桁数を求める効率のよいやり方はありますでしょうか?ベクトルを与えると、何桁目かをベクトルで返してくれるようなものが欲しいのですが、forループを使うと時間が掛かり過ぎます。

> i2b <- function(x)

+ {

+ res <- integer(32)

+ for (i in 1:32) {

+ res[i] <- x %% 2

+ x <- x %/% 2

+ }

+ return(rev(res))

+ }

> b2i <- function(x)

+ {

+ return(sum(x*2^(31:0)))

+ }

> (a <- i2b(615729635))

[1] 0 0 1 0 0 1 0 0 1 0 1 1 0 0 1 1 0 1 0 0 1 0 0 1 1 1 1 0 0 0 1 1

> (b <- b2i(a))

[1] 615729635

> which(rev(a)==0)[1]

[1] 3

繰り返しておきますが,このプログラムが効率が悪いと言っても,あなたの人生に比べれば取るに足りない時間です。回答を待つ時間が無駄です。 -- 河童の屁は,河童にあらず,屁である。 2010-08-01 (日) 21:48:11cnt <- function(vector) {

x <- abs(vector)

z <- x * 0 + 1

times <- max(floor(log(max(x), 2)), 0)

for(i in 1:times) {

y <- x

x <- x * 0 - 1

x <- x + (y %% 2 != 0) * (y + 1) / 2

z <- z + (x != -1)

}

return(z)

}> foo <- function(x){a <- ceiling(log2(x));

suppressWarnings(min(which((floor(x/2^(0:(a-1)))%%2)==0)))}

> foo(1*2^5+1*2^4+1*2^3+1*2^2+1*2+1)

[1] Inf

> foo(1*2^5+1*2^4+1*2^3+1*2^2+0*2+1)

[1] 2

> foo(1*2^5+1*2^4+1*2^3+1*2^2+0*2+0)

[1] 1

> foo(1*2^5+1*2^4+1*2^3+0*2^2+1*2+1)

[1] 3

> foo(1*2^5+0*2^4+1*2^3+0*2^2+1*2+1)

[1] 3

> foo(1*2^5+0*2^4+1*2^3+1*2^2+1*2+1)

[1] 5qMC (2010-07-31 (土) 22:56:24)

10進数→2進数、あるいは2進数→10進数へと変換する関数はありませんでしょうか?

りりぽん (2010-07-31 (土) 11:56:57)

Rscriptで次のように、test.Rを実行させると、グラフタイトルの日本語文字化けが発生します。Rscriptを使わずに、直接、test.Rを実行すると問題なく日本語が表示されます。どなたか、解決方法をご教授いただけたら幸いです。よろしくお願いいたします。###### test.bat ################### C:\R-2.11.1-x64\bin\Rscript test.R ####### test.R #################### postscript(file="test.eps", horizontal=F, family="Japan1Ryumin") plot(1:10, main="日本語") dev.off() ################################### 使用フォーマット・R環境: ソースコード;UTF-8(BOMなし)エンコード コマンドプロンプト;cp932;MSゴシック R version 2.11.1 (2010-05-31) x86_64-pc-mingw32 locale: [1] LC_COLLATE=Japanese_Japan.932 LC_CTYPE=Japanese_Japan.932 [3] LC_MONETARY=Japanese_Japan.932 LC_NUMERIC=C [5] LC_TIME=Japanese_Japan.932

basel_firb (2010-07-29 (木) 15:18:47)

過去に「行列にfor文中の変数を含んだ名前をつける 」という質問があり、内容を読み、構文 eval(parse(text=...)を使用するということらしいのですが、よく分かりませんでした。

データフレームに、変数var1 var2 var3・・・var68というのがあり、for文を使って,h1=var1/var68,h2=var2/var68・・・と分子のvarを1〜67まで繰り返し計算したいのですが、どのようにすればよいのでしょうか?

h <- (d/d[,-68])[,-68]

colnames(h) <- paste("h", 1:67, sep="")

で十分です。 -- 河童の屁は,河童にあらず,屁である。 2010-07-29 (木) 17:09:13sano (2010-07-29 (木) 12:39:07)

こんにちは、hclustで階層的クラスタリングを行おうとすると、サイズ 3.4 Gb のメモリブロックを割り当てることができません。とエラーメッセージが出てしまいます。

OSはwindows7,Rのversionは version 2.11.1(64bit), メモリは48GB積んでいます。しかしwindowsのリソースモニターを見ると、11GB程度でまだ余裕があります。> memory.limit(T)と実行すると、

[1] 7363と表示されるので、Rが物理メモリを7GBしか、OSから割り当てられていないということではないかと思います。

30GB割り当ててもらおうと、> memory.limit(30000)と入力すると、

[1] 49149 警告メッセージ: In memory.size(size) : メモリー限界を減らすことができません。と表示され、うまくいきませんでした。

CPUがデュアルCPUでメモリを片側24GBずつ積んでいるのですが、このことも何か関係があるのでしょうか。

いろいろ調べてみたのですが、どうにもいかず、投稿させて頂きました。

お教えいただければ、幸いです。よろしくお願い致します。

sayaka (2010-07-26 (月) 11:59:13)

いつも参考にさせていただいております。自分でも本やGoogleなどで調べたのですがどうもわからず、質問させていただきました。

以下のようなデータ"test_data.csv"があるとき"T","T" "T","F" "T","T" "F","F" data <- read.csv("test_data.csv",header=F)というようにread.csvを使ってデータを読み込むと、以下のようにTやFが文字列ではなく論理値として出力されてしまいますが、どのようにすれば文字列として認識させることが出来るでしょうか?

> data V1 V2 1 TRUE TRUE 2 TRUE FALSE 3 TRUE TRUE 4 FALSE FALSEどうぞよろしくお願い致します。

> data <- read.csv("test_data.csv",header=F)

> data

V1 V2

1 T T

2 T F

3 T T

4 F F

5 A A

> data[-nrow(data),]

V1 V2

1 T T

2 T F

3 T T

4 F F

> str(data[-nrow(data),]) # 因子水準に "A" が残りますがご愛嬌

'data.frame': 4 obs. of 2 variables:

$ V1: Factor w/ 3 levels "A","F","T": 3 3 3 2

$ V2: Factor w/ 3 levels "A","F","T": 3 2 3 2> data <- read.csv("test_data.csv",header=F)

> is.data.frame(data)

[1] TRUE

> data <- lapply(data, function(x) ifelse(x, "T", "F"))

> is.data.frame(data)

[1] FALSE

> is.list(data)

[1] TRUE

> data <- as.data.frame(data)

> is.data.frame(data)

[1] TRUE

> data

V1 V2

1 T T

2 T F

3 T T

4 F FT,T,A

T,F,A

T,T,A

F,F,A

fixTF <- function(x) {

if (is.logical(x)) {

return(ifelse(x, 'T', 'F'))

}else {

return (x)

}

}

data <- read.csv("test_data.csv", header=FALSE)

data1 <- lapply(data, fixTF)

data1 <- as.data.frame(data1)

data1

V1 V2 V3

1 T T A

2 T F A

3 T T A

4 F F A