![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

![[RjpWiki] [RjpWiki]](image/../Rlogo.png)

初心者のための R および RjpWiki に関する質問コーナー

過去の記事のアーカイブ。

きむ (2010-03-08 (月) 00:50:28)

いつも勉強させていただいてます。

毎度、基本的なことですみませんが、質問させてください。

現在、以下のような処理をしようとしています。

具体的には、dataA(45万個のデータ)のxとdataB(2000個程度のデータ)のyをidというフラグで関連づけて簡単な処理(zを求める)をしたいと考えています。

(「if(length(y)==0) y <- 0」は該当しないidがほとんどであり、この場合にnumeric(0)が帰ってくるため、このようにしてみました。)

ii <- 450000 z <- numeric(ii) for(i in 1:ii){ y <- dataB[dataB$id == dataA$id[i],"y"] if(length(y)==0) y <- 0 ifelse(y < dataA$x[i], z[i] <- 0, z[i] <- y-dataA$x[i]) }

ただ、45万回のforループを処理するため、かなり時間がかかります。

dataAをdataBの共通分(5万個程度)のみ抽出し、処理してからdataAにmergeしようかとも思いましたが、メモリ不足でmergeできませんでした。

applyファミリー等を使えば、forを内部化し、処理を高速化することが可能でしょうか?

プログラミングのテクニックについて、アドバイスいただければ助かります。

基本的な質問で申し訳けありませんが、よろしくお願いいたします。

mesh.id m5 GL 1 S035E005-21-3-3 21 100 2 S035E005-21-3-3 22 100 3 S035E005-21-3-3 23 100dataBの内容(データ数2063):FL2が先ほどの例のyです

mesh.id FL2 1 S035E010-14-1-2 21.36078 2 S035E010-14-1-4 20.57547 3 S035E010-14-2-1 20.80305ちなみに、実際のプログラムです:dataAがm5GL,dataBがm25Vshです。1つのm25Vshが25個のm5GLに対応しているのでm5GLのうちの使用分は51575個です。 -- きむ 2010-03-08 (月) 10:09:13

kk <- length(m5GL$mesh.id)

FL <- numeric(kk)

for(i in 1:kk){ #5mメッシュGLと比較してメッシュ別FLを算定

FL2 <- m25Vsh[m25Vsh$mesh.id == m5GL$mesh.id[i],"FL2"]

if(length(FL2)==0) FL2 <- 0

ifelse(FL2 < m5GL$GL[i], FL[i] <- 0, FL[i] <- FL2-m5GL$GL[i])

}ユーザ システム 経過 8379.59 15.28 8453.30

> test <- function()

+ {

+ z <- numeric(ii)

+ for(i in 1:ii){

+ y <- dataB[dataB$id == dataA$id[i],"y"]

+ if(length(y)==0) y <- 0

+ ifelse(y < dataA$x[i], z[i] <- 0, z[i] <- y-dataA$x[i])

+ }

+ return(z)

+ }

> set.seed(666)

> ii <- 450000

> dataA <- data.frame(id=sample(ii), x=rnorm(ii))

> num <- 2000

> dataB <- data.frame(id=sample(ii, num), y=rnorm(num))

> system.time(z <- test())

ユーザ システム 経過

80.553 0.488 80.596

> test2 <- function()

+ {

+ z <- numeric(ii)

+ for(i in 1:ii){

+ y <- dataB[dataB$id == dataA$id[i],"y"]

+ if(length(y)==0) y <- 0

+ z[i] <- y

+ }

+ z <- ifelse(z < dataA$x, 0, z-dataA$x) # これはループの外で

+ return(z)

+ }

> system.time(z2 <- test2())

ユーザ システム 経過

62.656 0.984 63.291

> all.equal(z, z2) # 答えが同じになることを確かめよう!

[1] TRUEEmacs超初心者 (2010-03-07 (日) 04:44:03)

Emacs 23 on Windowsを先日から使い始めました。

若干、ここで質問するべき事項かどうか微妙なところではございますが、他で質問する場所が見当たりませんので、質問させてください。

ESSとauto-completeを使用しているのですが、ESSモード時にいちいちM-x auto-complete-modeと打たなくてはなりません。(global-auto-complete-mode t)や

(add-hook 'ess-mode-hook '(lambda () (auto-complete-mode)))をしてみましたが、自動でオンになりませんでした。

ESSモード時もしくは.Rファイルを開いたら、自動でオンにするための何か良い解決方法などはございますでしょうか?

(setq ess-mode-load-hook

'((lambda ()

(require 'auto-complete)

(when (boundp 'ac-modes)

(setq ac-modes

(append ac-modes

(list 'ess-mode ))))

(global-auto-complete-mode t)

)))

などと書けば、auto-complete.el自体を編集しないでもOKです。-- 2010-03-08 (月) 12:03:02(when (boundp 'ac-modes)

(setq ac-modes

(append ac-modes

(list 'ess-mode))))

でうまくいきました。ac-modesがキーワードなんですね。ありがとうございましたm(_ _)m -- Emacs超初心者 2010-03-08 (月) 16:27:23にわか (2010-03-04 (木) 00:18:15)

winXPで2.10.1を使っています

NIRのデータでPLS回帰をしようと思っていろいろ調べているところですが、パッケージplsのサンプルデータyarnのデータ構造がよくわからないので、どなたか教えてください。

NIRのデータが波長ごとに列変数になっているように見え、表示させると列名がNIR.1 NIR.2・・・NIR.268 density trainのようになっています。

ところがnames(yarn)をしますと、

[1] "NIR" "density" "train"

で、列変数が3つしかなく、NIR.1〜NIR.268が全てNIRに代表されています。

これはどういう構造のデータフレームなのでしょうか。また、どのようにすればこういう構造のデータフレームが作れるのでしょうか。

よろしくご教示のほどお願いします。

y <- c(1, 2, 3) x <- matrix(c(1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12), nrow=3, ncol=4) attr(x, "dimnames") <- list(NULL, NULL) ZZZ <- list(NIR=x, a=y)これで一応、plsr(a ~ NIR, 2, data=ZZZ・・・・) のように、NIRだけでNIR.1からNIR.4を指定することができます。ただ、このZZZをデータフレームとすることが出来ません。根本的に間違っている様な気がします・・・ NIRデータをpls回帰に使われておられる方、データの作り方をご教示いただけないでしょうか。よろしくお願いします。 -- にわか 2010-03-04 (木) 14:03:24

cex (2010-03-03 (水) 18:54:40)

CRANからRColorBrewerをインストールしたのですが,色の分割数が9まででいまひとつ使い勝手が良くありませんでした.

そこで,多数(100程度)の分割に耐えうるカラーパレットを追加するようなRのパッケージはありますでしょうか?

もしご存じの方がいらっしゃれば,ご教示お願いします.

まるこ (2010-03-02 (火) 20:14:55)

R初心者です。

Rのバージョンは2.10.1、OSはVISTAです。

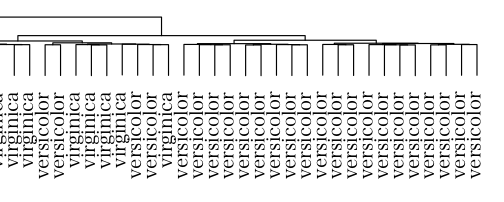

クラスター分析がしたくて、data <- read.table("xxx.csv", header=TRUE, sep=",") d <- as.dist(data) ans <- hclust(d, method="ward") plot(ans, hang=-1)というスクリプトを教えていただきました。

データはあらかじめ作り、「カレントディレクトリ」に入れるようにという指示でした。

「カレントディレクトリ」というのは、Rが入っているフォルダという意味でしょうか?

D\Program Files\R-2.10.1 や、その中の「bin」や「doc」に保存して上記のスクリプトを実行しましたが、エラーになりました。

エラーメッセージは、In file(file, "rt") : ファイル 'rensyuu.csv' を開くことができません: No such file or directory > d <- as.dist(data) 以下にエラー as.vector(x, mode) : cannot coerce type 'closure' to vector of type 'any' > ans <- hclust(d,method="ward") 以下にエラー hclust(d, method = "ward") : オブジェクト 'd' がありません > plot(ans,hang=-1) 以下にエラー plot(ans, hang = -1) : オブジェクト 'ans' がありませんとなります。

それで、CSVファイルの保存場所が間違っているのだと思い、1行目をdata <-read.table(file.choose(), header=TRUE, sep=",")として、ファイルを選び、実行しました。

すると、またエラーメッセージが出ました。警告メッセージ: 1: In storage.mode(m) <- "numeric" : 強制変換により NA が生成されました ~ 2: In as.dist.default(data) : 正方行列ではありません ~ > ans <- hclust(d,method="ward") 以下にエラー hclust(d, method = "ward") : 外部関数の呼び出し(引数 11) 中に NA/NaN/Inf があります > plot(ans,hang=-1) 以下にエラー plot(ans, hang = -1) : オブジェクト 'ans' がありません過去ログで、データを新しいブックに貼り付けたらNAが消えたという方がいたので

それもやってみましたが、解決しません。

CSVファイルの保存場所の件と、2番目の方法でエラーにならないためにはどうしたらいいか、どちらのことでも結構ですので、ご存じの方にアドバイスをいただきたいと思います。

よろしくお願いいたします。

森の熊五郎 (2010-03-01 (月) 23:54:09)

下記のプログラムを使って、修理の件数予測をしようと思っています。

手法は簡単で、過去の製品の前年度比実績推移をもとに直近のデータも

過去と同じ推移になると想定して予測をします。

2002年に出したAモデルから2007年に出したFモデルを例に作りました。修理件数は2005年から現在までのデータがCSVのファイルにあります。

Aモデルに比べFモデルは60ヶ月遅れて出しました。2002年のモデルの2005年の

修理データは出荷後3年のデータですので、2007年モデルにとっては2010年、つまり今年の状況にちかいだろうという想定をし、ラグ関数で時間をシフトし、それぞれの結果をグラフで見て検討しています。

せっかくの計算結果をcsvに落とし、みんなに見せようと思って、プログラムを作りましたが、このまま、実行するとせっかくタイムラグ関数を使ってシフトしたにもかかわらず、書き込まれたCSVにはタイムシフト前の状態で書き込まれます。当たり前といえば当たり前なのですが、タイムラグがかかったまま

CSVに書き込む方法はありますか?ご教示ください。repair <- read.csv("Repair2005_10.csv", header=TRUE) N2002A <- ts(repair$X2002A, start=c(2005, 4), frequency=12) N2003B <- ts(repair$X2003B, start=c(2005, 4), frequency=12) N2004C <- ts(repair$X2004C, start=c(2005, 4), frequency=12) N2005D <- ts(repair$X2005D, start=c(2005, 4), frequency=12) N2006E <- ts(repair$X2006E, start=c(2005, 4), frequency=12) N2007F <- ts(repair$X2007F, start=c(2005, 4), frequency=12) R2002A <- lag(N2002A/lag(N2002A, k=-12), k=-64) R2003B <- lag(N2003B/lag(N2003B, k=-12), k=-52) R2004C <- lag(N2004C/lag(N2004C, k=-12), k=-40) R2005D <- lag(N2005D/lag(N2005D, k=-12), k=-28) R2006E <- lag(N2006E/lag(N2006E, k=-12), k=-16) R2007F <- lag(N2007F/lag(N2007F, k=-12), k=- 4) w7 <- rep(1, 7)/7 MDA <- filter(R2002A, filter=w7, sides=2) MDB <- filter(R2003B, filter=w7, sides=2) MDC <- filter(R2004C, filter=w7, sides=2) MDD <- filter(R2005D, filter=w7, sides=2) MDE <- filter(R2006E, filter=w7, sides=2) MDF <- filter(R2007F, filter=w7, sides=2) MRESULT <- data.frame(MDA, MDB, MDC, MDD, MDE, MDF) write.csv(RESULT, "RESULT200510.csv", row.names=TRUE)

> MRESULT=data.frame(MDA,MDB) > write.csv(RESULT,"RESULT200510.csv",row.names=TRUE) 以下にエラー inherits(x, "data.frame") : オブジェクト 'RESULT' がありませんとなります。つまり,期待する結果が得られないといっているのは,ファイルに書き出すものが違っているだけなんじゃないですか?

> set.seed(666)

> repair <- data.frame(X2002A=1:120, X2003B=1001:1120)

> head(repair)

X2002A X2003B

1 1 1001

2 2 1002

3 3 1003

4 4 1004

5 5 1005

6 6 1006

> N2002A <- ts(repair$X2002A, start=c(2005, 4), frequency=12)

> N2003B <- ts(repair$X2003B, start=c(2005, 4), frequency=12)

> R2002A <- lag(N2002A/lag(N2002A, k=-12), k=-64)

> R2003B <- lag(N2003B/lag(N2003B, k=-12), k=-52)

>

> w7 <- rep(1, 7)/7

> MDA <- filter(R2002A, filter=w7, sides=2)

> MDB <- filter(R2003B, filter=w7, sides=2)

> MRESULT <- data.frame(MDA, MDB)

> head(MRESULT)

MDA MDB

1 NA NA

2 NA NA

3 NA NA

4 5.444898 1.011952

5 3.944898 1.011940

6 3.278231 1.011928きむ (2010-02-18 (木) 19:05:21)

いつも勉強させていただいております。

モデルを用いたクラスター分析をしようとパッケージ「mclust」をCLANよりダウンロード、インストールしたのですが、library(mclust)で呼び出したときに、以下が表示されます。by using mclust, or by using any other package that invokes mclust, you accept the license agreement in the mclust LICENSE file and at http://www.stat.washington.edu/mclust/license.txtそこで、上記サイトに行って「license.txt」ファイルをダウンロードしてきたのですが、それをどのように設定したら良いのかがわかりません。

(とりあえず上記ライセンスでテストし、使えそうであれば正式な費用負担を考えています。←パッケージにも有償のものがあるのを今回初めて知りました。)

これまで、パッケージのライセンスがファイル形式のものを使用したことがなく、途方にくれています。

設定方法をご存知の方がおられましたら、教えてください。

よろしくお願いします。

くま (2010-02-18 (木) 10:17:57)

これまで正常に起動していたRcmdr上で、dev.off()を実行すると、突然エラー:cannot shut down device 1 (the null device)が出るようになってしまいました。インストールしているRcmdr 1.4-10/R 2.8.1でもRcmdr 1.5-4/R 2.10.1でも同じエラーが出ます。また、再起動しても同じです。OSはWindows 7 Home Premiumです。完全にお手上げの状態です。対処方法をご教示いただけると有り難いです。

ken (2010-02-16 (火) 22:07:15)

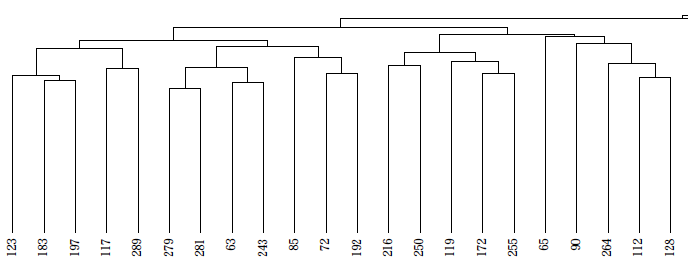

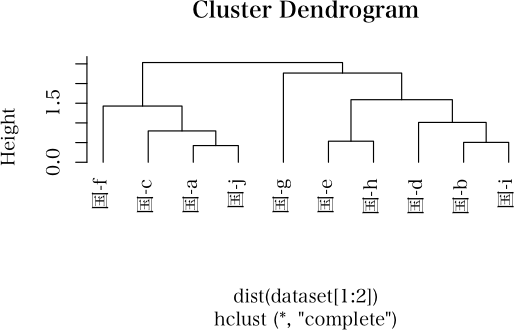

クラスタ解析をRで実施するにはいくつかの関数があるようですが、デンドログラムのプロット後さらにrect.hclustで加工したいためhclustの利用を考えています。

hclustでデンドログラムをプロットする際に要素を列の平均の大きい順にしたいのですが、どうしてもわからないため質問させていただきます。

私が行っている操作は以下の通りです。set.seed(567) x <- round(matrix(rnorm(50),ncol=5),3) d <- dist(x) cl <- hclust(d,method="complete") plot(cl, sub="none", main="hclust Dendrogram", hang=-1)目的としているプロットは次の操作で得られています。

しかし、rect.hclustで加工ができないので悩んでいます。dc <- as.dendrogram(cl) Colv <- colMeans(x) ddc <- reorder(dc, Colv) plot(ddc, main="as.dendrogram Dendrogram")何卒、アドバイスをいただけますようお願いいたします。

ざーさい (2010-02-15 (月) 08:43:19)

ある疾患に罹患した人のID8桁のリストがあり、罹患した人そうでない人のIDのリスト(1ID複数レコード)のうち罹患人は1をそうでない人には0を変数として割り付けたいのですが、どうすればいいでしょうか?

> data <- data.frame(id = as.character(10000001:10000010))

> id.list <- c("10000002", "10000005", "10000007")

> data$dis <- 0

> data$dis[data$id %in% id.list] <- 1

> data

id dis

1 10000001 0

2 10000002 1

3 10000003 0

4 10000004 0

5 10000005 1

6 10000006 0

7 10000007 1

8 10000008 0

9 10000009 0

10 10000010 0

もっと簡単な方法もあるかも -- surg 2010-02-15 (月) 15:12:51くま (2010-02-12 (金) 06:41:57)

RはXPで使っていましたのである程度は分かっているつもりでしたが、この度Windows 7にインスト―ルして使ったところ、aovやlmを実行すると、

関数"is"を見つけることができませんでした

というエラーメッセージが出て計算できなくなってしまいました。どうすれば、よろしいでしょうか。対策をご教示いただけるとありがたいです。

なお、操作はRcmdr上から行っており、その他の計算は支障なくできています。

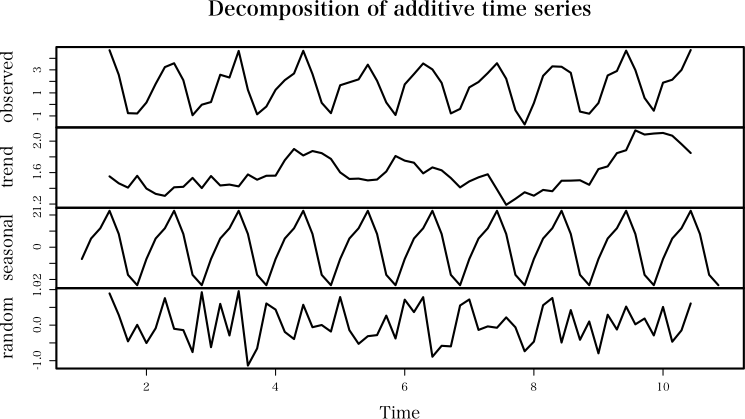

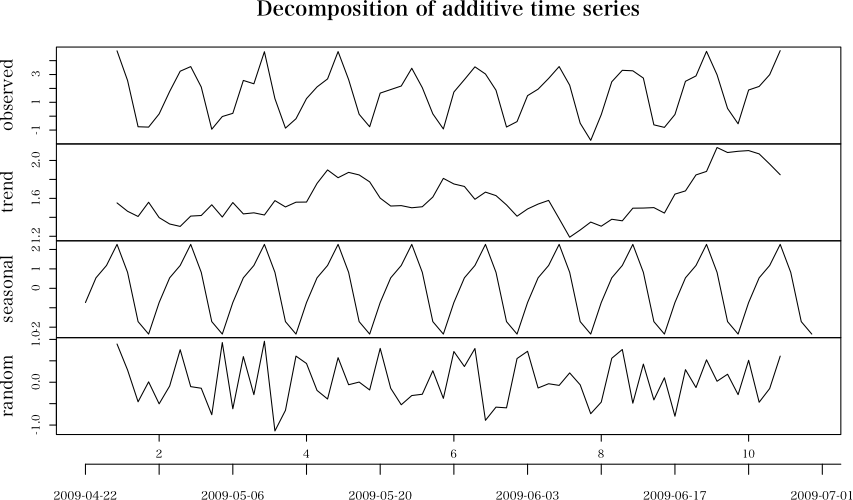

Rは初心者 (2010-02-11 (木) 00:04:12)

修理受付の予測をするために、Rを勉強を始めました。

「Rによる時系列分析入門」を片手に悪戦苦闘の毎日です。

修理の件数は、季節変動があり、週変動もあります。

すなわち、

�修理は冬より夏に多く、

�火曜日にピークがきて週末にかけて台数が落ち込む

という傾向があります。

これは

�夏場の温度によって部品が壊れやすくなる

�お店に修理に出すのが週末で物流TATを考えると、工場にくるのが火曜日ごろになる

ということが原因です。

日毎の修理受付件数データを蓄積し、Rを使って予測までをして見ようと思っています。

月次のデータをもとに季節変動を抽出する方法、例えば、月次データをTESTDATA.csvに入れて、REP = read.csv("TESTDATA.csv", header=TRUE) RNUM = ts(REP$num, start=c(2008, 4), frequency=12) bunkai = decompose(RNUM, type="multiplicative") plot(bunkai)として季節変動を分解する方法までは勉強しました。

これを日次データをもとに、週変動と季節変動を求める方法を検討して,悩んでいます。上記のように、ts関数はRNUM = ts(REP$num, start=c(2008, 4), frequency=12)のように、年・月しか入れることができず、

Start=c(2008, 1, 4)のように年月日をいれることができない。

また日次でやると、祝日(修理職場も休みなので入荷がゼロ)となり、データ欠落が出て、かつその影響が翌日にでるような場合、それを補正する方法がわかりません。

予測まではまだまだですが、このような場合、どのように分析をしたらよいのかをアドバス頂けたらと思います。

nat (2010-02-07 (日) 02:37:21)

こんにちは。R初心者です。いつも拝見させていただいています。

ある式を最小化する2つのパラメータをoptimを使って求めようとしています。

2つのパラメータx1, x2のうち、x2はx1によって最適解の範囲が制限されるため、うまくいきません。f <- function(par, B, u) { x1 <- par[1] x2 <- par[2] (x1 / B + x1 / (B - x1) ) - (x1^u + x2^u) }おおよそ以下のような値を代入します。

B <- 10e+5 u <- -0.7 Q <- B / 10f を最小化し、かつx1 + x2 <= Qとなるようなx1, x2を出してきてほしいのですが、どのようにして「かつx1 + x2 <= Q」の部分を組み込めばよいのかがわかりません。

constrOptimなども試しましたが、よくわかりませんでした。optim(fn=f, par=c(0, 1), B1=B1, u=u, lower=c(0, 0), upper=c(Q, Q), method="L-BFGS-B")このやり方だと、「かつx1 + x2 <= Q」の部分が満たされない時があります。

ご教授よろしくお願いします。

> f <- function(par, B, u) {

+ Q <- B / 10

+ x1 <- par[1]

+ x2 <- par[2]

+ if((x1 + x2) > Q) 1e+10

+ else (x1 / B + x1 / (B - x1)) - (x1 ^ u + x2 ^ u)

+ }

>

> optim(c(1, 1), f, B = 10e+5, u = -0.7)

$par

[1] 1.542165e-37 1.258702e+00

$value

[1] -5.865545e+25

$counts

function gradient

501 NA

$convergence

[1] 1

$message

NULL

-- surg 2010-02-07 (日) 08:22:17> f <- function(par) {

+ x1 <- par[1]

+ x2 <- par[2]

+ if (x1+x2 > Q) x2 <- (Q-x1)*0.9 # 例えばこんな風にしてみる

+ (x1 / B + x1 / (B - x1) ) - (x1^u + x2^u)

+ }

> B <- 10

> u <- 0.7

> Q <- B / 10

> optim(c(0,1), f)

$par

[1] 0.3143118 0.6856882

$value

[1] -1.148777

$counts

function gradient

113 NA

$convergence

[1] 0

$message

NULLsyo (2010-02-06 (土) 17:11:34)

Rにてテキストマイニングの勉強をしている初心者なのですが、Rで語に対するTF-IDF判定や重要度判定を行いたいと考えています。Rでそのような事を行うためには、どのようなツールが最適でしょうか?初歩的な質問ですが、ご助言お願い致します。

yoou (2010-02-05 (金) 01:15:42)

Rで学ぶデータマイニングで、自宅のvistaを使い勉強してるのですが、 install.packages("relimp")でJapan(Tokyo)を選ぶと以下のエラーメッセージが出ます。--- Please select a CRAN mirror for use in this session --- 警告:unable to access index for repository ftp://ftp.ecc.u-tokyo.ac.jp/CRAN/bin/windows/contrib/2.4 download.packages(pkgs, destdir = tmpd, available = available, 中で警告がありました: no package 'relimp' at the repositoriesどうしたら解決できるでしょうか。

mittyo (2010-02-03 (水) 09:48:44)

はじめて投稿します。

RでGRASSのデータを使いたくて、spgrass6をインストールしようとしましたが、うまくいきませんでした。

エラーは以下の通りです。Error in dyn.load(file, DLLpath = DLLpath, ...) : 共有ライブラリ '/root/R/i686-pc-linux-gnu-library/2.10/rgdal/libs/rgdal.so' を読み込めません /root/R/i686-pc-linux-gnu-library/2.10/rgdal/libs/rgdal.so: undefined symbol: pj_get_ellps_ref Error : package 'rgdal' could not be loaded ERROR: lazy loading failed for package ‘spgrass6’rgdal.soに問題がありそうなので、Rでlibrary("rgdal")を実行したところ、

> library("rgdal") 要求されたパッケージ sp をロード中です Error in dyn.load(file, DLLpath = DLLpath, ...) : 共有ライブラリ '/root/R/i686-pc-linux-gnu-library/2.10/rgdal/libs/rgdal.so' を読み込めません /root/R/i686-pc-linux-gnu-library/2.10/rgdal/libs/rgdal.so: undefined symbol: pj_get_ellps_ref エラー: 'rgdal' に対するパッケージもしくは名前空間のロードが失敗しました > Error in dyn.loadError in dyn.loadと同様のエラーが出ました。

rgdalを入れなおそうと思い、install.packages("rgdal", dependencies=TRUE)を実行し、再度

library(rgdal)、install.packages("spgrass6", dependencies=TRUE)を実行しましたが、同様の結果でした。

環境ですが、OS:Vine Linux 5.0 R:version 2.10.0 (2009-10-26)です。

ご教示のほどよろしくお願い致します。

* Installing *source* package ‘rgdal’ ...

gdal-config: gdal-config

checking for gcc... gcc -std=gnu99

checking for C compiler default output file name... a.out

:

SNIP

:

** building package indices ...

* DONE (rgdal)

ダウンロードされたパッケージは、以下にあります

‘/tmp/RtmpvHL96d/downloaded_packages’

'.Library' 中のパッケージの HTML 索引を更新します

> library("rgdal")

要求されたパッケージ sp をロード中です

Error in dyn.load(file, DLLpath = DLLpath, ...) :

共有ライブラリ '/usr/local/lib/R/library/rgdal/libs/rgdal.so' を読み込めません

/usr/local/lib/R/library/rgdal/libs/rgdal.so: undefined symbol: pj_get_ellps_ref

エラー: 'rgdal' に対するパッケージもしくは名前空間のロードが失敗しましたNote: proj/conus not foundの部分が気になるのですが… -- mittyo 2010-02-04 (木) 03:05:50

sui (2010-01-30 (土) 10:00:23)

いつもお世話になり、ありがとうございます。

下記につきまして長くなりますが、ご教示の程、よろしくお願いいたします。HT <- rep(0:1, c(10, 20)) cHT <- factor(HT, levels=0:1) group <- c("A","B","A","B","A","B","A","B","A","B","A", "B","A","B","A","B","A","B","A","B","A","B", "A","B","A","B","A","B","A","B") df <- data.frame(HT, cHT, group)上記のようなデータフレームを仮定します。(HT=1は高血圧あり、HT=0はなし)

列の要素が整数の場合(列:HT)は目的とするgroup毎の高血圧ありの度数とカイ2乗検定のP値を得ることが出来ました。> for(i in 1) { # 解析する列の入力 df <- df # データフレーム名の入力 g<-group # group の所にグループ変数の列名 cat(names(df)[i], by(df[, i], g, sum), (chisq.test(table(factor(df[, i], levels=0:1), df$g)))$p.value) } HT 10 10 0.6985354 # group 毎の高血圧ありの度数とカイ2乗検定の P 値最終の目標は class() 関数で列の要素を判別して if を用い、列の要素が連続変数の時は平均値と t 検定の P 値を、カテゴリカルデータであれば上記のように group 毎の高血圧ありの度数とカイ2乗検定の P 値を出力する事です。そこで初めからカテゴリカルデータに変換された cHT を用いて同様の出力を得たいと考えました。しかし、カテゴリカルデータに変換した cHT なら by(df$cHT, group, summary) とすれば HT ありの人数は分かりますが同時になしの人数まで出力されてしまいます。

カテゴリカルデータを用いて上記のように group 毎の高血圧ありのみの度数とカイ2乗検定の P 値(例数が少ないので fisher.test の方が良いかもしれませんが)を出力する方法があればご教示頂きたいと思います。よろしくお願いいたします。(R version 2.8.1)

require(Hmisc) summary( group ~ HT + cHT, data=df, method='reverse', test=T)デフォルトで continuity correction 無しの カイ2乗検定をします.連続値の場合は平均値+偏差とか,中央値と quartiles とかいろいろ設定を選べます.

> table(HT, group)[2,] A B 10 10 > table(cHT, group)[2,] A B 10 10次は,データによって検定法を選択して実行することですね。「連続変数なら t 検定」,「カテゴリー変数ならカイ二乗検定」の2通りでよいのですね。カテゴリー変数は必ず factor になっていると仮定できる。つまり,HT のように整数値で表されているカテゴリー変数は考えなくて良いのですね。上に続けて,以下の通り。

> df$x <- rnorm(30)

> head(df)

HT cHT group x

1 0 0 A -0.64007308

2 0 0 B 0.34494342

3 0 0 A -0.59577331

4 0 0 B 0.05745206

5 0 0 A -1.02755942

6 0 0 B 0.41386607

> for (i in c(2, 4)) {

+ x <- df[, i]

+ if (class(x) == "factor") {

+ tbl <- table(x, group)

+ cat(colnames(df)[i], tbl[2,], chisq.test(tbl)$p.value, "\n")

+ } else if (class(x) == "numeric") {

+ cat(t.test(x ~ group)$p.value, "\n")

+ } else {

+ stop("error")

+ }

+ }

cHT 10 10 0.6985354

0.3210783

こんなもんでしょうかね。 -- 河童の屁 2010-01-30 (土) 19:32:01森の熊太郎 (2010-01-28 (木) 15:22:19)

現在、コールセンタの利用者のリピータ状況を調べたいと思っています。

一人ひとりにユニークな番号(会員番号:重複なし)をつけています。

月に何万件と問い合わせがきます。問い合わせのたびにログを1件づつ残しており、そのデータが蓄積されています。ただ件数が多いので、Excelでは1月分を1区切りでファイルを作り管理しています。

それらのファイルをもとに、例えば1月 2月 3月 4月 X0011 X23243 X3454 X46738 X0023 X43534 X3456 X78987のように横に月、たてにログ毎の会員番号を記載した表を作り、ここから、リピータの登場の程度を調べたいと思います。

コール数 ユーザ数 累計コール数 累計ユーザー数 1月 23456 19876 23456 19876 2月 25677 20343 49133 34020のように累計ユーザ数を調べたい。

つまり、ユーザは同月内でも複数回コールをし、また翌月もコールをする傾向があり、コールセンタとして、ユーザの局在性がどれだけあるのかを調べたいと思います。

Excel2007があれば、ピボットテーブルで簡単に出来るかと思いますが、Rでもこのようなことは出来ますか?(Excel2007は業務用になく、結果としては出来ずにおり、困っております)

sui (2010-01-22 (金) 20:37:37)

初めて投稿いたします。Rは始めたばかりで初歩的な質問かもしれませんがよろしくお願いします。(R version 2.8.1)a <- c(1:10) b <- c(11:20) c <- c(21:30) d <- c(31:40) group <- c("X", "X", "X", "X", "X", "Y", "Y", "Y", "Y", "Y") df <- data.frame(a, b, c, d, group)以上のようなデータフレームを仮定します。 グループXとY間でパラメータ a, b, c, d の平均値に差があるかどうかを検定する場合(上のデータの分布は正規分布ではありませんが)、t.test(a ~ group)、t.test(b ~ group)、t.test(c ~ group)と順番に関数を実行していけば結果は得られます。しかし、実際のデータではパラメーターが50程度あるため一括して結果を得たいと考えています。どのような関数(apply family? ←変数が2つでも使用できるのでしょうか)もしくはプログラム(forを用いたプログラム?)を用いればいいのでしょうか?ご教示いただければ幸いです。

> for (i in 1:4) print(t.test(df[,i]~df$group))

Welch Two Sample t-test

data: df[, i] by df$group

t = -5, df = 8, p-value = 0.001053

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-7.306004 -2.693996

sample estimates:

mean in group X mean in group Y

3 8

以下略for (i in 1:4) {

cat("=================\n")

cat("variable:", names(df)[i], "\n")

print(t.test(df[,i]~df$group))

}T-A (2010-01-22 (金) 00:29:41)

何度もすみません。

先ほど正規乱数を母集団として標本を抽出してその平均値を出すこと何回も繰り返すコマンドを質問したものです。

母集団とその標本平均の集団の分散が等しいものがほしいのですが、どうすればよいでしょうか・・・

x <- rnorm(100)

y <- (x-mean(x))/sd(x)

w <- 5*y+50

のようにして分散が25、平均50のデータを作って

そこから標本平均の集団も分散が25に近似するように抽出することは可能なのでしょうか。

replicate(200, mean(sample(w, 10)))

のようにして母集団から標本を抽出して平均値を求めることを200回繰りかえして、そこから分散が25に近似するように100個抽出することは可能でしょうか。

よろしければご教授ください。

w <- rnorm(200, 50,sd=5) h <- replicate( 5, sample(w,10, replace=F) ) hh <- t(t(h)/apply(h,2,sd)*sd(w))

Mame (2010-01-21 (木) 16:57:38)

たびたびすみません。

下でRserveについて質問したものです。

(まだ解決に至っておりませんが、できましたら報告します)

パッケージのarulesを利用して、アソシエーション分析をしたいのですが、リスト形式のデータをトランザクション形式に使用するとエラー(voidEval failed)が出てしまいます。

参考にしているのは、金明哲先生の

http://www1.doshisha.ac.jp/~mjin/R/200611_40.pdf

です。

書いたコードは、Rconnection c=new Rconnection((args.length>0)?args[0]:"127.0.0.1"); c.voidEval( "library(arules)" ); //データを作ります RList l = new RList(); l.add( new REXP( new String[] {"パン","牛乳","ハム","果物"} ) ); l.add( new REXP( new String[] {"ソーセージ","ビール","オムツ"} ) ); l.add( new REXP( new String[] { "弁当","ビール","オムツ","タバコ"} ) ); l.add( new REXP( new String[] {"弁当","ビール","オレンジジュース","果物"} ) ); //リストの作り方がよくわからなかったので //データフレームにしてらかリストに変換しました //下記ではエラーが出ました。 //String m = "data1 <-list(c(\"パン\",\"牛乳\",\"ハム\",\"果物\"),"+ "c(\"パン\",\"オムツ\",\"ビール\",\"ハム\"),"+ "c(\"ソーセージ\",\"ビール\",\"オムツ\"),"+ "c(\"弁当\",\"ビール\",\"オムツ\",\"タバコ\"),"+ "c(\"弁当\",\"ビール\",\"オレンジジュース\",\"果物\"))"; //c.voidEval( m ); c.assign( "data1", REXP.createDataFrame(l)); c.voidEval( "data1 <- list(data1)"); //REXP x = c.eval( "class(data1)" ); //System.out.println( x ); <= listとでます。 //この下でエラー(voidEval failed)になります。 c.voidEval( "data.tran <- as(data1,\"transactions\")");以上です。

よろしければご教授のほどよろしくお願いいたします。

松田紀之 (2010-01-21 (木) 14:59:28)

PrefixSpanをRで組み始めたのですが,うまく再帰的に書けずにいます.パッケージにもなさそうです.どなたかRで動かせる実用的なプログラムをご存知でしたら教えてください.

aoi (2010-01-21 (木) 11:47:48)

たびたびすみません。よろしくお願いします。

条件に一致する文字列を取り出したいと思っています。

例えば> exex_2 [,1] [1,] "a b dxe" [2,] "abcde" [3,] "a1v2 c4" [4,] "a1 b2 c3" [5,] "banana ringo kiwi orange kodama"のような文字列の行列があったときに、スペース区切りで一番はじめの要素だけを取り出す、2番目だけの要素を取り出す、3番目の要素だけを取り出すということを行いたいと思っています。

一番はじめの要素を取り出すのは> sub(" .*","",exex_2) [,1] [1,] "a" [2,] "abcde" [3,] "a1v2" [4,] "a1" [5,] "banana"で出来たのですが、2番目、3番目の要素を取り出すことが出来ません。

目標としては2番目の要素でしたら[,1] [1,] "b" [2,] [3,] "c4" [4,] "b2" [5,] "ringo"3番目の要素でしたら

[,1] [1,] "dxe" [2,] [3,] [4,] "c3" [5,] "kiwi"のように取り出せたら、と考えています。

Rの正規表現やHelpを読ませていただいたりしてしばらく考えたのですがうまく出来なかったので、すみませんがご教授いただければと思います。

またsessionInfo()~ R version 2.8.1 (2008-12-22) i386-apple-darwin8.11.1

です。よろしくおねがいします。

> sapply(strsplit(exex_2, " "), "[", 1) [1] "a" "abcde" "a1v2" "a1" "banana" "5" > sapply(strsplit(exex_2, " "), "[", 2) [1] "b" NA "c4" "b2" "ringo" NA > sapply(strsplit(exex_2, " "), "[", 3) [1] "dxe" NA NA "c3" "kiwi" NA > sapply(strsplit(exex_2, " "), "[", 4) [1] NA NA NA NA "orange" NA > sapply(strsplit(exex_2, " "), "[", 5) [1] NA NA NA NA "kodama" NA > sapply(strsplit(exex_2, " "), "[", 6) [1] NA NA NA NA NA NA

Mame (2010-01-21 (木) 10:09:14)

はじめて投稿させていただきます。

R、RServeともに初心者ですがよろしくお願いします。

現在、RServeをつかってグラフの画像を生成したいのですが、うまくいきません。

・RServeのjava-oldの中のexsample を参考にしています。

・plot は、画像が生成され中にプロットがされていました。

・histogram は、画像そのものは生成されるのですが、白の背景だけでヒストグラムは表示されませんでした。

・Rのコマンドラインからは、histogramで画像を生成することができます。

■環境

R version 2.10.1

Rserve version 0.6.1

Eclipse version 3.5.1

OS:Windows7(windows2000でも同じ結果でした)

ご教授のほど、よろしくお願いいたします。

■以下ソースコードimport org.rosuda.JRclient.*; public class HelloWorld { public static void main(String args[]) { try { Rconnection c=new Rconnection((args.length>0)?args[0]:"127.0.0.1"); //histogramを使うために読み込みます c.voidEval( "library(lattice)" ); c.voidEval("x <- iris"); REXP xp=c.eval("try(jpeg(\"test.jpg\"))"); if (xp.asString()!=null) { System.out.println("Can't open jpeg graphics device:\n"+xp.asString()); REXP w=c.eval("if (exists(\"last.warning\") && length(last.warning)>0) names(last.warning)[1] else 0"); if (w.asString()!=null) System.out.println(w.asString()); return; } //下のplot は描画できます。 //c.voidEval("plot(Sepal.Length, Petal.Length, data=x,col=unclass(Species))"); //背景が白い画像だけが出来上がります。 c.voidEval( "histogram(~ Sepal.Length, data=x)" ); c.voidEval("dev.off()"); c.close(); } catch(RSrvException rse) { System.out.println("Rserve exception: "+rse.getMessage()); } catch(Exception e) { System.out.println("Something went wrong, but it's not the Rserve: "+ e.getMessage()); e.printStackTrace(); } } }

T-A (2010-01-21 (木) 01:49:07)

R初心者の者です。

あまりの初心者でコマンドのし方がわからないのでよろしければご教授ください。

正規乱数100個を母集団として作り、大きさ10の標本を非復元抽出で取り出し、その標本平均を求めることを100回繰り返すコマンドをするにはどうすればよいでしょうか?

x <- rnorm(100)

y <- sample(x,10)

mean(y)

ここまではたどり着けたんですが、次に進めず困っています。

こんな感じでmean(y)を100個ほしいんですが・・・

kum (2010-01-16 (土) 19:57:41)

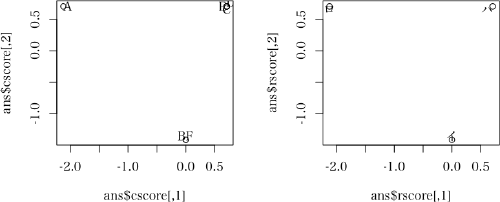

主成分分析の結果をbiplot(PC)で表すと第1主成分が横軸、第2主成分が縦軸になりますが、それを(1,3),(2,4)といったように別の主成分で図を書くようにはできないでしょうか?

editでbiplotの中身をそれらしく変更したりしましたができませんでした。

どなたかご教授ください。

> biplot3 <- stats:::biplot.princomp > biplot3 <- edit(biplot3)として

> function (x, choices = 1L:3L,scale = 1, pc.biplot = FALSE,suffix=suffix, ...) > biplot.default(t(t(scores[, choices])/lam), t(t(x$loadings[,suffix]) * lam), ...)とbiplot.princompを変更後

> suffix <- 1:100 > biplot3(PC,suffix=suffix)としましたが [以下にエラー t(x$loadings[, suffix]) : 選択の長さは 2 でなければなりません] と出てしまいました。 -- 2010-01-16 (土) 21:37:14

choices <- c(1, 3) biplot2(PC$scores[,choices], PC$loadings[,choices], suffix=suffix)のようにすればよいのですから。biplot3 に choices 引数を追加してやれば,使いやすくなるでしょう。ついでに,biplot.princomp がやっているスケール変更も biplot3 の初期部分でやるようにしてしまえばよいでしょうね。 -- 河童の屁 2010-01-16 (土) 22:06:35

a <- princomp(iris[ ,1:4]) # 動作確認用 princomp オブジェクトを作成 以下の2図を比較してちゃんと動くことを確認 biplot(a, choices=c(1,3)) # 本来の biplot.princomp で全ケースを描画 biplot3(a, choices=c(1,3), suffix=c(23, 101, 123)) # 3 ケースだけ描画ちょっと長くなるけど -- 河童の屁 2010-01-16 (土) 23:31:05

biplot3 <- function (x, choices = 1L:2L, scale = 1, pc.biplot = FALSE, # change

var.axes = TRUE, col, cex = rep(par("cex"), 2),

xlabs = NULL, ylabs = NULL, expand = 1, xlim = NULL, ylim = NULL,

arrow.len = 0.1, main = NULL, sub = NULL, xlab = NULL, ylab = NULL,

suffix = NULL, # add 前の定義はちょっとまずかったので訂正

...)

{

# add start # biplot.princomp の部分,一部変更

if (length(choices) != 2)

stop("length of choices must be 2")

if (!length(scores <- x$scores))

stop(gettextf("object '%s' has no scores", deparse(substitute(x))),

domain = NA)

if (is.null(suffix)) # biplot.princomp に追加

suffix <- 1:nrow(scores)

loadings <- x$loadings # 変更

lam <- x$sdev[choices]

if (is.null(n <- x$n.obs))

n <- 1

lam <- lam * sqrt(n)

if (scale < 0 || scale > 1)

warning("'scale' is outside [0, 1]")

if (scale != 0)

lam <- lam^scale

else lam <- 1

if (pc.biplot)

lam <- lam/sqrt(n)

x <- t(t(scores[, choices])/lam) # biplot.default の引数 x

y <- t(t(loadings[, choices]) * lam) # biplot.default の引数 y

# add end

# これ以降は biplot.default

n <- nrow(x)

p <- nrow(y)

:

# text(x, xlabs, cex = cex[1L], col = col[1L], ...) # 以下のように変更

text(x[suffix,], xlabs[suffix], cex = cex[1L], col = col[1L], ...) # change

:G-T (2010-01-15 (金) 11:58:25)

プログラム言語をRで初めて学んでいます。

かなりの初心者なので、質問内容に至らない点があるかと思いますが、どうかご指導ください。

今回牧山先生の解説(http://www1.doshisha.ac.jp/~mjin/R/200709_50.pdf)を読みながら、地図の作成を学んでいるのですが、

その際に使われるmaptoolsパッケージの"read.shape"という関数が、

「エラー: 関数 "read.shape" を見つけることができませんでした」と表示され、何故か使うことが出来ません。

きちんとmaptoolsパッケージを呼び出してから実行していますし、maptoolsパッケージに入っている他の関数"readShapePoly"は使うことが出来ました。

これはmaptoolsパッケージが中途半端にしかインストールできていないということなのでしょうか?

それを確認・修正する方法をご教授いただければ幸いです。

※アプリケーションが古いのかと思い、再度Rをversion 2.10.1にインストールし直しましたが、同じ症状が見られます。

※念のため使用環境を掲載いたします。sessionInfo()

R version 2.10.1 (2009-12-14)

i386-pc-mingw32

locale:

[1] LC_COLLATE=Japanese_Japan.932 LC_CTYPE=Japanese_Japan.932

[3] LC_MONETARY=Japanese_Japan.932 LC_NUMERIC=C

[5] LC_TIME=Japanese_Japan.932

attached base packages:

[1] stats graphics grDevices utils datasets methods base

other attached packages:

[1] maptools_0.7-29 lattice_0.17-26 sp_0.9-47 foreign_0.8-38

loaded via a namespace (and not attached):

[1] grid_2.10.1 tools_2.10.1

library(maptools)

Map<-readShapePoly("C:/GISdata/gunma.shp")

plot(Map)aoi (2010-01-14 (木) 12:38:13)

いつも丁寧に答えてくださり本当にありがとうございます。

拙い質問で申し訳ないのですが、よろしくお願いします。

grep関数で文字列の検索を行っています。

糖鎖の構造についての文字列の検索を行っているのですが、

例えば以下のような構造だったら

Fuca1-2Galb1-4GlcNAcb1-2Mana1-3(Fuca1-2Galb1-4GlcNAcb1-2Mana1-6)Manb1-4GlcNAcb1-4GlcNAcb-Sp20

末端の構造、つまり最初のFucだけ取り出したいと思っています。

上記のような構造でしたらgrep("^Fuc",mixmix_rownames)のように出すことが出来るのですが

ただ、grepの正規表現にひっかかってしまって

例えば

a-D-Gal-Sp8

だと

Galを出したいのですがgrep("^Gal",mixmix_rownames)で出すことが出来ません。

また、

[3OSO3][6OSO3]Galb1-4[6OSO3]GlcNAcb-Sp0

のような構造でもGalを出したいのですが、出すことが出来ません。

grep("[3OSO3]",mixmix_rownames,fixed=TRUE)にすると正規表現を無視することが出来るので、文字列が一致するものを取り出せるのですが、

そうすると末端構造(最初のGal)だけを取り出すことが出来ません。

ちなみに> sessionInfo() R version 2.8.1 (2008-12-22) i386-apple-darwin8.11.1です。

よろしくお願いします。

> mixmix_rownames <- c(

+ "Fuca1-2Galb1-4GlcNAcb1-2Mana1-3(Fuca1-2Galb1-4GlcNAcb1-2Mana1-6)Manb1-4GlcNAcb1-4GlcNAcb-Sp20",

+ "a-D-Gal-Sp8",

+ "[3OSO3][6OSO3]Galb1-4[6OSO3]GlcNAcb-Sp0"

+ )

>

> grep("^([A-z]-|\\[\\w*\\])*Fuc", mixmix_rownames, perl=TRUE)

[1] 1

> grep("^([A-z]-|\\[\\w*\\])*Gal", mixmix_rownames, perl=TRUE)

[1] 2 3

>

「これでは網羅できていない」に100カノッサ -- surg 2010-01-14 (木) 14:35:58grep("^Man",mixmix_rownames,value=TRUE)

[1] "Mana1-3(Mana1-6)Manb1-4GlcNAcb1-4GlcNAcb-Sp13"

[2] "Mana1-2Mana1-2Mana1-3Mana-Sp9"

:

[19] "Mana1-3(Galb1-4GlcNAcb1-2Mana1-6)Manb1-4GlcNAcb1-4GlcNAcb-Sp12"

[20] "[3OSO3][6OSO3]Manb1-4[6OSO3]GlcNAcb-Sp0"

[21] "b-D-Man-Sp8"

この内1から19は今も出せているのですが、20と21は出せていないので、どうすれば良いのか、という問いです。よろしくお願いします。hassyy (2010-01-14 (木) 04:09:07)

長いタイトルで申し訳ありません。よろしくお願い申し上げます。

Windows版R(ver2.9.0)にRODBC_1.3-1をインストールして作業しております。

RからAccess2003で作成したmdb内のクエリの結果に接続して、計算を行っています。

下記のように記載し、問題なくクエリに接続できて、必要なデータを入手することができるところまでは確認しました。conndb <- odbcConnectAccess("Data.mdb") dat <- sqlQuery(conndb, "select * from [query1]")上記例のquery1の他に同じレイアウトのクエリが数種類あり、(query2, query3,,,,,query11)、それらについても同様に読み込み、同じ処理を行いたいと思っています。

conndb <- odbcConnectAccess("Data.mdb") list <- c(query1, query2,,,,query11) for (i in list){ dat <- sqlQuery(conndb, "select * from [i]") ** datに対する処理 ** }のような感じでソースをかけるとよいと思ったのですが、上記のような書き方では動かないようでした。

どのようにすればよろしいのでしょうか?

conndb <- odbcConnectAccess("Data.mdb")

list <- 1:11

for (i in list){

tablename<-paste("query",i,sep="")

qtext<-paste("select * from ",tablename,sep="")

dat<-sqlQuery(conndb,qtext)

#** datに対する処理 **

}kum (2010-01-13 (水) 21:52:01)

失礼かと思いますが、わからない点があるので連続で投稿させていただきます。

例えばcsvファイルに100個のデータがあるとして、biplotで表すとそのまま100個のデータが示されますが、これを特定のデータ(最初の10個、途中の20個など)だけを表示するようにはできないのでしょうか?

ご教授ください。

> ans.prcomp <- prcomp(iris[,1:4]) # 例として iris データを使うと > suffix <- c(45, 6, 78, 90, 99, 113, 145) # 描画したい行(指定の難易度はさまざま) > biplot(ans.prcomp$x[suffix,], ans.prcomp$rotation, xlabs=suffix) # xlabs を使わないと通し番号になってしまう

> PC <- princomp(~A+B+C+D+E+F+G+H, cor=TRUE,data=X) > suffix <- c(2,3,4,5,6,7,8,9,10) > biplot(PC$x[suffix,], PC$rotation, xlabs=suffix)としたのですが「エラー dimnames(x) <- list(xlabs, dimnames(x)2L) : NULL に対して属性を設定しようとしました」と出てしまいました。prcompでなくprincompを使っていることがエラーの原因でしょうか? -- kum 2010-01-13 (水) 23:27:36

> suffix <- 2:10 > biplot(PC$scores[suffix,], PC$rotation, xlabs=suffix)としたところ「以下にエラー 1L:p : 引数の長さが0です」と出てしまいました。 -- kum 2010-01-14 (木) 00:42:13

> biplot(PC$scores[suffix,], PC$loadings, xlabs=suffix)と書いたところ表示できました。熱心にご教授くださって感謝します。 ・・・しかし、「biplot(PC$scores[suffix,], PC$loadings, xlabs=suffix)」で表示される範囲が「biplot(PC)」、つまり全データを示した図の中でどこにあるかがわかるのが望ましいのですが、そうすることはできないのでしょうか。 -- kum 2010-01-14 (木) 09:13:29

まず、元のプログラムを別の名前にコピーして

biplot2 <- stats:::biplot.default

プログラムを編集する

biplot2 <- edit(biplot2)

この後、編集ウインドウで以下の2か所を追加・変更

function (x, y, var.axes = TRUE, col, cex = rep(par("cex"), 2),

xlabs = NULL, ylabs = NULL, expand = 1, xlim = NULL, ylim = NULL,

arrow.len = 0.1, main = NULL, sub = NULL, xlab = NULL, ylab = NULL,

suffix=suffix, # 追加

:

# text(x, xlabs, cex = cex[1L], col = col[1L], ...) 変更

text(x[suffix,], xlabs[suffix], cex = cex[1L], col = col[1L], ...)

編集されたプログラムを保存する。

実際に関数を呼び出すのは以下のようにする。関数名、引数の指定の仕方に注意。

biplot2(PC$scores, PC$loadings, suffix=suffix)kum (2010-01-13 (水) 18:03:45)

初めまして,kumと申します。

研究で主成分分析を行うことになったのでRを導入し,結果も得ることができました。

そこで,biplot(PC)で描かれた図を保存してレジュメに貼ろうとしたのですが保存の仕方がわかりません。

このwikiの「R による EPS 画像の作成とその LATEX への取り込み」を参考に

Y <- biplot(PC) や Y <- PC として data(Y) としたとことろ「データセット 'Y' がありません」と 出てしまいました。

どなたか解決法をご教授ください。

parade (2010-01-13 (水) 17:44:36)

潜在特性モデル・項目反応理論のパッケージltmを使って、ある集団Aの反応データから、項目パラメータを出しました(2パラメータ)。

このパラメータを使って、別の集団Bの成員の能力値を推定したいのですが、どのようにすれば良いかご存じの方いらっしゃいますでしょうか。

また、初めに求めたパラメータのうちのいくつかだけを使って、別の集団の成員の能力値を推定する、という場合にはどのようにアレンジするかについても、お教えいただければ幸いです。

どうぞよろしくお願いいたします。

gomen (2010-01-11 (月) 16:47:33)

自由評価(0〜100点)のレビューサイトで、Aさん平均点60点で100作=計6000点と、Bさん平均点80点で75作=計6000点で同じになります。

ただし、この時の各作品の平均点の上昇に対する

影響力はBさんの方がAさんより凄く高くなります。

簡単に書くと、同じ審査員なのに影響力が凄く違うと不平等なので解消したい。

でも、処理方法をマスター出来そうに無いので誰か協力してください。

目的、本当の価値が知りたい。

自由点数だと平均点60の70点(少しおもしろいに相当する)と平均点80の70点(駄作)が同じになってしまうのです。そこで0〜101位に換算すれば、それがどのぐらいの価値なのかストレートに導き出せると言う事です。

(現実の差 平均点60で100作=計6000点と平均点80で100作=計8000点、この時の差2000点を平均点60に足すと100点満点の作品数を100作中で約50作も増加可能なのです。)

以下、理論

Aさんは平均点60点なので60点の作品というのは平凡な作品に相当します。

仮に推定順位50位とします。

Bさんは平均点80点なので80点の作品というのは平凡な作品に相当します。

同じく推定順位50位にするべきと思います。

後は最高点と最低点ですが、ABどちらにしても、それが推定順位での最高位と最低位に相当します。仮に推定順位1位と推定順位100位にします。

処理方法のルール

後は点数の書かれたボールを、その0〜50位の仮想ゲージと50〜101位の仮想ゲージに並べて、接点の順位を割り出して、最後に同点数の処理をすれば推定順位に変換完了となります。

(同様の分離により、32分割する事も可能と思いますが、補正が大変なのと、点数配分が極端な審査員に有利に働くので、最大の誤差である50位=個人の平均点のみとします。)

点数の種類が少ない時(5〜8個以下と思う)は0〜101位の仮想ゲージを使う。

点数の種類が1種類の時は50位にしかならないので無効とします。

使用データー

CSVファイルから、会員IDはあるけれど会員番号が振られて無い。

作品数1万ぐらい、会員数1.5万ぐらい、総カルテ数50万ぐらい

初心者 (2010-01-10 (日) 23:14:19)

「回数」が被説明変数になるデータをポアソン回帰と負の二項回帰で分析したいと考えております。Rを使ったこれらの分析方法をお教え願えませんでしょうか。できればRコマンダーでのやり方を教えていただけると大変ありがたいです。宜しくお願いします。

勉強中 (2010-01-07 (木) 18:00:10)

よろしくお願いします。

アンケートを実施して、結果をEXCELにまとめる際に、マルチアンサーを

1つのカラムに 「2,3,5」 のようにまとめているとします。

例えばid Q1 Q2 Q3 1 2 1,3,7,9,10 1 2 3 2,5 1 3 4 3 1 4 1 4,6 1 5 2 6,7 2 6 3 10 2 7 3 3,4 2 8 4 2,5,6,7,8,9 2 9 1 1,2,4 2 10 3 5,7 2こういった際に、Rでクロス集計は可能でしょうか?

まだアンケート実施前で、できればRでやりたいのですが、集計の期限が決まっているため、事前の可・不可を知っておきたいです。

R 2.9.2

windows XP sp3

よろしくお願いします。

Q2 <- data.frame(t(sapply(a$Q2, function(s) {

val <- numeric(10)

sufix <- as.integer(unlist(strsplit(as.character(s), ",")))

val[sufix] <- 1

return(val)

})))

実行後の Q2 は以下の通り

X1 X2 X3 X4 X5 X6 X7 X8 X9 X10

1 1 0 1 0 0 0 1 0 1 1

2 0 1 0 0 1 0 0 0 0 0

3 0 0 1 0 0 0 0 0 0 0

4 0 0 0 1 0 1 0 0 0 0

5 0 0 0 0 0 1 1 0 0 0

6 0 0 0 0 0 0 0 0 0 1

7 0 0 1 1 0 0 0 0 0 0

8 0 1 0 0 1 1 1 1 1 0

9 1 1 0 1 0 0 0 0 0 0

10 0 0 0 0 1 0 1 0 0 0Tiana (2010-01-05 (火) 17:39:26)

はじめまして,留学生のTianaです.

lm関数を使って重回帰解析を行っています.

質問の便宜上,以下の回帰式を使用させていただきます.

z=c+ax+by

ただし,zは応答変数,x,yは説明変数,a,b,cは回帰係数です.

lm(z〜x+y,data=dataset1)のようにすれば,dataset1に基づいた最適解(二乗誤差を最小にするようなa,b,c)が求まりますが,データセットが変われば最適解ではなくなります.

求めたいのは,各々のデータセットの最適解ではないかもしれませんが,複数のデータセットそれぞれの二乗誤差の和が最小になるようなa,b,cです.

この問題を解決する方法はどなたかご存知でしょうか?

日本語が下手で失礼な文面はあったかもしれませんが,教えていただければとても幸いです.

よろしくお願い致します.

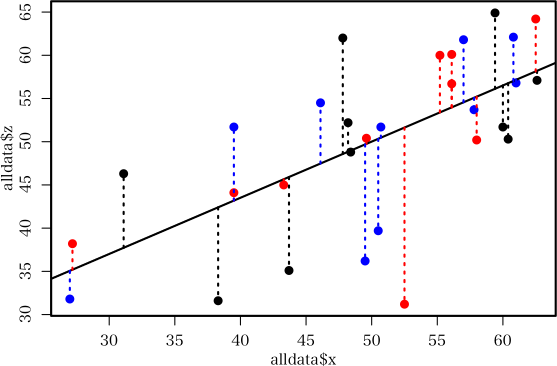

alldata <- rbind(dataset1, dataset2, dataset3) lm(z〜x+y,data=alldata)のようにする。

> # テストデータとして,このようなデータセットを作り

> data1 <- structure(list(x = c(47.8, 48.2, 62.6, 31.1, 43.7, 60, 38.3,

+ 48.4, 59.4, 60.4), y = c(65.5, 34.7, 57.5, 46.3, 46, 60.9, 34.9,

+ 50.3, 58.5, 45.4), z = c(62, 52.2, 57.1, 46.3, 35.1, 51.7, 31.6,

+ 48.8, 64.9, 50.3)), .Names = c("x", "y", "z"), row.names = c(NA,

+ -10L), class = "data.frame")

> #

> data2 <- structure(list(x = c(56.1, 43.3, 39.5, 52.5, 27.2, 55.2, 49.6,

+ 56.1, 62.5, 58), y = c(49.6, 46.8, 54.3, 38.4, 34.5, 66.3, 54.1,

+ 65.2, 49.9, 41), z = c(60.1, 45, 44.1, 31.2, 38.2, 60, 50.4,

+ 56.7, 64.2, 50.2)), .Names = c("x", "y", "z"), row.names = c(NA,

+ -10L), class = "data.frame")

> #

> data3 <- structure(list(x = c(50.5, 50.7, 60.8, 49.5, 46.1, 61, 27, 57.8,

+ 39.5, 57), y = c(60.4, 55.3, 58.1, 32.6, 62.3, 43.5, 33.9, 53.5,

+ 46.3, 54.1), z = c(39.7, 51.7, 62.1, 36.2, 54.5, 56.8, 31.8,

+ 53.7, 51.7, 61.8)), .Names = c("x", "y", "z"), row.names = c(NA,

+ -10L), class = "data.frame")

> #

> # 残差平方和の和を求めるために,このような関数を定義して

> func <- function(par)

+ {

+ c <- par[1]

+ a <- par[2]

+ b <- par[3]

+ return(sum(

+ (data1$z-c-a*data1$x-b*data1$y)^2+

+ (data2$z-c-a*data2$x-b*data2$y)^2+

+ (data3$z-c-a*data3$x-b*data3$y)^2

+ ))

+ }

> #

> # このように optim 関数を使えばば,解が求まります

> ans1 <- optim(c(1,1,1), func)

> options(digits=20)

> ans1$par # 順に,Intercept, a, b の値

[1] 5.1494284959399153 0.4486484068519486 0.4484184855761603

> #

> # 全部のデータを一緒にして lm をやるとちょっと違う解になります

> ans2 <- lm(z~x+y, rbind(data1, data2, data3))

> ans2$coefficients # 順に,Intercept, a, b の値

(Intercept) x y

5.1698189750573782 0.4486579549173459 0.4480422838232404

# しかし,違いが出るのは収束判定が甘いからというのが一つの原因

# 以下のようにすれば,全部のデータを一緒にして lm をやった場合の解に近づきます

> ans3 <- optim(c(1,1,1), func, control=list(reltol=1e-14))

> ans3$par

[1] 5.1698211304708774 0.4486577795757830 0.4480424597122442

図に描いてよく考えれば,別々のデータセットに同じ回帰平面をあてはめて誤差の平方和の和を最小にするのと,データセットをまとめて一つの回帰平面を当てはめたときの誤差平方和は同じものですよね。つまり,全部のデータセットを一緒にして,lm をやればそれがあなたが求めたい解になっているのだと思いますよ。

> data1 <- structure(c(60.7, 63.8, 62.8, 59.5, 50, 54.3, 50.2, 65.5, 82.9,

+ 118.2, 142.7, 101.8, 78.8, 51.7, 56.3, 90.1, 125.9, 166.8, 182.6,

+ 179, 134.6, 100.3, 69.1, 39.4, 31.2, 26.8, 26.8, 31.2, 31.2,

+ 31.2, 33.6, 36, 40.8, 47.6, 51.2, 42.7, 29.2, 32.4, 34.8, 41.6,

+ 50.8, 60.2, 67.8, 72.9, 60.4, 27.6, 34, 26.7, 21.3, 27.5, 23.3,

+ 23.8, 27.5, 25, 23.5, 27.8, 38.7, 33.9, 56.5, 21.5, 24.4, 22.9,

+ 25.2, 32.5, 29.2, 20.7, 37.1, 27.5, 19.3, 22, 14.6, 10.6), .Dim = c(24L,

+ 3L), .Dimnames = list(NULL, c("z", "x", "y")), .Tsp = c(1, 24,

+ 1), class = c("mts", "ts"))

>

> data2 <- structure(c(60.9, 43.5, 42, 55.3, 61.4, 61.4, 85.4, 113.6, 132,

+ 107.4, 79.8, 85.4, 74.2, 47.1, 66.5, 73.7, 98.7, 159.1, 154.5,

+ 128.9, 95.7, 65.5, 45, 34.8, 28.4, 28.4, 34.8, 37.6, 34.8, 34.4,

+ 45.6, 49.4, 51.2, 42.8, 46.4, 44, 29.2, 24.4, 24, 33.6, 43.2,

+ 62.7, 64.9, 40.4, 32.9, 14.8, 14, 18.4, 19.5, 18.1, 25.1, 19.2,

+ 22.4, 22.9, 20.1, 29.5, 46.2, 31.3, 33, 26.4, 23.9, 20.7, 10.8,

+ 13.7, 17.7, 34.3, 45.8, 38.2, 30.2, 20.4, 12.1, 9.1), .Dim = c(24L,

+ 3L), .Dimnames = list(NULL, c("z", "x", "y")), .Tsp = c(1, 24,

+ 1), class = c("mts", "ts"))

>

> data1

Time Series:

Start = 1

End = 24

Frequency = 1

z x y

1 60.7 31.2 21.3

2 63.8 26.8 27.5

3 62.8 26.8 23.3

略

23 69.1 34.0 14.6

24 39.4 26.7 10.6

>

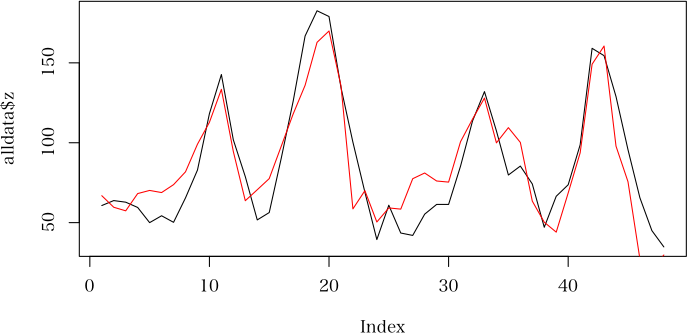

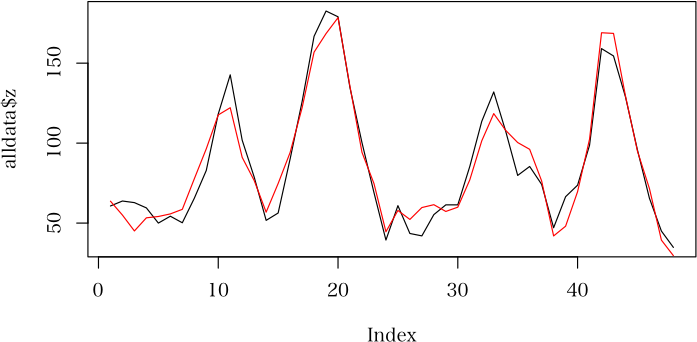

> alldata <- data.frame(rbind(data1, data2))

> ans.lm <- lm(z ~ x+y, alldata)

> plot(alldata$z, type="l")

> lines(fitted.values(ans.lm), col="red")

> summary(ans.lm)

Call:

lm(formula = z ~ x + y, data = alldata)

Residuals:

Min 1Q Median 3Q Max

-35.4932 -14.6937 0.3991 9.1139 41.6834

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -19.1196 8.7029 -2.197 0.0332 *

x 2.3930 0.2396 9.986 5.43e-13 ***

y 0.5314 0.3407 1.560 0.1259

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 18.07 on 45 degrees of freedom

Multiple R-squared: 0.7988, Adjusted R-squared: 0.7898

F-statistic: 89.32 on 2 and 45 DF, p-value: < 2.2e-16

d <- data.frame(diag(24)[,-1])

colnames(d) <- paste("H", 1:23, sep="")

alldata <- rbind(data.frame(data1, d), data.frame(data2, d))

ans.lm <- lm(z ~., alldata)

plot(alldata$z, type="l")

lines(fitted.values(ans.lm), col="red")

summary(ans.lm)

結果

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -1.6278 16.9593 -0.096 0.9244

x 1.6980 0.3435 4.943 6.05e-05 ***

y 0.5798 0.4462 1.299 0.2073

H1 -4.8058 14.1831 -0.339 0.7379

H2 -12.3011 14.2281 -0.865 0.3966

H3 -11.8486 14.2191 -0.833 0.4136

H4 -13.1716 14.3102 -0.920 0.3673

H5 -10.1022 14.2485 -0.709 0.4858

H6 -10.4521 14.5318 -0.719 0.4796

H7 2.0627 15.2537 0.135 0.8937

H8 6.3584 18.0933 0.351 0.7286

H9 18.7776 16.0356 1.171 0.2541

H10 4.0706 18.9812 0.214 0.8322

H11 7.7339 14.9545 0.517 0.6102

H12 14.5447 14.2227 1.023 0.3176

H13 -9.8345 14.1444 -0.695 0.4942

H14 2.6706 14.1637 0.189 0.8522

H15 6.2902 14.4251 0.436 0.6670

H16 20.5260 15.3697 1.335 0.1954

H17 44.2918 18.1046 2.446 0.0229 *

H18 33.4838 21.1097 1.586 0.1270

H19 40.3405 17.7626 2.271 0.0333 *

H20 23.2166 15.3865 1.509 0.1456

H21 36.2390 14.4325 2.511 0.0199 *

H22 10.1858 14.6057 0.697 0.4929

H23 -5.2729 15.0943 -0.349 0.7302

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 14.12 on 22 degrees of freedom

Multiple R-squared: 0.9399, Adjusted R-squared: 0.8717

F-statistic: 13.77 on 25 and 22 DF, p-value: 1.880e-08

ろんどん (2010-01-04 (月) 13:01:14)

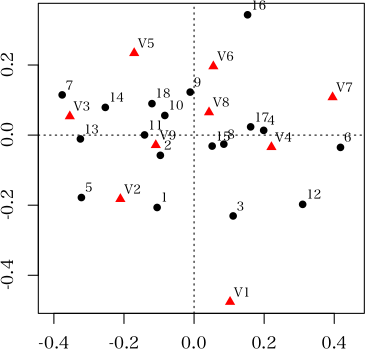

R 2.10.0にて対応分析をしようとしています。

エラーが出て、エラーの意味がよくわかりません。

エラーの意味と、対策方法を教えて頂きたく思います。

データは、9個の物に対して18の質問項目について答えてもらったデータです。以下の様なデータです。8 8 6 7 6 6 4 6 9 6 7 6 6 6 7 4 7 6 2 1 2 7 1 1 1 1 6 0 0 1 7 0 2 0 0 6 0 0 0 2 0 0 0 0 13 0 0 0 11 0 2 1 0 9 1 5 7 5 4 3 1 5 4 0 1 0 2 0 0 2 3 8 1 3 3 8 3 5 2 4 9 2 3 4 5 3 4 3 3 8 0 0 0 2 0 1 0 2 9 6 5 2 0 2 2 9 10 2 0 0 0 0 0 0 0 2 5 0 1 1 1 1 0 1 1 4 1 1 1 2 1 1 1 2 2 2 2 3 4 7 7 9 9 10 2 2 2 7 2 4 3 3 7 1 2 3 3 2 2 2 2 4

以下プログラムです。> library(ca) 要求されたパッケージ rgl をロード中です > w<-read.table("C:/deta1.txt") > Sdata<-matrix(0,18,9) > for(i in 1:18){Sdata[,i]<-w[,i]} 以下にエラー `[.data.frame`(w, , i) : undefined columns selected > cor<-ca(Sdata,9) > x<-matrix(0,27,18) > x[1:18,1:18]<-cor$rproj 以下にエラー x[1:18, 1:18] <- cor$rproj : 置き換えるべき項目数が,置き換える数の倍数ではありませんでした > x[19:27,1:18]<-cor$cproj 以下にエラー x[19:27, 1:18] <- cor$cproj : 置き換えるべき項目数が,置き換える数の倍数ではありませんでした > plot(x[,3],x[,4],type="n") > text(x[,3],x[,4],labels=c("A","B","C","D","E","F","G","H","I","J","K","L","M", "N","O","P","Q","R","1","2","3","4","5","6","7","8","9")) > abline(0,0,0,0)ご教授よろしくお願い致します。

library(ca)

w <- read.table("C:/deta1.txt")

Sdata <- w # 代入する意味はないと思うが

cor <- ca(Sdata, 9)

x <- rbind(cor$rowcoord, cor$colcoord)

plot(x[, 3], x[, 4], type="n")

text(x[, 3], x[, 4], labels=c(LETTERS[1:18], 1:9)) # ここはこういう風に書くほうがよい

abline(h=0, v=0) # 要するに座標軸を描きたかった?

また,ca の plotメソッドが使えるのだから,一番簡単にやりたかったら,plot(ca(w), c(3, 4)) だけで,添付のようなきれいな図が描けますよ。V1〜V9 は変数名,1〜18 は行名なので,自分でちゃんと定義すれば定義したとおりに図に描けますよ。? plot.ca でオンラインヘルプを読んでください。

MiK (2009-12-29 (火) 09:28:09)

Rを使ったバイオインフォマティクスに関する質問です、Rの質問でないと思われた方にはごめんなさい。

IPI(International Protein Index)のデータベース内のipi番号からそのタンパク質が持つドメインを検索しようとしています。ここでは簡単にするためにipi番号からドメインデータベースのpfamの番号を返すプログラムを作ることとします。

私の知っている範囲では、BiomRtパッケージの中からgetBMを使うことができます。例えば以下のように、getBM(attributes = c("ipi","pfam"), filters = "ipi", value="IPI00883220", mart=useMart("ensembl",dataset="ggallus_gene_ensembl"))この場合、

ipi pfam IPI00883220 PF04818という値が返ってきます。これはIPI00883220がipiと同時にensembleのデータベースにも存在するから正常に働きます。

しかし、たまに正常に働かないipi番号が存在します。

例えばvalue="IPI00883261"に変えて上記のプログラムを動かすとipi pfam IPI00883261 PF01111という値が期待されますが、実際には

[1] ipi pfam <0 rows> (or 0-length row.names)と返ってきてしまいます。

これは、IPI00883261がipiデータベースには存在するが、ensembleのデータベースには存在しないため正常に働かないと考ました。というのは、BiomRtはensembleのデータベースにアクセスして値を返しているからです。

そこで、この問題を回避するために直接ipiのデータベースを参照できる方法を知りたいと思っています。それを知っている方がいたらぜひご教授ください。よろしくお願いいたします。

> set.seed(11111)

> data.base <- data.frame( # データフレームの例(1万行)

+ ipi=sprintf("IPI%08i", sample(99999999, 10000)),

+ pfam=sprintf("PF%05i", sample(99999, 10000)))

> head(data.base) # こんな風な構造になっている(する)

ipi pfam

1 IPI50144832 PF35844

2 IPI97023278 PF04626

3 IPI78760034 PF42298

4 IPI90222583 PF08148

5 IPI81417775 PF11722

6 IPI79989218 PF66366

> ipi <- c("IPI43502178", "IPI55223826", "IPI46947973",

+ "IPI98703034", "IPI49743044") # 5 個の ipi コードに対する pfam コードを得る

> lapply(ipi, function(x) data.base[data.base[,1] == x,]) # これだけでよい。。。

[[1]]

ipi pfam

7733 IPI43502178 PF34214

[[2]]

ipi pfam

3813 IPI55223826 PF36706

[[3]]

ipi pfam

1138 IPI46947973 PF39932

[[4]]

ipi pfam

6900 IPI98703034 PF00650

[[5]]

ipi pfam

1835 IPI49743044 PF48089はぜ (2009-12-22 (火) 11:56:00)

初心者です。

投稿ミス等ありましたらご容赦ください。

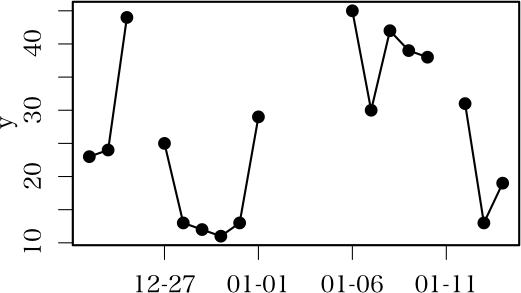

横軸に日付、縦軸に数量をとった折れ線グラフを作成しています。

とりあえずグラフはできたのですが、調査期間中毎日データをとっているわけではではないので、

データのない期間があると、その期間の前後の点が線で結ばれてしまい、本来データのない期間にも関わらずそこにデータがあるように見えてしまいます。

データのない期間は数量0として扱いたいのですが、どなたかいい方法をご存知でしょうか?

元データには、データのない日付は入力されていません。

OSはWindowsXP、Rヴァージョンは2.10.0です。

よろしくお願いします。

x <- structure(c(14601, 14602, 14603,

14605, 14606, 14607, 14608, 14609, 14610,

14615, 14616, 14617, 14618, 14619,

14621, 14622, 14623), class = "Date")

y <- c(23L, 24L, 44L, 25L, 13L, 12L, 11L, 13L, 29L,

45L, 30L, 42L, 39L, 38L, 31L, 13L, 19L)

plot(x, y, xaxt="n")

axis.Date(1, x, format="%m-%d")

for (i in 1:(length(x)-1)) {

if (x[i+1]-x[i] == 1) segments(x[i], y[i], x[i+1], y[i+1])

}

xx<-seq(min(x),max(x),"day") yy<-rep(NA,length(xx)) yy[xx%in%x]<-y plot(xx,yy,type="b") # 欠損値は線で結びません.で良いのです. -- 2009-12-22 (火) 13:01:47

ana <- d.sub[d.sub$SP== "a",]

ana.sub <- data.frame(tapply(ana$DATE, ana[, c("Date","DRCT")], length))

ana.sub[is.na(ana.sub)] <- 0

ana.sub$total <- ana.sub$d + ana.sub$u

ana.sub$DATE <- as.Date(rownames(ana.sub))

rownames(ana.sub) <- 1:nrow(ana.sub)

ana.sub$ID <- rownames(ana.sub)

cumulative.t <- c()

cum.t <- 0

for(i in 1:nrow(ana.sub)) {

d.sub <- ana.sub[ana.sub$ID == i,]

sub.t <- d.sub$total

cum.t <- cum.t + sub.t

cumulative.t <- c(cumulative.t, cum.t)

}

ana.sub$cum.t <- cumulative.t

plot(ana.sub$DATE, ana.sub$cum.t, col ="red", type ="l", lty = 2, lwd=2,

axes = FALSE,las =1,

xlim = c(as.Date("2009-08-01"), as.Date("2009-12-31")),

ylim = c(0, max(ana.sub$cum.t)*1.1),

ylab ="", main = "")

lines(ana.sub$DATE, ana.sub$total, col = "blue")

lines(ana.sub$DATE, ana.sub$d, col ="orange")

lines(ana.sub$DATE, ana.sub$u, col = "green")

axis(1, at = as.Date(v.date), labels = F, pos = 0)

axis(2, las = 1, pos = as.Date("2009-08-01")) -- [[はぜ]] &new{2009-12-22 (火) 14:10:42};> head(t) [1] "2009-08-01 05:20:30 JST" "2009-08-01 06:10:34 JST" "2009-08-01 07:23:30 JST" [4] "2009-08-01 10:50:19 JST" "2009-08-01 22:41:56 JST" "2009-08-02 07:09:01 JST"これを日付単位に何件であったか集計する。と。

d <- substr(t, 1, 10)それを table 関数で集計するだけ。では?

> table(d)

d

2009-08-01 2009-08-02 2009-08-04 2009-08-05 2009-08-08

5 6 5 4 3

以下略

あとは,先ほどのコメントにある方法で,table(d) を縦軸(頻度)として,折れ線グラフを描くだけでしょう。横軸は,names(table(d)) で取れます(観察のなかった日付は出てきません)。GYOU (2009-12-21 (月) 23:47:04)

こんにちは。

Rには行列を時計回りや反時計回りに回転する関数は無いのでしょうか?

例えば1 2 3 4という行列を時計回りに90度回転して

3 1 4 2という具合です。

過去ログを探しましたが、グラフの文字列を回転する話ばかりで、行列の回転は見当たりませんでした。自作するしか無いのでしょうか?

m <- matrix(1:16, 4, byrow=T)

n <- m

for(i in 1:ncol(m)){ n[i,] <- rev(m[,i]) }

for(i in 1:ncol(m)){ n[,i] <- rev(m[i,]) }ai (2009-12-14 (月) 23:45:42)

抽象的な質問で申し訳ありませんが,plot(ほにゃらら)とコマンドを入力すると,次の図を見るためには<Return>キーを押して下さい:と連続して表示される4つの図をepsに保存したいのですが,

par(mfrow=c(2, 2))を使っても,最初の図しか保存されません。

どうしたらすべての図,または,3番目といったひとつの図をepsに保存できますか?

x <- rnorm(100)

y <- rnorm(100)

a <- lm(y~x)

postscript("test%i.ps", width=300, height=200, onefile=FALSE)

plot(a)

dev.off()> x <- rnorm(100) > y <- rnorm(100) > a <- lm(y~x) > plot(a) ページ変更を確認するまで待機中... # Windows 版でも同じプロンプトだったと思うけど、 ページ変更を確認するまで待機中... # 変わったのだろうか ページ変更を確認するまで待機中... # スクリーン・デバイスの上に、 ページ変更を確認するまで待機中... # 「クリックまたはENTERキーを押すと次のページに移ります」と出てる > devAskNewPage() # FALSE なのに聞いてくる [1] FALSEいつから変わったのかな。 -- 河童の屁 2009-12-15 (火) 15:54:23

lemon (2009-12-14 (月) 13:44:20)

kesvmでplot(data.ksvm,data=x.cl[,1:2])の出力結果の意味が良く分かりません。

図の▲や●はデータを示すと思われるのですが、図の右側の濃淡がどのような意味を持っているのか分かりません。

説明が載っているところがあればお教え下さい。

TAK (2009-12-14 (月) 11:12:06)

R初心者です。

マザーズなどの上場企業のデータから、ダイナミックパネルデータ分析を行おうと思うのですが,以下のようなプログラミングでエラーが出てきてしまいます。何が原因なのか教えていただけないでしょうか?よろしくお願いいたします。

元データ(サービス.txt)firm yr ROE PCM 対数資産合計 対数売上高合計 流動比率 負債比率 自己資本比率 無形資産比率 ジャスダック マザーズ ヘラクレス 2003 2004 2005 2006 2007 2008 4 2005 8.14 0.826719577 2.894869657 3.480581787 158.13 146.08 40.64 0.25477707 1 0 0 0 0 1 0 0 0 4 2007 20.76 2.829175122 3.47070443 3.923088515 205.42 83.72 54.41 0.50744249 1 0 0 0 0 0 0 1 0 4 2004 37.79 3.044496487 2.85672889 3.329397879 170.66 143.73 41.09 0.139082058 1 0 0 0 1 0 0 0 0 4 2006 38.67 3.814822174 3.197556213 3.70182693 159.65 133.83 42.77 0.57106599 1 0 0 0 0 0 1 0 0 5 2008 5.2 2.394227616 3.875697762 3.484157424 111.38 421.96 15.49 0.013313806 1 0 0 0 0 0 0 0 1プログラム

library(plm) SA <- read.table("サービス.txt", header=T) SA <- plm.data(SA, index=c("firm", "yr")) attach(SA) form1 <- ROE~対数資産合計+対数売上高合計+流動比率+負債比率+自己資本比率+無形資産比率 emp.gmmSA = pgmm(dynformula(form1, lag=list(1,0,0,0,0,0,0)), data=SA, effect="twoways", model="twosteps", gmm.inst=~ROE,lag.gmm=c(2,99))表示されるエラー

以下にエラー FUN(X[[4L]], ...) : 添え字が許される範囲外です。

出口 (2009-12-10 (木) 19:32:48)

1ファイル内に47都道府県別のデータが混在しているものを、それぞれのエリア別(都道府県)に分けたく、以下のようなプログラムを記述しましたが、for構文の利用の仕方が違っているため、ファイル分割できません。

下記のプログラムですと、ToDohFuKenが47のものだけが、x.iのデータフレームとして作成されます。for ( i in 1:47) { x.i<- subset(Gr.Area, ToDohFuKen==i) # Gr.Areaは、作業するもののデータフレーム # ToDohFuKenは、Gr.Areaデータフレーム内に存在する変数名 }期待する成果としては、X1、X2、X3、・・・X47と、47のデータフレームができあがることですが、ご教授いただけないでしょうか?

(Gr.Area <- data.frame(x1=rnorm(47), x2=rnorm(47), ToDohFuKen=1:47))

(d <- split(Gr.Area, Gr.Area$ToDohFuKen))

どうしても x1, x2, ... のようにしたければ

for ( i in 1:47) {

eval(parse(text=sprintf("x%i<- subset(Gr.Area, ToDohFuKen==i)", i)))

}

一行でやるなら

eval(parse(text=sprintf("x%i<- subset(Gr.Area, ToDohFuKen==%i)", 1:47, 1:47)))迷える黒い羊 (2009-12-10 (木) 17:59:04)

たぶん初歩的な問題(データ上の問題)だとは思うのですが、manovaの計算の際、下記のエラーが出ます。

エラーの意味をご教授願えませんでしょうか?以下にエラー `contrasts<-`(`*tmp*`, value = "contr.Treatment") : 関数 "is" を見つけることができませんでした

> attach(all_lda)

> all_lda_ma<-manova(cbind(A,B)~species)

以下にエラー `contrasts<-`(`*tmp*`, value = "contr.Treatment") :

関数 "is" を見つけることができませんでしたset.seed(11111)

all_lda <- data.frame(A=rnorm(83), B=rnorm(83),

species=rep(factor(c("n", "p")), c(61, 22)))

attach(all_lda)

all_lda_ma <- manova(cbind(A, B) ~ species)

summary(all_lda_ma)

detach(all_lda)

以下のような結果が表示されると思うんですけど

Df Pillai approx F num Df den Df Pr(>F)

species 1 0.019969 0.81504 2 80 0.4463

Residuals 81> is エラー: オブジェクト 'is' がありません

R初心者 (2009-12-10 (木) 10:09:13)

R初心者です。

Rで「組合せの数」を求める関数かパッケージをご教示ください。

Excelのcombin関数に相当するものがありますでしょうか。

数学記号でnCr(n:総数,r:抜き取り数)と表示されるものです。

どうぞ,よろしくお願いします。

sakura (2009-12-10 (木) 06:32:15)

素朴な初心者質問です。具体的でなくて済みません。平均値に相乗平均を使うRのパッケージ(ライブラリー)って、あるのかなぁ??ということと、もし使うとするとどんな手順(組み込ませ方)があるのでしょう???という質問のですが・・・。よろしくお願いします。

geomean <- function(x, ...) exp(mean(log(x), ...)) 使用例 > geomean(c(2,6,3,9)) [1] 4.242641 > geomean(c(1,2,3, NA), na.rm=TRUE) [1] 1.817121

takahashi (2009-12-09 (水) 21:02:16)

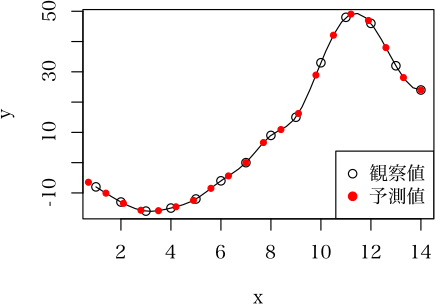

初心者です。よろしくお願いします。

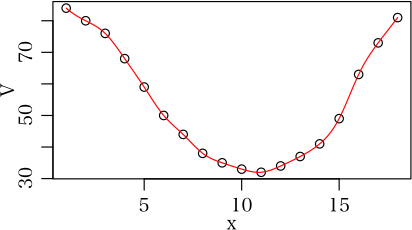

例えばx <- c(1:14) y <- c(-8, -13, -16, -15, -12, -6, 0, 9, 15, 33, 48, 46, 32, 24)と言った、曲線(に近いデータ)があったとします。

この曲線で、xが0から14までを20等分された値、つまりx0 = 0, x1= 0.7, x2 = 0.14, x3= 0.35・・・からx20 = 14の時のそれぞれのyの値(y0, y1, y2, y3, ・・・y20)を得るにはどうしたら良いでしょうか。

医学の循環器の研究で、各心拍の長さがことなることと、データを得る機器によって、1秒間あたりのフレーム数が異なるため、得られたデータを何等分かし、時相を一致させる必要があるため、この様な処理が必要となりました。

またデータの曲線は、関数で表せないものが多いです。

凄く単純なことに思えますが、どうしても良いプログラムができません。よろしくお願いします。

x <- 1:14

y <- c(-8, -13, -16, -15, -12, -6,

0, 9, 15, 33, 48, 46, 32, 24)

ans <- spline(x, y)

ans2 <- spline(x, y,

xout=seq(0, 14, length=21))

plot(x, y)

lines(ans$x, ans$y)

points(ans2$x, ans2$y, pch=19,

col=2, cex=0.7)

legend("bottomright",

c("観察値", "予測値"),

pch=c(1,19), col=c("black", "red"))

のざわ (2009-12-09 (水) 01:10:31)

お世話になります。

R-2.10.0でOSはopensolaris2009.06です。

以下のようなプログラムを作り実行させるとError in unserialize(node$con) : error reading from connectionと、こんなエラーが帰ってきて、並列計算できません。

何が悪いのでしょうか?library(snow) cl <- makeCluster(4, type = "SOCK") test.p <- function(a,b) { return((a+b)) } clusterExport(cl, "test.p")

はぜ (2009-12-08 (火) 16:32:16)

R始めたばかりです。

excelで作ったデータシートをcsv形式に変換させてread.csv("ファイル名")で読ませたのですが、なぜかデータ(数値、日付、文字列)の一部がNAになってしまいます。

元のexcelファイル、csvファイルとも調べましたが空白にしているセルはありません。

nrow("ファイル名")で行数を調べたところ、行数が実際のデータ数より多いので、データの一部がNA化するだけでなく、データが全く入力されていない末尾の空白行何行かもNAとして認識しているようです。

OSはWindowsXP、Rヴァージョンは2.10.0です。

どなたか解決策をご存知でしたらよろしくお願いします。

mako (2009-12-08 (火) 14:15:32)

いつも参考にさせていただいています。

現在、ニューラルネットパッケージnnetの関数(nnet)を用いてニューラルネット構造(重み)を学習し、その構造(重み)を用いて別の環境(fortran等)で再現したいと考えています。

nnetを用いて学習はできるのですが、出力される重みwtsの構造がわからなくて困っています。入力層が1、中間層が4、出力層が1(例えば以下の例)の場合、重みwtsは13個作成されますが、、どういう順番(どこの接続)の値なのでしょうか?(そもそもなぜ13個になる?4(入力と中間)+4(中間と出力)+1(出力?)=9では?)P <- matrix(sample(seq(-1,1,length=100), 100, replace=FALSE), ncol=1) target <- P^2 result <- nnet(P, target, size=4, maxit=100) y <- predict(result, P) plot(P,y, col="blue", pch="+") points(P,target, col="red", pch="x")また、WEKAによるニューラルネットワーク機能で描けるようなネットワーク構造を描画するパッケージがあるでしょうか?

ヘルプやリファレンス等調べましたが見つけられませんでした。

このような質問をするところではないかも知れませんが、ご存知の方がおられたら助けてください。よろしくお願いいたします。

> summary(result) a 1-4-1 network with 13 weights options were - b->h1 i1->h1 7.08 -7.27 b->h2 i1->h2 -1.15 -6.52 b->h3 i1->h3 7.54 7.06 b->h4 i1->h4 1.85 -8.71 b->o h1->o h2->o h3->o h4->o 14.84 -6.58 6.52 -9.10 -6.20 > result$wts [1] 7.081986 -7.272869 -1.148621 -6.524123 7.536072 7.062696 [7] 1.854337 -8.707560 14.843569 -6.577558 6.517180 -9.097420 [13] -6.203486

Saito (2009-12-07 (月) 21:57:38)

いつもお世話になっております。

色々と調べ、試行錯誤しましたが、上手くできないので質問させてください。

あるプログラムを走らせていて、ある時間が経過しても終了しない場合、それを終了させるにはどのようにすればよいでしょうか?

自分ではstopifnot()、proc.time()、breakを上手く使えばよいのかな、と思ったのですが、上手くいきません。例えばstopifnot(rnorm(1e+07) proc.time()[3] > 1)のような感じで、rnormに1秒以上かかるようなら、プログラムを中断させたいのですが…。ただ、proc.timeもRを起動してからの時間ですので、少し工夫がいるとは思うのですが…。

もしどなたか方法をご存知でしたら、ご教授願えないでしょうか?

> system.time(rnorm(1e8))[1] user.self 20.63くらいかかるようです。この状況で上記のコードを試すと、1秒を超えても計算が中断されません。きっちり20秒程度計算しているようです。

prog <- function()

{

s <- proc.time()[3]

repeat {

if (proc.time()[3]-s > 10) return(rnorm(100))

}

}

prog()修士論文執筆中 (2009-12-06 (日) 12:53:08)

はじめまして.修士論文執筆中と申します.

ある時からRの32bitバージョンが起動しなくなってしまいました.

私はマックブックで OS X ver.10.6.2,CPUは2.4GHz Intel Core 2 Duo,メモリは2GB,という状況で使っています.

本来ならば32bitでしか起動しないはずですし,こないだまでそうだったのですが,ある時から急に64bitでしか起動しなくなってしまいました.

Rcmdrをインストールしようにもbitがあわないからか全く起動せず非常に困っています.

ちなみにR64bitからは次のようなデータを得られました.

sessionInfo()

R version 2.10.0 (2009-10-26)

x86_64-apple-darwin9.8.0

locale:

[1] ja_JP.UTF-8/ja_JP.UTF-8/C/C/ja_JP.UTF-8/ja_JP.UTF-8

attached base packages:

[1] stats graphics grDevices utils datasets methods base

どうすれば32bitで起動するようになるでしょうか?

アドバイスをお願いいたします.

Mac OS X GUI Version Build Download Mac OS X GUI rev. 5528 for R 2.10.x tiger-Deployment R-GUI-5528-2.10-tiger-Deployment.dmg Mac OS X GUI rev. 5528 for R 2.11.x tiger-Deployment R-GUI-5528-2.11-tiger-Deployment.dmg Mac OS X GUI rev. 5528 for R 2.10.x leopard-Leopard R-GUI-5528-2.10-leopard-Leopard.dmg Mac OS X GUI rev. 5528 for R 2.10.x leopard-Leopard64 R-GUI-5528-2.10-leopard-Leopard64.dmg Mac OS X GUI rev. 5528 for R 2.11.x leopard-Leopard R-GUI-5528-2.11-leopard-Leopard.dmg Mac OS X GUI rev. 5528 for R 2.11.x leopard-Leopard64 R-GUI-5528-2.11-leopard-Leopard64.dmg

悩みの多い熊五郎 (2009-12-05 (土) 21:51:34)

修理受付データを分析して、解約を減らす方法を検討しています。修理には多くの部品が使われております。高額でもお客様は納得されれば修理しますし、安価でも解約になるケースがあり、どの部品が修理部材に使われると解約につながるのかを統計的に調べたいと思っています。Rをつかって、どの部品が交換されると解約される可能性が高いなのでの分析をすることが出来るのでしょうか?交換する部品は1個以上で、修理案件ごとに個数が異なります。

データとしては以下のようなデータが集計されています。修理受付No 部品1 部品2 部品3 部品4 部品5 修理価格 修理解約 001 PartA PartB 1000 修理 002 PartA PartZ PartC 4500 修理 003 PartV PartA PartB 3000 解約 004 PartD PartS PartB 6000 解約 ・・・・・・・・・・・・・・・・・・・・・・・・・・・・・・・・・ 999 PartZ 8000 修理この調査をし対策をしたいと考えております。アドバイスをお願いします。

修理受付No PartsA PartsB PartsC ... PartsZ 修理価格 修理解約 001 1 1 0 ... 0 1000 修理 002 1 0 1 ... 1 4500 修理 003 1 1 0 ... 0 3000 解約 004 0 1 0 ... 0 6000 解約 : 999 0 0 0 ... 1 8000 修理また,修理か解約かはどのパーツが使われたかだけに依存しているとも思えません(修理日数とか担当者の親切さとかなんとかにも関係する)ので,そのあたりのデータも集めておく方が良いでしょう。

sibu (2009-12-03 (木) 17:11:21)

こんにちは、私はネットワーク分析でテキストマイニングを行っているものなのですが。

テキストデータを形態素解析し、MLTPを用いて名詞に限定してbigramを求め、その結果を整形しネットワークマップ図にしようとこころ見たのですが。> at<-read.csv("c:/temp/a.csv",head=FALSE) Warning message: In read.table(file = file, header = header, sep = sep, quote = quote, : 'c:/temp/a.csv' の readTableHeader で不完全な最終行が見つかりましたというエラーが出てしまい、データを出力しようとしても

> at[1:30,] [1] ミマ\021爍ア <NA> <NA> <NA> <NA> <NA> <NA> [8] <NA> <NA> <NA> <NA> <NA> <NA> <NA> [15] <NA> <NA> <NA> <NA> <NA> <NA> <NA> [22] <NA> <NA> <NA> <NA> <NA> <NA> <NA> [29] <NA> <NA>という風になり、データを解析できません

なぜこのようなエラーが出るのでしょうか? ご意見お聞かせください、お願いします。

Saito (2009-12-01 (火) 17:53:41)

いつもお世話になっています。

過去の投稿、ネットを確認しましたが、見当たらなかったので質問させてください。

例えばlibrary(lattice) contourplot(volcano)で表示される四方の軸の目盛りを内側表示したいのですが、どのようにすればよいでしょうか。

plotであれば、plot(1, 1, tcl=0.5)とでもすればできるのですが。contourplotがやっている描画方法がよくわからず、うまく解決できませんでした。どなたか方法をご存知の方がいましたらご教授願えないでしょうか。

ちなみにR-2.9.2、WindowsXPです。

どうぞよろしくお願い致します。

おむすび (2009-11-30 (月) 21:26:10)

行列をつくって,それぞれの値を順番に置き換えたいのですが,どうしたらいいでしょう。m<-matrix(c(2, 5, 1, 5, 10, 2, 10, 20, 5),nrow=3)たとえば,rankでやると,

m2<-matrix(rank(m),nrow=3)これを1から7にしたいのです。

ついでに,orderだと順番が違うのはなぜですか?

> m2

[,1] [,2] [,3]

[1,] 2 3 4

[2,] 3 4 5

[3,] 1 2 3

1から5でした。すみません。 -- おむすび 2009-11-30 (月) 22:07:31> order(c(4,2,1,5,3)) [1] 3 2 5 1 4という例を考察すればよいでしょう。一番小さい1は3番目,2番目に小さい2は2番目,3番目に小さい3は5番目,4番目に小さい4は1番目,5番目に小さい(一番大きい)5は4番目ということ。

> x <- c(1,2,2,3,3,3,3,4,5) > rank(x, ties.method="average") # これが,デフォルト(平均順位) [1] 1.0 2.5 2.5 5.5 5.5 5.5 5.5 8.0 9.0 > rank(x, ties.method="first") [1] 1 2 3 4 5 6 7 8 9 > rank(x, ties.method="random") [1] 1 2 3 4 7 5 6 8 9 > rank(x, ties.method="max") [1] 1 3 3 7 7 7 7 8 9 > rank(x, ties.method="min") # これが世間でよく行われる方法? [1] 1 2 2 4 4 4 4 8 9とにかく,オンラインヘルプをよくお読みになることをおすすめします。

> m2

[,1] [,2] [,3]

[1,] 2 3 4

[2,] 3 4 5

[3,] 1 2 3

こんなのになりませんか? -- おむすび 2009-11-30 (月) 22:29:53> m <- matrix(c(2, 5, 1, 5, 10, 2, 10, 20, 5), nrow=3)

> values <- as.numeric(names(table(m)))

> m2 <- m

> for (i in 1:length(values)) {

+ m2[m2 == values[i]] <- i

+ }

> m2

[,1] [,2] [,3]

[1,] 2 3 4

[2,] 3 4 5

[3,] 1 2 3kobayashi (2009-11-29 (日) 22:19:04)

以下のようにデータを作り、エクセルのシリアル値であるDay(今回は例として適当に定義)を日付データ(newDay)にしてx軸をプロットします。Day <- c(33000, 36000, 39000) Value1 <- 1:3 Value2 <- 4:6 x <- data.frame(Value1, Value2) newDay <- as.Date(Day, origin="1900/01/01") plot(newDay, x[, 1], type="l") matplot(newDay, x[, 1], type="l") > x Value1 Value2 1 1 4 2 2 5 3 3 6 > newDay [1] "1990-05-09" "1998-07-26" "2006-10-12"すると、plotではx軸は日付データになってくれるのですが、matplotではx軸が変な値になってしまいます。(変換前のシリアル値にもなっていません)

原因及び解決方法を教えていただけないでしょうか。

matplot(newDay, x[, 1], type="l", xaxt="n") axis(1, at=newDay, label=as.Date(newDay, origin="1970/01/01")) # 単に,axis(1, at=newDay, label=newDay) でよいようだ。。。

sisisi (2009-11-25 (水) 10:20:58)

始めまして、私はテキストマイニングについて勉強しているものです。

最近は大学の講義データの講師の音声データと授業のスライドデータをテキスト化したものをテキストマイニングしようとしていますが、なかなか思うようにデータが集まりません。

このような異なる二つのデータをテキストを分析するときはどのような分析方法がよいのでしょうか?

どうかご意見お聞かせ下さい。

kao (2009-11-24 (火) 15:00:05)

Rで、soft independent modeling of class analogy(SIMCA)分析を行いたいです。

パッケージがあるのであれば、教えていただけないでしょうか。

よろしくお願いします。

tsuyoshi (2009-11-21 (土) 18:25:42)

初心者です

Rで、トランスログ生産関数分析をしたいです。

どなたかご存知でしたら教えていただけると幸いです。

柳沢 (2009-11-20 (金) 03:16:30)

こんにちは.windows で R 2.9.0 を使っています.

例えば plot(c(1,22)) を描いたとします.そのとき y-axis の 5, 10, 15, 20 のところに tick mark が現れます. この tick mark を傾けることは可能ですか? それが「良いグラフィックス」かどうかは別問題としてください.

plot(c(1,22), yaxt='n') text(rep(1,length(z<-axTicks(2))), z, '|', srt=-45)

が一番求めるものに近いのですが,xaxs='i' としない場合, 上記の text の中の x軸の値がいくつになるのかが分かりません.

どうぞよろしくお願いします.

plot(c(1,22), yaxt='n')

axis(2,tick=F)

par(xpd=T)

text(rep(par()$usr[1]-strwidth("|"),length(axTicks(2))),axTicks(2),"|",srt=45)

par(xpd=F)

こんな感じは参考になるかも -- 2009-11-20 (金) 11:15:52R初心者 (2009-11-18 (水) 00:58:33)

as.Date("2009-11-1")の1ヶ月後や2ヶ月後をRで計算できないものでしょうか?

1日後だったら、as.Date("2009-11-1")+1で簡単に計算できるのですが、1ヶ月後は

tail(seq(as.Date("2008-1-1"), len=2, by="1 month"), 1)

しか思いつかなかったので、質問させていただきました。

この方法だと、as.Dateの部分が日付のベクトルだとうまくいかなくなります。

何か良い方法があれば教えていただければと存じます。

> test <- function(str)

+ {

+ str2 <- tail(seq(as.Date(str), len=2, by="1 month"), 1)

+ cat(sprintf("%s %i\n", str2, difftime(as.Date(str2), as.Date(str))))

+ }

> test("2009-01-01")

2009-02-01 31

> test("2009-01-31") # 一ヶ月後は31日後になっている

2009-03-03 31

> test("2009-02-01") # 一ヶ月後は28日後になっており,

2009-03-01 28 # 2月になっての一ヶ月後は1月最終日からの一ヶ月後より早い

日付にベクトルを与えられないというのは本質的なものではなくて,以下のように対処すればよいだけでしょう。

> func <- function(str)

+ {

+ sapply(str, function(str2) as.character(seq(as.Date(str2), len=2, by="1 month")[2]))

+ }

> func(c("2009-01-01", "2009-01-31", "2009-02-01"))

2009-01-01 2009-01-31 2009-02-01

"2009-02-01" "2009-03-03" "2009-03-01"

あるいは,as.POSIXct を使うと,引数がベクトルの場合でも指定日数後の日付を得ることができます。

> as.POSIXct(c("2009-01-01", "2009-02-01"))+60*60*24*30

[1] "2009-01-31 JST" "2009-03-03 JST"aoi (2009-11-17 (火) 17:35:07)

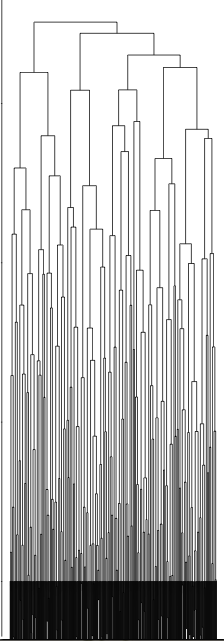

いつも丁寧に教えてくださり、本当にありがとうございます。

実験データをもとにしてヒートマップとデンドログラムを書いています。大変単純な質問で恐縮なのですが、距離をユークリッドやマンハッタンではなくコサイン距離で書いてみたいと思っていて、一応は書くことができたのですが、デンドログラムが細かく分かれすぎてしまい、分岐の最後までpdfにしても書くことが出来ません。(heatmapにしてもhclustでplclustにしても同様です。)

heatmap 関数のmargins=c(5,5)も変更してみたり、pdfのサイズを大きくしたりしているのですがうまくいきません。もっと最後の分岐まで書きたいです(現状では長過ぎて裏返ってしまっています)良い方法がありましたら、教えていただければと思います。

ちなみにコサイン距離の関数は

http://rbloger.blog51.fc2.com/blog-entry-26.html

より利用させていただきcosine.function <- function(x) { # 列ベクトルのコサイン距離の計算 col.similarity <- matrix(NA, ncol=ncol(x), nrow=ncol(x)) # コサイン距離を格納する行列 for (i in 1:ncol(x)) { for (j in 1:ncol(x)) { # コサイン距離の算出 col.similarity[i, j] <- (x[, i] %*% x[, j])/(sqrt(sum(x[, i]^2))*sqrt(sum(x[, j]^2))) } } rownames(col.similarity) <- colnames(x) # 列名の付与 colnames(col.similarity) <- colnames(x) # 行名の付与 return(col.similarity) # コサイン距離の行列を返す }転置してheatmapの関数に組み込むようにheatmap関数を変更しています。

また> sessionInfo() R version 2.8.1 (2008-12-22) i386-apple-darwin8.11.1です。よろしくお願いします。

Answer1 Answer2 Answer3 A 1 2 3 B 5 10 15 C 89 135 78 D 26 49 42 E 36 70 30 F 167 216 144 G 125 143 89 H 145 229 1110 I 13 5 11 J 58 61 49 K 77 91 25といったようなデータでこれでA,B,C・・・に当たる物が糖鎖で Answer1,Answer2・・・に当たる物がサンプルでこれが400行、300列くらいあります。

set.seed(123456789)

x <- matrix(sample(0:1, 400*300, replace=TRUE), 400) # 400行,300列のデータファイル

pdf("dendrogram.pdf", width=150, height=6) # width, height を適当に設定(詰まっていれば大きく)

plot(hclust(as.dist(cosine.function(x))), hang=-1)

dev.off()

x <- read.table("mixmix.txt", header=TRUE, sep="\t")

pdf("dendrogram2.pdf", width=100, height=5)

plot(hclust(as.dist(cosine.function(t(x[,-1])))), hang=-1)

dev.off()

なお,蛇足ではあるが,ブログから参照したという関数は無駄が多いというか稚拙なプログラムなので,以下のようにした方が300倍ほど速い。

> cosine.function2 <- function(x)

+ {

+ x <- as.matrix(x)

+ ss <- 1/sqrt(colSums(x^2))

+ col.similarity <- t(x) %*% x*outer(ss, ss)

+ colnames(col.similarity) <- rownames(col.similarity) <- colnames(x)

+ return(col.similarity)

+ }

> system.time(a1 <- cosine.function(t(x[,-1]))) # 二重の for ループを使っているので遅い!

ユーザ システム 経過

14.962 0.070 14.894

> system.time(a2 <- cosine.function2(t(x[,-1]))) # 圧倒的な速度

ユーザ システム 経過

0.046 0.002 0.048

> all.equal(a1, a2) # 言うまでもないが,同じ結果

[1] TRUEb.b. (2009-11-17 (火) 14:49:43)

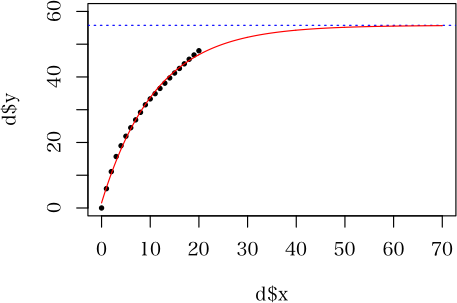

Height ~ SI * (1 + exp (8.285 -1.22 * log(60 + 16.195) - log(SI))) / (1 + exp(8.285 -1.22 * log(Age + 16.195) - log(SI)))という非線形関数で、AgeとHeightが分かっている場合に、SIの値を求める方法を知りたいのですが、どのようにすればよいのでしょうか。

> root <- function(Height, Age) {

+ uniroot(function(SI) SI * (1 + exp(8.285 -1.22 * log(60 + 16.195) - log(SI))) /

+ (1 + exp(8.285 -1.22 * log(Age + 16.195) - log(SI))) -

+ Height, c(0.01, 1e10))

+ }

> root(8.889316, 50)

$root # これが答え

[1] 10

$f.root

[1] -1.202766e-08

$iter

[1] 5

$estim.prec

[1] 6.103516e-05

Height, Age, SI のうちの任意の 2 変数の値を与えれば,残りの 1 変数の値を求めることができるようにするには,stats パッケージの power.t.test などに参考になるプログラム例があります。 -- 今日は寒いぞ河童の屁 2009-11-17 (火) 16:01:29

> root <- function(Height=NULL, Age=NULL, SI=NULL) {

+ Height.function <- quote(SI * (1 + exp(8.285 -1.22 * log(60 + 16.195) - log(SI))) /

+ (1 + exp(8.285 -1.22 * log(Age + 16.195) - log(SI))))

+ if (sum(sapply(list(Height, Age, SI), is.null)) != 1) stop("NULL は 1 変数のみ")

+ if (is.null(Height)) {

+ Height <- eval(Height.function)

+ }

+ else if (is.null(Age)) {

+ Age <- uniroot(function(Age) eval(Height.function)-Height, c(1, 1000))$root

+ }

+ else if (is.null(SI)) {

+ SI <- uniroot(function(SI) eval(Height.function)-Height, c(0.01, 1e10))$root

+ }

+ return(c(Height=Height, Age=Age, SI=SI))

+ }

> root(Height=8.889316, Age=50) # SI を求める

Height Age SI

8.889316 50.000000 10.000000

> root(SI=10, Age=50) # Height を求める

Height Age SI

8.889316 50.000000 10.000000

> root(Height=8.889316, SI=10) # Age を求める

Height Age SI

8.889316 50.000013 10.000000 akira (2009-11-16 (月) 21:34:21)

library(survival)のcoxphで作成したモデルを使ってpredict.coxphで生存期間を予測したいと思うのですが、type="expected"を出力する方法が分からず、困っています.基本的なことなのでしょうが、教えていただけるとうれしいです> fit <- coxph(Surv(time, status) ~ age + ph.ecog + strata(inst), lung) #このモデルを使って > head(lung) inst time status age sex ph.ecog ph.karno pat.karno meal.cal wt.loss 1 3 306 2 74 1 1 90 100 1175 NA 2 3 455 2 68 1 0 90 90 1225 15 3 3 1010 1 56 1 0 90 90 NA 15 4 5 210 2 57 1 1 90 60 1150 11 5 1 883 2 60 1 0 100 90 NA 0 6 12 1022 1 74 1 1 50 80 513 0 > predict(fit,type="lp") #これは線形回帰の係数と思ってます > predict(fit,type="expected") #これはモデルに使ったデータを回帰した生存期間ですよね? > predict(fit,newdata=lung[1,]) #これはtype="lp"を返しますが... # predict(fit,newdata=lung[1,],type="expected") #生存期間は返してくれないtype="lp"からリスクスコアは出せると思うのですが、log h(t) = a + b1x1 + b2x2 + ... + bnxn の時間tは出せないものでしょうか?

そもそも、理解を間違っているのでしょうか?

type: the type of predicted value.

Choices are the linear predictor ("lp"),

the risk score exp(lp) ("risk"),

the expected number of events given the covariates and follow-up time ("expected"),

and the terms of the linear predictor ("terms").# lungのinst==1だけで動作を理解してみました.

x <- subset(lung,subset=inst==1,select=c("time","status","age","ph.ecog"))

cxfit <- coxph(Surv(time, status) ~ age + ph.ecog,x) # Coxモデルを作る

all(exp(predict(cxfit,type="lp")) == predict(cxfit,type="risk")) # log(lp) = riskのこと

predict(cxfit,type="terms") # log h(t) = a + b1x1 + b2x2 の b1x1 と b2x2 の項

predict(cxfit,type="expected") # ここの返り値で思考が止まってしまいます.

ヘルプの「the expected number of events given the covariates and follow-up time (‘"expected"’)」を見てtype="exprected"はeventの数は時間tにおけるstatusを返すと思い込んでいました… ← ここが分かっていない# で、predict.coxphで1つ目のデータを推定してみました. y <- x[1,] predict(cxfit,y,type="lp"); predict(cxfit,type="lp")[1] #ほぼ同じ値 # predict(cxfit,y,type="risk"); predict(cxfit,type="risk")[1] #これもほぼ同じ値 predict(cxfit,y,type="terms"); predict(cxfit,type="terms")[1,] #これもほぼ同じ値 # predict.coxphはlp, risk, termをそれぞれ推定することは理解できましたCox比例ハザードはlog h(t) = a + b1x1 + b2x2 + ... + bnxn だから時間tに依存せずにlog h(t)が出るんですよね…そうすると、生存期間を臨床情報で多重回帰した式から生存期間は求められないような気がしてきました…どうでしょうか?-- akira 2009-11-17 (火) 09:20:11

library(survival)

x <- subset(lung,subset=inst==1,select=c("time","status","age","ph.ecog"))

y <- x[1,]

cxfit <- coxph(Surv(time, status==1) ~ age + ph.ecog,x) # Coxモデルを作る

predict(cxfit,y,type="risk") # yのstatusが「1」となるリスク

5

1.027764

y$status

[1] 2

#「predict(cxfit,y,type="risk")が1より大きいが、y$statusは「2」なのでpredictと一致しない」

と思っていたのですが -- akira 2009-11-17 (火) 21:44:32sibu (2009-11-16 (月) 15:01:39)

私はネットワーク分析でテキストマイニングを行おうとしているのですがー structure(.External("dotTclObjv", objv, PACKAGE = "tcltk"), class = "tclObj") : [tcl] bad screen distance "R_call 01C0BFF8 1.38998e+213raph".というエラーが出て分析することができないのです。

Rについては初心者でこのエラーが何を意味するかわかりません

どうかこのエラーの意味を教えてください。

ちなみに今回のネットワーク分析ではigraphとtcltkを使っています。

sakura (2009-11-15 (日) 18:37:09)

epiRにあるcmh.testとmantelhaen.test(stats)では微妙に結果が違うのは何故でしょうか?

cmh.test {lawstat} R Documentation

The Cochran-Mantel-Haenszel Chi-square Test

Description

This function performs the Cochran-Mantel-Haenszel (CMH) procedure. The CMH

procedure tests independence of two variables in each stratum, conditionally

on the levels of a third variable. This procedure is widely used in various

law cases, in particular, on equal employment and discrimination, as well in

biopharmaceutical studies (Agresti, 2002; Gastwirth, 1984; Hall et al., 1999).

mantelhaen.test {stats} R Documentation

Cochran-Mantel-Haenszel Chi-Squared Test for Count Data

Description

Performs a Cochran-Mantel-Haenszel chi-squared test of the null that two

nominal variables are conditionally independent in each stratum, assuming that

there is no three-way interaction.

単に,オンヘルプをコピーしただけの河童でした。> cmh.test(blackhire

Cochran-Mantel-Haenszel Chi-square Test

data: blackhire

CMH statistic = 145.840, df = 1.000, p-value = 0.000, MH Estimate =

0.477, Pooled Odd Ratio = 0.639, Odd Ratio of level 1 = 1.329, Odd

Ratio of level 2 = 0.378, Odd Ratio of level 3 = 0.508, Odd Ratio of

level 4 = 0.357, Odd Ratio of level 5 = 0.209, Odd Ratio of level 6 =

0.412, Odd Ratio of level 7 = 0.250, Odd Ratio of level 8 = 0.820

> mantelhaen.test(blackhire)

Mantel-Haenszel chi-squared test with continuity correction

data: blackhire

Mantel-Haenszel X-squared = 145.2466, df = 1, p-value < 2.2e-16

alternative hypothesis: true common odds ratio is not equal to 1

95 percent confidence interval:

0.4225550 0.5395037

sample estimates:

common odds ratio

0.4774621

カイ二乗値が 145.84 と 145.2466 の違いなんですね??たいへんだあ> mantelhaen.test(blackhire,correct=FALSE)

Mantel-Haenszel chi-squared test without continuity correction

data: blackhire

Mantel-Haenszel X-squared = 145.8403, df = 1, p-value < 2.2e-16

alternative hypothesis: true common odds ratio is not equal to 1

95 percent confidence interval:

0.4225550 0.5395037

sample estimates:

common odds ratio

0.4774621

このような確認は,必要だと思う人(ユーザ)が自分でやることかなあ。どこかに書いておいてくれればよいことでしょうけど。そのようなものがないときは,こんな風にすれば,確認できるでしょうという筋道の例示としては存在意義があるのかなあ? -- 推測力に乏しい河童の屁 2009-11-15 (日) 19:47:59きむ (2009-11-13 (金) 19:14:43)

少しづつRを使い始めています。

過去のQ&AやTipsを見たのですが、見つけきれませんでしたので、教えてください。

以下の様な2つのデータフレームがある場合、DB1(の行名)のうち、DB2(の行名)に含まれるものだけ抽出して新しいデータフレームDB3を作成するにはどのようにすれば良いでしょうか?

(例の場合、a,c,eだけのデータフレームにしたい)DB1 <- as.data.frame(matrix(1:10,ncol=2)) rownames(DB1) <- letters[1:5] DB2 <- as.data.frame(matrix(101:110,ncol=2)) rownames(DB2) <- letters[c(1,3,5,7,9)]行名ではなく、要素であれば参照する方法はQ&Aで確認できたのですが、、行名の引用方法がわかりません。行名を要素に追加してからハンドリングすれば良いのかも知れませんが、行名を直接引用する方法があれば教えてください。

(ついでに、)同様に、行名でDB1に、DB2の値をリスト参照・追加して、DB3を作成することは可能でしょうか?

(DB1のa,c,eにDB2の要素値を追加する:EXCELのVLOOKUPのイメージ)

以上、

かなり基本的な質問かと思いますが、よろしくお願いいたします。

> DB1 V1 V2 a 1 6 b 2 7 c 3 8 d 4 9 e 5 10 > DB2 W1 W2 c 102 107 g 104 109 i 105 110 a 101 106 e 103 108 > db1 <- data.frame(ID=rownames(DB1), DB1) > db2 <- data.frame(ID=rownames(DB2), DB2) > db3 <- merge(db1, db2) > rownames(db3) <- db3[,1] > db3 <- db3[-1] > db3 # 正しい答えは,これです V1 V2 W1 W2 a 1 6 101 106 c 3 8 102 107 e 5 10 103 108

motok (2009-11-13 (金) 14:37:25)

あるイベントが発生した時刻を "2009.11.13 14:32" の形で1行に1個づつ記録したデータファイルがあります。同じ時刻(1分以内)にイベントが発生すると、その時刻が2個3個と記録されます。

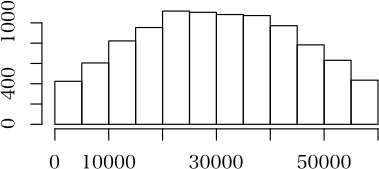

このデータファイルから例えば5分刻みのイベント発生頻度を数えてヒストグラムにしたいのですが、ちょっと手も足も出ていません。mydata <- read.table("test.dat", sep=",") names(mydata) <- c("event") attach(mydata) x <- strptime(event, format="%Y.%m.%d %H:%M")として文字列を時刻オブジェクト(?)にしたところで立ち往生しています。

なにかヒントを頂けるととてもうれしいです。

# FAQでないことをいのりつつ。

as.POSIXct("2009-11-13 12:45:35 JST") + sample(10, 5, replace=TRUE)

のようにするほうが,再現性を保証するためにはよいだろうけど。 -- 河童の合羽も雨に濡れ 2009-11-13 (金) 16:30:22

> x <- sort(Sys.time()-sample(3600, 2000)-10000, replace=TRUE) > head(x) # 以下のようなフォーマットです(このほかにも許容されるフォーマットがある) [1] "2009-11-13 12:45:35 JST" "2009-11-13 12:45:36 JST" "2009-11-13 12:45:38 JST" [4] "2009-11-13 12:45:39 JST" "2009-11-13 12:45:41 JST" "2009-11-13 12:45:43 JST" > y <- difftime(x[-1], x[-2000], units="secs") # 時間の差をとる(単位は sec で) > head(y) Time differences in secs [1] 1 2 1 2 2 1 > hist(y, breaks=c(seq(0, 20, by=1))) # 階級幅はお好きなように

主成分分析初心者 (2009-11-10 (火) 17:03:08)

Rコマンダーを使用し、主成分分析を行ってます。手順は、コマンダーで、エクセルを読み込んで、主成分分析を行い、寄与率をエクセルにコピペしている初心者です。

変数が多くなり(40変数)どれが、有効な変数なのか、苦戦しております。

現在は、コマンダーで出た、Dataset <- sqlQuery(channel = 1, select * from [Sheet3$]) .PC <- princomp(~変数1+変数2+・・・・+変数40, cor=TRUE, data=Dataset) unclass(loadings(.PC)) # component loadings .PC$sd^2 # component variances summary(.PC) # proportions of variance remove(.PC)をもとに、エディターで、

princomp(~○○, cor=TRUE, data=Dataset)○○部分を書き換えやっていましたが、40変数より39、38・・・とやっていこうとすると膨大なパターンを行わなくてはいけず、困っています。

出来ましたら、組み合わせ的に、40変数より、変数39の時の計算方法39通りでの、第一主成分の寄与率が、保存できる方法がありましたら、どなたか教えて頂きたく、思います。よろしくお願いいたします。

set.seed(123456789) # 毎回同じデータが得られるように,乱数の初期値を設定

d <- matrix(rnorm(4000), 100) # 100x40のデータ行列(データフレームでもよい)

r <- cor(d) # すべての変数を使って相関係数行列を計算しておく

sapply(1:40, # 1 番目から 40 番目の変数に対して順に以下を行う

function(i) {

r2 <- r[-i, -i] # i 番目の変数を除いたときの相関係数行列

v <- eigen(r2)$value # 固有値ベクトルを v に付値

return(v[1]/39) # 1 番目の固有値を 39 で割ったものが,第 1 主成分の寄与率

}

)

答えは以下のようになります

[1] 0.06285943 0.06326298 0.06333256 0.06192062 0.06229890 0.06145829

中略

[37] 0.06249882 0.06298219 0.06305921 0.06190447

なお,このプログラムは,元の 40 個の変数が欠損値を含まないことを前提にしています。欠損値を含むときには相関係数行列を求めるときに,欠損値を含まないデータだけを使って相関係数行列を求めるようにしてください。set.seed(987654321) # 乱数初期化

nv <- 10 # 変数の個数(ほどほどにしないと,死んでも終わらない)

d <- matrix(rnorm(100*nv), 100) # 100xnv データ行列

r <- cor(d) # 元の相関係数行列

var.no <- paste("V", 1:nv, sep="") # 変数番号(どの変数が使われた分析か示すために)

n <- 2^nv # 組み合わせの数

bincomb <- matrix(FALSE, nrow=n, ncol=nv) # 組み合わせの生成

for (j in 1:nv) {

bincomb[, j] <- rep(c(rep(FALSE, n/2^j), rep(TRUE, n/2^j)), length = n)

}

bincomb <- bincomb[-1,] # どの変数も使われない場合を除く

n <- n-1

result <- numeric(n) # 結果の保存

vars <- character(n) # 分析に使った変数名の保存

for (i in 1:n) {

sel <- bincomb[i,] # どの変数が使われたかの論理ベクトル

vars[i] <- paste(var.no[sel], collapse=",") # 変数名記録

if (sum(sel) >= 2) {

result[i] <- eigen(r[sel, sel])$val[1]/sum(sel) # 結果の記録

}

else {

result[i] <- NA

}

}

RESULT <- data.frame(vars, result) # 結果をデータフレームにして,

o <- order(RESULT$result, decreasing=TRUE) # 寄与率の大きい順に並べ替えて,

RESULT[o,] # 表示

以下のようなものが1023行も出ます

vars result

72 V4,V7 0.6079310385256367

260 V2,V8 0.5864172084814746

514 V1,V9 0.5793448970957535

36 V5,V8 0.5781238621539512

272 V2,V6 0.5730279383691933

:

959 V1,V2,V3,V5,V6,V7,V8,V9,V10 0.1507698641888030

1015 V1,V2,V3,V4,V5,V6,V8,V9,V10 0.1506910833840152

1023 V1,V2,V3,V4,V5,V6,V7,V8,V9,V10 0.1392082155345871

以下ゴミの行が変数の個数分続く初心者 (2009-11-08 (日) 11:41:34)

R + eclipse + StatET を導入して、無事、eclipse 上で R のコードを実行できるようになったのですが、

ブレークポイントを置いてデバッグするということはできません。

(ブレークポイントはおけるのですが、デバッグモードで R を起動できません)

これは設定が足りないだけなのでしょうか、それともそこまで StatET がサポートしていないのでしょうか。

R : 2.10.0, eclipse : 3.5.1, StatET : 0.8.0

よろしくお願いします。

きむ (2009-11-05 (木) 19:38:58)

かなりの初心者です。

windowsXPでRのver2.9.0を仕様しています。

データフレームのラベル設定に関する質問です。

いくつかのデータフレームを結合して一つのデータフレームにしようとしています。その際に、基のデータフレーム(名)を持った形で作成したいのですが、どのようにデータフレームを作成すれば良いでしょうか?

イメージしているのは、例えばライブラリ[kohonen]のサンプルデータ(nir)です。

spectra,composition, temperature, trainingといったカテゴリー?の下に個々にデータセットを有する形となっています。

(data(nir)とすることで、nir$spectra等でのハンドリングが可能)

例えば、以下のA、BというデータフレームからCを作成する場合に、どのような手順で処理を行えば上記例のようなデータフレームが作成できるのでしょうか?

(ex C$A,C$Bという形でハンドリングしたい)

(データセットのラベルはC$A.a, C$A.b, のように)

A <- data.frame(a=c(1, 2, 3), b=c(0, 0, 0))

B <- data.frame(a=c(4, 5, 6), b=c(1, 1, 1))

C <- cbind( A, B )

単純に上記のようにデータフレームを作成・結合し、paste関数とcolname関数を用いて(A.a, A.b,B.a,B.b)を与えてみたりしたのですが、うまくいきません。

(そもそも上記「nir」はdata関数が使えますが、上記で作成した「C」は使えません。)

(←作成したデータフレームをデータセットとして設定しないといけないのかもわかりませんが、その方法がわかりません。)

以上、

かなりまとまりのない質問ですみません。要は「nir」のようなデータフレームを作成する手順がわかりません。よろしくお願いします。

library(kohonen) data(nir) class(nir)nirのようなlistがつくりたい、ということであれば、

A <- data.frame(a=c(1, 2, 3), b=c(0, 0, 0)) B <- data.frame(a=c(4, 5, 6), b=c(1, 1, 1)) (C <- list(A=A, B=B))でよろしいかと。 それとも、きむさんが必要としてるのは

C <- cbind(A, B)

names(C) <- c("A.a", "A.b", "B.a", "B.b")

みたいなものなのかな。

nirのような「list」が得たいのか、C$A.a, C$A.b…のようなラベルが付いた「data.frame」が得たいのか、ちょっと分からないですけれども。 -- 2009-11-05 (木) 20:19:33> A <- data.frame(a=c(1, 2, 3), b=c(0, 0, 0)) # コメントが,遅かりし? > B <- data.frame(a=c(4, 5, 6), b=c(1, 1, 1)) > C2 <- data.frame(A, B) # データフレームの結合には,data.frame を使う,そうすれば,,,, > C2 # のように,同じ名前の列名は修飾されるので,識別可能となる a b a.1 b.1 1 1 0 4 1 2 2 0 5 1 3 3 0 6 1 > C2$a # C2$a と [1] 1 2 3 > C2$a.1 # C2$a.1 は,別物なんだ [1] 4 5 6 # でもね,その違いは些細なものなんだから,そんなのに依存して区別するのも考えもの

coro (2009-10-31 (土) 01:50:23)

初心者です。このような質問をするのは恥ずかしい限りです。

windowsXPでversion2.3.0を使用しております。

作成した曲線と任意のX軸と曲線との垂直交点の値(Y値)を求める方法を探しております。